Microsoftが推進するAI事業 NVIDIAとの協業の成果は(2/2 ページ)

Copilot、プラグイン、Copilot stack

野崎氏はMicrosoftが展開するCopilotについて、「Copilotは“副操縦士”という意味で、複雑なタスクをアシストするアプリケーションのことだ。ユーザーとの対話やコミュニケーションを通してビジネスを広げる役割を担う」と説明した。

MicrosoftはCopilotシリーズとして、「Microsoft 365 Copilot」「Dynamics 365 Copilot」「Copilot in Power Platform」「Microsoft Security Copilot」「Windows Copilot」「GitHub Copilot」の6つを持つ。

「SaaSやOS、開発プラットフォームなど、幅広く生成AIが採用されている。Copilotを利用できるサービスは今後も拡張されるだろう」(野崎氏)

GitHub Copilotについてはギットハブ・ジャパンの山銅章夫氏(リージョナルセールスディレクター)が登場し、「企業や個人、コミュニティーが長年蓄積した知識を、安全にお互いが活用できるようにするのがGitHub Copilotだ。あらゆるレベルの開発者の生産性を向上させる開発支援ツールになる」と述べた。

同氏によれば、世界の1万を超える組織がGitHub Copilotを利用しており、46%以上の新たなコードがAIによって書かれている。また、開発者の75%が「仕事に集中できている」と、96%が「反復作業をより速くこなしている」と感じている。

「近い将来には80%のコードがCopilotで書かれるだろう。コーディングの生産性向上だけでなく、バグの減少や学習体験の向上といったメリットもある。その中で最も重要な成果は開発者の集中力が高まっている点だ」(山銅氏)

野崎氏はプラグインを「タスクを実施するのに必要な計算処理であり、APIを通じてアプリケーションから有益な情報を取得する機能」と定義した。

「Copilotで対応できないこともプラグインであれば実現できる。現在のプラグインは今後形成されるプラグインエコノミーの始まりにすぎない」(野崎氏)

日本におけるプラグイン活用は活発になっている。その一つの例が「価格.com」だ。価格.comはプラグインによって、ユーザーが希望の商品やカテゴリー、メーカー、レストラン、旅行プランを指定すればそれに沿って提案する機能を実装した。

野崎氏はMicrosoftが2023年2月に発表した新たな「Microsoft Bing」(以下、Bing)にも言及した。新たなBingは「GPT-4」を採用した他、画像生成や履歴管理など日々進化しており、野崎氏によれば71%以上のユーザーが検索結果や回答に満足しているという。

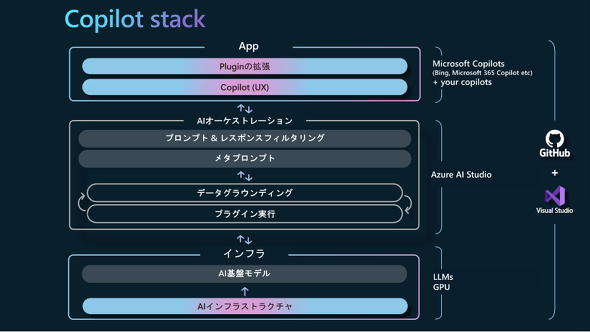

Microsoft Build Japanの1日目に発表された「Copilot stack」について野崎氏は、「Copilot stackは大規模言語モデルを使ってサービスを開発する全てのビジネスユーザーやエンドユーザーに必要な考え方を共通項としてまとめ、フレームワーク化したもの」と定義した。

Copilot stackはCopilotやプラグインなどで構成されるアプリケーションレイヤー、プロンプトやフィルタリングなどで構成されるミドルレイヤー、AI基盤モデルや学習および推論のためのGPUなどのインフラレイヤーで構成される。

野崎氏はインフラレイヤーに関する2つの説明を行った。

1つ目は「Azureを運用するデータセンターへの投資」だ。

Microsoftは世界に65以上のAzureリージョン、200以上のデータセンター、17万5000マイル以上のファイバーを持ち、最新設備となる第4世代データセンターでは気化熱を利用したユニットサイズが小さいクーリングシステムを採用している。

生成AIの利用が拡大し、2023年はデータセンターのトランザクション数が急増しているという。「Azure Storage」の月間トランザクション数は1153兆に、「Azure Machine Learning」の月間処理数は4700億に達している。

「データセンターにおけるストレージ制御もハードウェア処理に移行し、FPGA(現場で書き換え可能な論理回路の多数配列)による高速化を実現している。これによりデータベース処理のパフォーマンスを向上している。AIの潜在能力を発揮するにはクラウドのスケールと処理能力向上が必要だ。今後必要とされるコンピューティング能力は10〜50倍になるとも言われ、AIに最適化されたAzure仮想マシンと環境整備が必要になる」(野崎氏)

Microsoftはデータセンターへの投資計画として、日本の西日本リージョンに大型投資を行い、複数のデータセンターの建設を明らかにした。アジア圏でも新たなリージョンをインドネシアやマレーシア、ニュージーランド、台湾、インドに設置する。

2つ目は「NVIDIAとの連携」だ。

野崎氏は仮想マシン「Azure ND H100 v5」について、「これは生成AIを支える高いパフォーマンスを提供するカスタムAIインフラであり、大規模で複雑なAIモデルをトレーニングが可能になる」とした。

NVIDIA Japanの井崎武士氏(エンタープライズ事業本部 事業本部長)も基調講演の登壇し、「2022年に投入した『NVIDIA H100』は、従来の『NVIDIA A100』に比べて演算性能は3倍となり、処理性能は6倍向上する。世界のAIインフラを支える新たなエンジンになる」と述べた。

両社は「NVIDIA AI Enterprise」をAzure Machine Learningに統合し、「Azure Market Place」でも利用可能にした。また、メタバース環境を構築するための「NVIDIA Omniverse Cloud」と、AIスーパーコンピューティングサービス「DGX Cloud」がAzureで利用できるとした。

野崎氏は最後に「MicrosoftとAIを活用し、ソフトウェア開発をより良いものにしてほしい」と話し、講演を終えた。

関連記事

「Windows 10のサポート終了をDX推進に利用しない」 日本マイクロソフトの“スタンスが変わった”ワケ

「Windows 10のサポート終了をDX推進に利用しない」 日本マイクロソフトの“スタンスが変わった”ワケ

中堅・中小企業におけるDXは生成AIなどの登場で進展する可能性がある。その中で日本マイクロソフトが取り組むこととは。 Microsoft Build Japanが開催 企業のAI活用を支援する新たな取り組みを紹介

Microsoft Build Japanが開催 企業のAI活用を支援する新たな取り組みを紹介

生成AIの活用を推進する企業が増えている。Microsoftはそんな企業をサポートするためにさまざまなサービスを打ち出している。本稿はMicrosoft Build Japanの基調講演で発表された2つの新サービスを紹介する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- ホワイトハッカーが明かす「ランサムウェア対策が破られる理由」と本当に効く防御

- ドローンいらず? 飛行動画作成できる「Google Earth Studio」登場

- 7-Zipの偽Webサイトに注意 PCをプロキシノード化するマルウェア拡散

- 一気読み推奨 セキュリティの専門家が推す信頼の公開資料2選

- 「SaaSの死」騒動の裏側 早めに知るべき“AIに淘汰されないSaaS”の見極め方

- Claude拡張機能にCVSS10.0の脆弱性 現在も未修正のため注意

- NTTグループは「AIがSI事業にもたらす影響」をどう見ている? 決算会見から探る

- 米2強が狙う“AI社員”の普及 Anthropicは「業務代行」、OpenAIは「運用プラットフォーム」

- 2026年はAGIが“一部実現” AIの革新を乗りこなすための6つの予測

- 500万件のWebサーバでGit情報が露出 25万件超で認証情報も漏えい

ギットハブ・ジャパンの山銅章夫氏

ギットハブ・ジャパンの山銅章夫氏

NVIDIA Japanの井崎武士氏

NVIDIA Japanの井崎武士氏