大規模言語モデルのセキュリティを確保 ツールキット「LLM Guard」が公開:セキュリティニュースアラート

大規模言語モデルのセキュリティを向上させるオープンソースツールキット「LLM Guard」がGitHubで公開された。LLM開発時のセキュリティ課題の解消が期待される。

この記事は会員限定です。会員登録すると全てご覧いただけます。

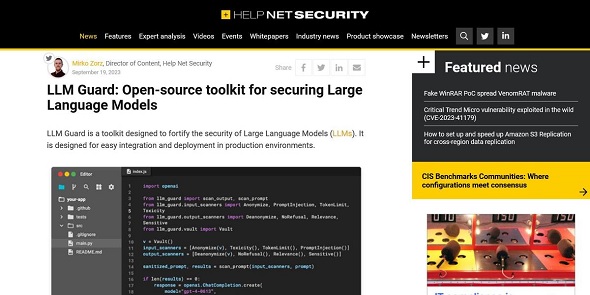

コンピュータ情報サイトの「Help Net Security」は2023年9月19日(現地時間)、大規模言語モデル(LLM)のセキュリティ強化に向けたオープンソースツールキット「LLM Guard」が「GitHub」で公開されたと伝えた。

LLM GuardはAIセキュリティをどう変革するのか?

このツールはMITライセンスの下、オープンソースソフトウェア(OSS)として公開されており、「ChatGPT」「Bard」「Claude」などさまざまな生成AI(人工知能)ツールで使用できる。

2022年11月にChatGPTが登場してから、この技術が業務改善に大きな可能性を秘めていることを多くの企業が認識するようになった。こうした技術の導入を開始した企業の中には既に大きな成功を収めているものもある。しかし依然としてLLMを業務改善につなげられていない企業も存在する。LLM Guardはこうした企業を支援するために開発されたという。

LLM GuardはLLMの入出力の双方に対して広範囲な評価器を提供する。このツールキットを使うことでサニタイズや有害な言語、データ漏えいの検出、プロンプトインジェクションやジェイルブレーク攻撃への防御などを講じられる。さまざまなサービスに利用できる他、本番環境への統合や展開が容易にできるように設計されている。

LLM Guardを利用することでLLMを実装する際に問題になりがちなセキュリティリスクやコントロール、可視性の欠如などに対応できるようになる。

関連記事

AIを狙ったサイバー攻撃の知られざる世界 専門知識なしでどう対処するか?

AIを狙ったサイバー攻撃の知られざる世界 専門知識なしでどう対処するか?

生成AIブームが訪れ、各企業がAI開発に乗り出しているが、AI開発プロセスには脆弱性が潜んでおり、これを悪用することでサイバー攻撃が可能になることは意外と知られていない。攻撃の詳細とそれを防御するための方法を解説する。 AIを使えば標的型攻撃が“超簡単”に 5つの要素で攻撃に対処せよ

AIを使えば標的型攻撃が“超簡単”に 5つの要素で攻撃に対処せよ

ChatGPTを悪用したサイバー攻撃にわれわれはどう対抗すればいいのか。AIを使った電子メール経由の攻撃を例に、これを防ぐ上で重要になる5つの要素を紹介しよう。 MicrosoftのAI研究者が誤って38TBのデータを公開 AI時代に企業が気を付けるべきこととは

MicrosoftのAI研究者が誤って38TBのデータを公開 AI時代に企業が気を付けるべきこととは

WizはMicrosoftのAI研究者がGitHubに38TBのデータを誤って公開したと報じた。SASトークンの設定ミスが原因だと指摘されていて、AI技術採用とセキュリティリスクへの対策が説明されている。 NISTのサイバーセキュリティフレームワークが大幅改訂 何が追加されるのか?

NISTのサイバーセキュリティフレームワークが大幅改訂 何が追加されるのか?

NISTはサイバーセキュリティフレームワーク2.0のドラフト版を発表した。改訂は2014年以来で、現状に即したセキュリティ実装に向けて大規模な項目の追加が予想される。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- SMBC日興証券が「パスキー」で口座乗っ取り対策 約5カ月で実現したのはなぜ?

- 初期侵入口は“またVPN” 日本医大武蔵小杉病院にランサムウェア攻撃

- 生成AIの記憶機能を悪用して特定企業を優遇 50件超の事例を確認

- 悪いのは本当にVPN? 日本医科大武蔵小杉病院のランサムウェア事件をダークWebから解明

- 日本IBMのAI戦略“3つの柱” 「制御できるAI」でレガシー資産をモダナイズ

- アサヒGHDがランサムウェア被害の調査報告書を公開 152万の個人情報が漏えいの恐れ

- 「2027年1月12日」は運命の日? サポート切れOSを使い続ける会社の末路

- 人材水準を4段階で評価 「サイバー人材フレームワーク」案の意見公募を開始

- 「英数・記号の混在」はもう古い NISTがパスワードポリシーの要件を刷新

- 「AI前提」の国家戦略と「思考停止」の現場 大半の企業で“何も起きない”未来を予見