富士通、1ビット量子化と特化型AI蒸留でLLMを軽量化 メモリ消費量削減しつつ精度は維持:AIニュースピックアップ

富士通は生成AI「Takane」を軽量・省電力化する新技術を発表した。1ビット量子化と特化型AI蒸留を中核とし、GPU使用量やメモリ消費を削減しつつ高精度を維持しているという。

この記事は会員限定です。会員登録すると全てご覧いただけます。

富士通は2025年9月8日、生成AIの軽量化と省電力化を実現する新技術「生成AI再構成技術」を開発し、自社の大規模言語モデル(LLM)「Takane」を強化したと発表した。同技術の中核となるのは、世界最高精度をうたう1ビット量子化技術と、軽量化と精度向上を両立させる特化型AI蒸留技術だ。これにより、Takaneは従来のGPU4枚を要する規模のモデルを、GPU1枚で高速かつ高精度に実行可能となった。

生成AIの軽量化、高精度化に成功、新技術「生成AI再構成技術」発表

量子化技術を適用したTakaneは、メモリ消費量を最大94%削減しつつ、精度維持率89%を達成し、推論速度は量子化前の3倍に高速化されているという。従来の主流手法「GPTQ」(モデル名「GPT」と量子化技術「PTQ」《Post-Training Quantization》を組み合わせた名称)の精度維持率が20%以下にとどまるのに対し、本技術はそれを上回る成果を示している。この軽量化により、スマートフォンや工場設備などエッジ環境でのAIエージェント稼働が可能となり、応答性やセキュリティ強化、運用時の電力削減にも寄与するという。

本技術は以下2つのコア技術から成る。

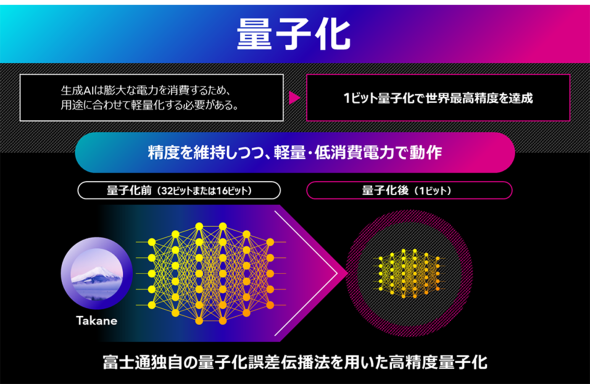

一つは「量子化技術」であり、大規模モデルにおける膨大なパラメーター情報を効率的に圧縮することで、モデルを小型化しつつ精度を維持する。従来は層が深いニューラルネットワークにおいて量子化誤差が蓄積する課題があったが、富士通は誤差を層間で制御するアルゴリズム「QEP」(Quantization Error Propagation)を開発し、この問題を克服した。また自社の最適化アルゴリズム「QQA」(Quasi-Quantum Annealing)を活用し、1ビット量子化を実現した。

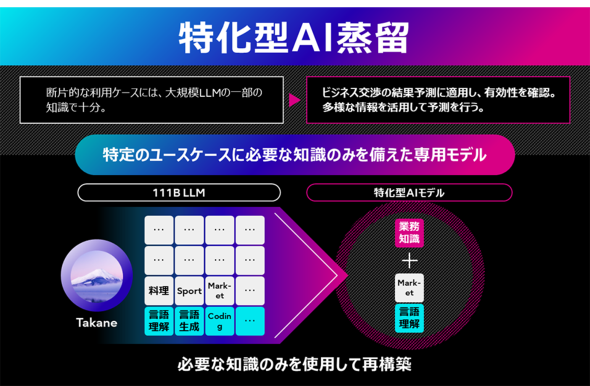

もう一つは「特化型AI蒸留技術」だ。これは基盤モデルから不要な知識を削除し、必要な能力を強化した上で、複数の候補構造を生成し、顧客要件に合致するモデルを自動選定する仕組みだ。その後、教師モデルから知識を蒸留することで、特定タスクにおいて基盤モデルを超える精度を持つ軽量モデルを構築できる。実証において、商談勝敗予測タスクにおいて推論速度を11倍にしつつ精度を43%改善し、GPUメモリ使用量と運用コストを7割削減する成果が得られた。画像認識タスクにおいても、既存蒸留技術と比較して未学習物体の検出精度を10%向上させている。

富士通は、この技術を適用したTakaneのトライアル環境を2025年度下期から順次提供する予定だ。Cohereの研究用オープンウェイトモデル「Command A」を量子化したモデルを、「Hugging Face」を通じて公開するとしている。

このような取り組みの背景には、LLMの大規模化が進み、多数の高性能GPUを必要とすることによる、開発、運用コストや環境負荷の増大がある。特定領域に特化した高精度かつ軽量なモデルのニーズも高まっている。この技術はそうした要請に応えるものであり、金融や製造、医療、小売といった業種ごとに適したAIエージェントの開発が可能になるとされる。

富士通は今後、モデルのメモリ消費量を最大1000分の1に削減しつつ精度を維持する研究を推進する。将来的には複雑な因果関係を理解し、自律的に最適な解決策を提示できるAIアーキテクチャへ発展させることを目指し、持続可能で高効率な生成AIの社会実装を推進する構えを示している。

関連記事

ハルシネーションはなぜ起きるのか OpenAIの研究が示す「正答率信仰の罠」

ハルシネーションはなぜ起きるのか OpenAIの研究が示す「正答率信仰の罠」

OpenAIは大規模言語モデルにおける「幻覚」(ハルシネーション)問題について、学習構造と評価方法に起因することを明らかにした。推測を優先する評価体系が誤答を助長し、正答率のみを重視する現行のベンチマークでは信頼性が損なわれると指摘している。 「オンプレミス版Gemini」提供開始 KDDIが初期導入に参加

「オンプレミス版Gemini」提供開始 KDDIが初期導入に参加

Googleが生成AI「Gemini」を、Google Cloudのオンプレミス延伸環境であるGDCでも提供する。GovTech Singaporeなどの他、日本からはKDDIが初期導入に参加する。 国内AIエージェント基盤市場が8倍に急拡大 2029年度に市場規模135億円予想

国内AIエージェント基盤市場が8倍に急拡大 2029年度に市場規模135億円予想

ITRは、AIエージェント基盤市場が2024年度に前年度比8倍の1億6000万円に成長し、2029年度には135億円に達すると予測している。生成AIの進展により、業務自動化手段としての注目が高まり、クラウド、SaaSベンダーの参入も増えている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- ホワイトハッカーが明かす「ランサムウェア対策が破られる理由」と本当に効く防御

- ドローンいらず? 飛行動画作成できる「Google Earth Studio」登場

- 7-Zipの偽Webサイトに注意 PCをプロキシノード化するマルウェア拡散

- 一気読み推奨 セキュリティの専門家が推す信頼の公開資料2選

- 「SaaSの死」騒動の裏側 早めに知るべき“AIに淘汰されないSaaS”の見極め方

- Claude拡張機能にCVSS10.0の脆弱性 現在も未修正のため注意

- NTTグループは「AIがSI事業にもたらす影響」をどう見ている? 決算会見から探る

- 米2強が狙う“AI社員”の普及 Anthropicは「業務代行」、OpenAIは「運用プラットフォーム」

- 2026年はAGIが“一部実現” AIの革新を乗りこなすための6つの予測

- 500万件のWebサーバでGit情報が露出 25万件超で認証情報も漏えい