「対応しなきゃ」では手遅れになるかも AIセキュリティへの解像度を上げよう

生成AI活用が進む一方で、AIそのものを守るセキュリティ対策については意識が向いていない企業もある。本稿はパブリックAI/プライベートAIでそれぞれ起きがちなリスクを整理し、目指すべき対策の方向性を示す。

この記事は会員限定です。会員登録すると全てご覧いただけます。

AIの台頭はサイバーセキュリティ対策にも大きな影響を及ぼしている。生成AIを悪用した高度な攻撃が常態化する一方で、AIモデルの改ざんやプロンプトインジェクションなど、AIそのものを標的とする攻撃も急増している。企業にとって「AIを守る」こと自体が喫緊の課題となる日も近いだろう。

Dell TechnologiesでグローバルCTO(最高技術責任者)兼CAIO(最高AI責任者)を務めるジョン・ローズ氏は、セキュリティの構図が「人間 vs. AI」から「AI vs. AI」へと移りつつあると指摘する。AIが攻撃にも防御にも使われる時代、企業はいかに備え、どこまでを自ら制御すべきなのか──。「Dell Technologies Forum 2025」に合わせ来日した同氏に話を聞いた。

AI活用におけるリスクの発生源をどこまで理解していますか?

企業のAI導入が進む一方で、AIそのものを狙った攻撃が急増している。金融機関などで稼働する数万の予測AIモデルには、モデルファイルに悪意あるコードを埋め込む「モデル汚染(model poisoning)」や、特定の入力で不正動作を誘発する「ニューラルバックドア攻撃」が確認されている。さらに、エージェントAI(自律実行型AI)を狙った攻撃ではプロンプトインジェクションによる情報漏えいや、外部命令の誤実行に起因する法的リスクの発生が報告されている。

「AIセキュリティを一枚岩で捉える時代は終わりました。もはや“単一のリスクモデル”では通用しません。AIの仕組み自体が複雑化しています。データの供給元やAPIを介した通信経路、モデルの学習や推論環境など、これら全てがリスクの発生源になり得るのです」(ローズ氏)

特にクラウドのパブリックAIサービスと自社内のプライベートAI環境とでは、想定すべきリスクの種類も対処のアプローチも異なる。前者はデータ漏えいや知財流出、後者は可用性や復旧力の確保といった課題が中心となる。ローズ氏は「今後、企業はAIを単一の仕組みとして守るのではなく、構成要素ごとに異なる防御戦略を構築する必要があります」と指摘する。

パブリックAIでは「ちょっとしたミス」で致命傷になる

では、パブリックAIとプライベートAIでは具体的にどのようなリスクが存在するのか。パブリックAIのリスクについてローズ氏は「AIを自社でコントロールできない環境に依存することこそが、現代のAIセキュリティにおける最大の落とし穴」だと力説する。

生成AIサービスがAPI経由で提供される環境では、利用者が意図せず企業の重要情報を外部に送信してしまうリスクが顕在化している。AIモデルプロバイダーがクラウドでAI機能を提供する構造そのものが、セキュリティリスクを内包しているのだ。「第三者があなたのデータを保持しており、意図せず何かをしてしまう可能性があるのです」(ローズ氏)。

実際、2025年の夏には「ChatGPT」の共有リンク機能を巡り、ユーザーの会話が検索エンジンにインデックスされる事例が報じられた。これは共有リンク生成時に「Make this chat discoverable(検索可能化)」オプションをユーザーが有効にした場合、クローラがURLを収集できる設計だったことが原因とされている。

このインシデントはユーザーの設定ミスが引き金となったが、ChatGPTのUI設計の分かりにくさや説明文の曖昧(あいまい)さも指摘された。ユーザーが判断を誤れば、機密情報が意図せず外部に露出する。ローズ氏は「自社で制御できないAIを使う限り、ちょっとしたミスでデータを世界にさらすことになるのです。そして、こうしたミスが企業にとって致命的な結果を招くこともあります」と警鐘を鳴らす。

弁護士事務所のような規制産業では、依頼案件の内容をAIに入力するだけで守秘義務違反に発展する可能性もある。製造業や金融、行政でも同様に、設計情報や個人データの漏えいは致命的だ。ローズ氏は「個人利用なら恥ずかしい程度で済むかもしれませんが、法務などの規制産業では致命的な結果を招きかねません。ミッションクリティカルなAIを運用する企業にとっては、自社でインフラを保有・運用し、セキュリティアーキテクチャを管理できる利点を理解すべきです」と指摘した。

一方、データやモデルを自社で保持する「プライベートAI」では、リスクの性質がパブリックAIとは根本的に異なる。ローズ氏は「プライベート環境でのAI利用における最大の脅威はデータ漏えいではなく、可用性(継続性)です。企業が自前でAIを運用する場合、外部リスクは抑えられます。一方、システム停止やランサムウェアによる暗号化といった事業継続性のリスク対策は、自社で講じる必要があります。AIシステムを運用する際には、AI基盤のレジリエンスなど、従来のITインフラと同じ水準の耐障害性とセキュリティを組み込まなければなりません」と説明する。

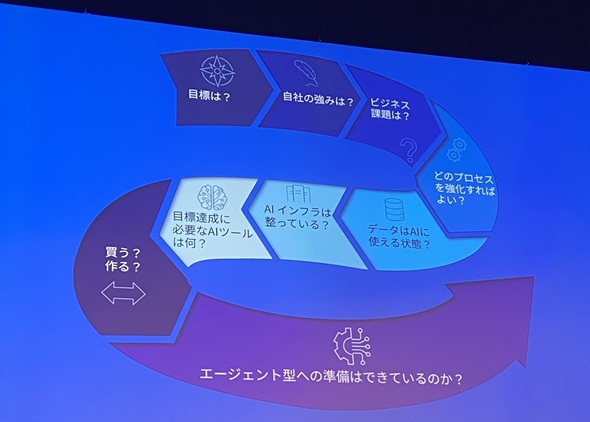

企業がAIを導入するフレームワーク。AIセキュリティの議論以前に、まずは「何を目指し」「どのプロセスをAIで強化するのか」を明確にすることが重要だ(出典:Dell Technologiesの講演資料)《クリックで拡大》

企業がAIを導入するフレームワーク。AIセキュリティの議論以前に、まずは「何を目指し」「どのプロセスをAIで強化するのか」を明確にすることが重要だ(出典:Dell Technologiesの講演資料)《クリックで拡大》業務知識を学習したAIモデルや意味情報を保持するベクターデータベース、データ間の関係を可視化するナレッジグラフなど、AIが生成・管理する資産は、企業の知的活動を支える重要資産だ。これらには業務ロジックや意思決定の根拠、顧客との関係性といった企業固有のノウハウが集約されており、単なる技術的データではない。

もしこれらの資産を失えば、ERPやCRMといった業務システムの停止を上回る深刻な影響が組織全体の判断や運営に及ぶ恐れがある。ローズ氏は「かつては『AIのモデルこそが資産』と言われていましたが、今やAIで生み出される全てのデータがミッションクリティカルな資産です」と指摘する。

AI時代のサイバー戦 人間は「介在」から「監督」する立場に

AIセキュリティのもう一つの焦点は、「AIを利用した攻撃手法の高度化と、それに対抗する防御側の自動化」だ。攻撃側と防御側の双方がAIを武器として活用する「AI同士の攻防戦」が主戦になりつつあるのだ。

ローズ氏は「セキュリティの戦場は『人間 vs. 人間』から『機械 vs. 機械』に移行しました。AIを駆使した攻撃は人間よりも高速で、精度の高い攻撃を自動で繰り返すことが可能です。これに対抗するため、防御側もAIによる自動検知・自動応答を取り入れざるを得なくなっているのです」と説明する。

従来のセキュリティ対策は「人間が最終判断を下す」ことを前提としていた。しかしAI攻撃のスピードは人間の判断の遅れを容易に突く。検知、分析、遮断、復旧といったプロセスを人が手動で実行するかぎり、防御側は常に後手に回る。ローズ氏は「AIの台頭によって、セキュリティ文化自体が変化しています」とし、次のように指摘する。

「かつてのセキュリティ対策は『Human-in-the-Loop(人が介在する運用モデル)』で、AIは補助的な存在でした。これが現在は『Human-on-the-Loop(人が監督する運用モデル)』へと移行しつつあります。AIが自動的に脅威を検知し、初期対応まで完結させ、人間は例外的なケースにのみ介入するというアプローチです。この変化がセキュリティ運用のスピードと精度を飛躍的に高めているのです」(ローズ氏)

一方でAI防御の導入には倫理的・法的な課題も伴う。AIが自動で通信を遮断したり、アクセスをブロックしたりといった処理を誤れば、業務停止や誤検知による混乱を招く可能性がある。

こうした事態を発生させないために不可欠なのが、AI活用のガイドラインと監査の枠組みだ。攻撃者がAIを武器として使う時代に防御側がAIを使わないという選択肢は現実的ではない。ローズ氏は「AIを安全に運用する上で重要なのは、識別、認可、監視、復旧といったセキュリティの基本原則を、AIにも当てはめることです」とし、以下のように説明した。

「当社の社内でAIエージェントが業務を実施するときには、従業員や委託業者と同様に会社が発行したIDを必ず付与し、アクセス権限や稼働状態を一元管理しています。AIを人間と同様の『管理可能な主体』として扱うことで、ガバナンスと安全性を両立しているのです。アクセス権の設定はセキュリティ対策の基本です。AI時代のセキュリティでも、それは変わりません。強力なツールであるほど、安全に実装されているかを常に確認する必要があります」(ローズ氏)

関連記事

「英数・記号の混在」はもう古い NISTがパスワードポリシーの要件を刷新

「英数・記号の混在」はもう古い NISTがパスワードポリシーの要件を刷新

NISTはパスワードポリシーに関するガイドラインSP800-63Bを更新した。従来のパスワード設定で“常識”とされていた大文字と小文字、数字、記号の混在を明確に禁止し、新たな基準を設けた。 日本企業はランサムウェアをナメている? 実態調査で分かった世界とのギャップ

日本企業はランサムウェアをナメている? 実態調査で分かった世界とのギャップ

バラクーダは、日本を含む世界各国におけるランサムウェアに関するグローバル調査結果を公開した。同調査では、ランサムウェア対策における日本企業の意識や実態がグローバル平均と比較して大きく下回ることが分かっている。 「社外メールは受信不可」 アサヒグループHDのシステム障害、原因はランサムウェア

「社外メールは受信不可」 アサヒグループHDのシステム障害、原因はランサムウェア

アサヒグループホールディングスは2025年9月に報告したサイバー攻撃によるシステム障害について、ランサムウェアによるものだと明らかにした。障害の発生したシステムの遮断措置など被害拡大防止や復旧に向けた取り組みを進めているという。 ホワイトハッカーが感心したフィッシング攻撃とは? 最新動向と対策を知る【動画あり】

ホワイトハッカーが感心したフィッシング攻撃とは? 最新動向と対策を知る【動画あり】

フィッシングの進化はとどまることを知りません。最近は生成AIの普及によってより高度な攻撃も登場しています。『攻撃者の目』の第5回はフィッシングの最新傾向やホワイトハッカーが感心した攻撃手法、根本的な対策を考えます。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 一気読み推奨 セキュリティの専門家が推す信頼の公開資料2選

- Fortinet、管理サーバ製品の重大欠陥を公表 直ちにアップデートを

- LINE誘導型「CEO詐欺」が国内で急増中 6000組織以上に攻撃

- 米2強が狙う“AI社員”の普及 Anthropicは「業務代行」、OpenAIは「運用プラットフォーム」

- 「SaaSの死」騒動の裏側 早めに知るべき“AIに淘汰されないSaaS”の見極め方

- 500万件のWebサーバでGit情報が露出 25万件超で認証情報も漏えい

- Claude拡張機能にCVSS10.0の脆弱性 現在も未修正のため注意

- 2026年はAGIが“一部実現” AIの革新を乗りこなすための6つの予測

- 住信SBIネット銀行、勘定系システムのクラウド移行にDatadogを採用

- ホワイトハッカーが明かす「ランサムウェア対策が破られる理由」と本当に効く防御

Dell TechnologiesでグローバルCTO(最高技術責任者)兼CAIO(最高AI責任者)を務めるジョン・ローズ氏(筆者撮影)

Dell TechnologiesでグローバルCTO(最高技術責任者)兼CAIO(最高AI責任者)を務めるジョン・ローズ氏(筆者撮影)