「4番目のクラウドプロバイダーは本当に必要か」 OCI“懐疑論”に対してOracleの新CEOが示した存在意義:Oracle AI World 2025

米Oracleの新体制を象徴する「Oracle AI World 2025」が開催された。新共同CEOクレイ・マグワイク氏がOCIの進化と未来を語った。ByteDanceやOpenAIといった先進企業の要求に応える、OCIの設計思想とAI時代への戦略に迫る。

この記事は会員限定です。会員登録すると全てご覧いただけます。

米Oracleが2025年10月13日(現地時間、以下同)に開催した「Oracle AI World 2025」の基調講演「Building the Cloud for You」は、同社の新しい経営体制を象徴するものだった。

同年9月22日付で共同CEOに就任したクレイ・マグワイク氏が登壇し、Oracle Cloud Infrastructure(OCI)の進化と未来を語った。Amazon Web Services(AWS)から移籍後、OCI部門の創設に携わった同氏は、技術的な知見を基に「OCI Gen2」の設計・実装と事業戦略を主導し、クラウド基盤を短期間でハイパースケーラーと同等の水準に引き上げた実績を持つ。

「想像し得る唯一ベストなクラウド」を目指したOCIの設計思想

マグワイク氏は講演の冒頭、OCIの存在意義を問いかけた。同氏がOracleに入社した2014年頃には、新たなクラウドサービス基盤を構築することは、方針として「明白な決定事項ではなかった」と振り返る。この頃は、「業界に4番目のクラウドプロバイダーは本当に必要か」との懐疑的な声も多かった。しかし、この決定は誤りではなかったという。彼は自身の経験から、業界には「異なるクラウドが必要」だったと述べた。

過去10年間、OCIのミッションは一貫しており、「可能な限り最高性能、最低コスト、最もセキュアなインフラストラクチャ」 、すなわち「競合他社より優れている」だけではなく、「想像し得る唯一ベストなクラウド」 を目指すことだとマグワイク氏は強調した。この目標達成のために、OCIはシステム全体、特にハードウェアとソフトウェアの両面で全スタックを改善してきた。

OCIの設計思想の根幹は、「ベアメタルサーバ」に焦点を当てたことにある。これはセキュリティを最優先した結果であり、顧客に「完全なコントロール」を提供するため、ベアメタルサーバでソフトウェアを一切実行しないということだ。

また、多様なワークロードに対応するため、OCIは早い段階からRDMA(リモート・ダイレクト・メモリ・アクセス)ネットワークのサポートに取り組んだ。これは「Oracle Database」で培われた高性能クラスタリング技術がベースとなっている。OCIのRDMAは、低レイテンシ(数マイクロ秒)かつ高帯域幅の通信を実現し、CPUを介さずにノード間で直接メモリ転送を実行する高速かつ効率的な仕組みだという。これにより、高性能とクラウドのセキュリティが両立し、HPCやGPUネットワーキング環境の提供を可能にしている。

さらに、OCIはリージョン展開と価格設定における複雑さを排除している。全てのサービスが全てのリージョンで利用可能であり、料金体系も一貫しているとアピールする。「全てのリージョンに性能面でのSLAが適用され、顧客は常に最高の性能を得られる安心感がある」とマグワイク氏は述べた。

一般的なクラウドの複雑な料金体系は、顧客がコストを理解するために専門家を必要とするほどだが 、OCIは全てのリージョンで一貫した料金体系を採用しているという 。OCIリージョン内のデータセンター間のデータ転送は無料で、イグレスコストも最適化されており、「競合他社より10倍低い水準にある」とマグワイク氏は強調。さらに、MicrosoftやGoogleといったパートナーとのマルチクラウド接続で、OCIとそれらのクラウド間のイングレス/エグレスコストはゼロになっていると主張する。

TikTokが要求した驚異的なスケールと共同開発の成果

同講演にはByteDanceで「TikTok」のインフラストラクチャー・エンジニアリング責任者を務めるフォン・フェイ氏も登壇し、OCIとの協業の成果を語った。TikTokは世界で10億人以上、米国で1億7000万人以上が利用し、数百万台のサーバやPB(ペタバイト)級のストレージ、数百Tbps(テラビット毎秒)のネットワーク容量を必要とするグローバル規模のサービスだ。

ByteDanceは「信じられないほど速くスケールアップする」という要件を満たすためOracleと協業し、数百Tbpsのトラフィックに対応するため数千の「FastConnect」(OCIとクライアント環境間の専用接続線)を利用している。OCIが業界初の100G、そして400GのFastConnectをリリースした背景には、ByteDanceからの要求に応える必要があったからだという。

TikTokは2021年以降、月間アクティブユーザーが60%増加するなど成長を続けており、計画的な対応だけでなく、急な変更や予測不能なロードスパイクにも対応できるOCIの柔軟性が極めて重要だったという。ByteDanceは現在、OCIから取得したデータに加え、データセンターの温度や電力データなども活用し、スマートなロードバランシングシステムを構築している。

フォン氏は、大規模インフラを運営する上で、ユーザー体験(UX)を維持するための最重要要素は「安定性」だと指摘した。SLAという最低限の要件に加えて、両社で共通認識となる「安定性目標」を設定した。マグワイク氏は、問題が発生した際に両社のチームがシームレスに連携し、同じデータを見て協力することが重要だとし、「両社のパートナーシップがOCIの進化に多大な学びと機会を与えた」と述べた。

AI時代に向けた次世代インフラ「Acceleron」とAIスパコン「Zettascale10」

マグワイク氏は、OCIのアーキテクチャコアを継続的に刷新した成果として、新アーキテクチャ「Acceleron」を発表した。AcceleronはOCIの性能や効率、セキュリティに焦点を当て、全ての入出力を保護し加速させる仕組みだ。

Acceleronは専用ネットワークファブリックの進化であり、OCIのネットワーク設計を当初の単一ネットワークから、RDMAファブリックなど複数の専用ファブリックをサポートするものへ移行したものだ。これにより、「Exadata」やHPC、大規模なAIを含むML(機械学習)クラスターに対して、予測可能で低レイテンシかつ高帯域幅の接続を提供するという。

Acceleronの重要な要素として、次世代ハードウェアと共に導入される「コンバージドNIC」がある。これは、セキュリティのために分離されていた顧客側NICとプロバイダー側SmartNICを、ハードウェアパーティショニングによって単一のSmartNICに統合したものだ。この設計によって、セキュリティ上のメリットを維持しつつ、NVMeインターフェースの使用、ラインレート暗号化、ベアメタルホストNICのシームレスなパッチ適用が可能になった。パケット処理の二重化がなくなるため、コンピュートの利用可能なスループットが最大2倍になるとマグワイク氏は説明した。

さらに、2024年に導入された「ゼロトラスト・パケットルーティング」(ZPR)が強化された。ZPRは、ネットワークセキュリティとルーティングルールを分離し、セキュリティポリシーを個別に分析しやすくする。強化されたZPRは、ID・アクセス管理(IAM)の拒否ポリシーと組み合わせることで、資格情報が盗まれても、インターネット経由でのオブジェクト・ストレージからのデータ流出を防げるという。

Acceleronの重要な要素として、バックエンドで「マルチプレーン・ネットワーク」を実装することも挙げられた。ホストには単一のネットワークプレーンだけを公開するが、内部では複数の独立したネットワークプレーンに接続することで、冗長性と高い可用性を実現しつつ、ネットワーク階層の削減による低コストと低レイテンシを実現している。

Acceleronの発表と同時に、OpenAIとの協業を背景とした「Oracle Cloud Infrastructure Zettascale10」(OCI Zettascale10)も発表された。これはクラウドにおける最大のAIスーパーコンピュータであり、複数データセンター間で数十万台規模のNVIDIA GPUを相互接続し、最大16 zettaFLOPSという前例のないピーク性能を実現する。OCI Zettascale10は、テキサス州アビリーンでOpenAIと共同で構築中のフラグシップ・スーパークラスタ(Stargateプロジェクトの一部)の基盤ファブリックとなっており、革新的な「Oracle Acceleron RoCE」ネットワーク・アーキテクチャの上に構築されている。

OpenAIが求めるAIインフラの「産業化」を支えるOCIの貢献

OpenAIのインフラストラクチャー&インダストリアル・コンピュート担当バイスプレジデント、ピーター・ヘシュリー氏も登壇し、AI開発におけるOCIの貢献について語った。ピーター氏は、AIの進化に伴い、コンピューティング容量の確保が業界最大の課題だと述べた。彼は約1年前、切迫した状況下でOCIに連絡した際、OCIチームがインテリジェントなクラスタ設計とセキュリティ要件を理解した上で、「200メガワットもの容量」を提供したことに驚きを示した。

ピーター氏は現在のAIの状況を「産業化」の段階にあると表現し、そのために電力からシリコンに至るまで、あらゆる要素を最大限に活用しようとしていると説明した。彼は、OCIチームが共同設計に積極的であり、AMDやBroadcomとの連携を通じ、OpenAIの継続的に求める「10倍のスケーリング」を支えている点を評価した。

ピーター氏によれば、AI開発が学習と推論の2つのプロセスに分けて論じられる段階から、モデルが常に稼働し、サンプリングと学習を繰り返す新しい段階に移ったという。そのため、プラットフォームの拡張性が極めて重要だと強調した。「スケーリング仮説」に基づき大規模なクラスタを設計していたOpenAIは、ChatGPTのローンチ時に、容量を大規模な事前学習から動画生成AI「Sora」のような新製品のローンチへと柔軟に切り替える必要性を学んだ。

OCIのスタッフが技術的な問題を深く理解していることで、サイクルタイムが短縮され、わずか11カ月でアビリーンのような大規模データセンターが立ち上がったように、迅速な容量提供が可能になっている点にピーター氏は感銘を受けたという。

また、グローバルに急速に拡大するOpenAIにとって、OCIが「ワンストップ・ショップ」として各国の輸出規制やセキュリティ要件に対応してくれるため、OpenAIが成長に向けた業務に集中できると強調した。

AcceleronやZettascale10の発表に見られるように、今回のイベントでOracleは、AIトレーニングの極限的な要求に応えるインフラ投資を続けていることを明確に示した。今後、生成AIの活用が浸透し、AI推論のコスト効率と低レイテンシがサービスの成否を分ける時代が到来するだろう。OCIが持つ性能やコスト効率、マルチクラウド展開能力は、AIの“推論時代”のニーズに合致する。OCIが引き続きAIインフラの主要なプレイヤーとして、その価値を高めていくことを予測させる基調講演だった。

関連記事

Microsoft 365 Copilot、ついに“エージェント化” ExcelやWordで複雑なタスクを段階的に処理する新機能

Microsoft 365 Copilot、ついに“エージェント化” ExcelやWordで複雑なタスクを段階的に処理する新機能

Microsoftは、Microsoft 365 Copilotの新機能「Agent Mode」と「Office Agent」を発表した。ExcelやWordなどのOfficeアプリでAIと対話的に協働し、複雑な業務を段階的に処理・完成できる。 “AIエージェントの次”のトレンドは何か Gartnerが描く未来志向型インフラのハイプ・サイクル

“AIエージェントの次”のトレンドは何か Gartnerが描く未来志向型インフラのハイプ・サイクル

Gartnerは、日本の未来志向型インフラ・テクノロジーに関するハイプ・サイクルを発表した。AIエージェントや完全自動化など9項目を新たに加え、2030年を目標とした産業変革の指針を提示している。 生成AI、進化の鍵を握る「長期思考」 Sakana AIが挑む“人間のように試行錯誤するAI”への道筋

生成AI、進化の鍵を握る「長期思考」 Sakana AIが挑む“人間のように試行錯誤するAI”への道筋

AIの進化は目覚ましく、その活用は日々広がっている。しかし、現在のAIにはまだ苦手な分野がある。それは数週間といった「長期間の思考」を要する複雑なタスクだ。この難題にAI研究の最前線はどう挑んでいるのか。Sakana AIの秋葉拓哉氏に話を聞いた。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 500万件のWebサーバでGit情報が露出 25万件超で認証情報も漏えい

- Fortinet、管理サーバ製品の重大欠陥を公表 直ちにアップデートを

- 一気読み推奨 セキュリティの専門家が推す信頼の公開資料2選

- 米2強が狙う“AI社員”の普及 Anthropicは「業務代行」、OpenAIは「運用プラットフォーム」

- NTTグループは「AIがSI事業にもたらす影響」をどう見ている? 決算会見から探る

- 住信SBIネット銀行、勘定系システムのクラウド移行にDatadogを採用

- 「SaaSの死」騒動の裏側 早めに知るべき“AIに淘汰されないSaaS”の見極め方

- LINE誘導型「CEO詐欺」が国内で急増中 6000組織以上に攻撃

- ドローンいらず? 飛行動画作成できる「Google Earth Studio」登場

- 2025年、話題となったセキュリティ事故12社の事例に見る「致命的なミス」とは?

Oracle クレイ・マグワイク氏(出典:Oracleの提供画像)

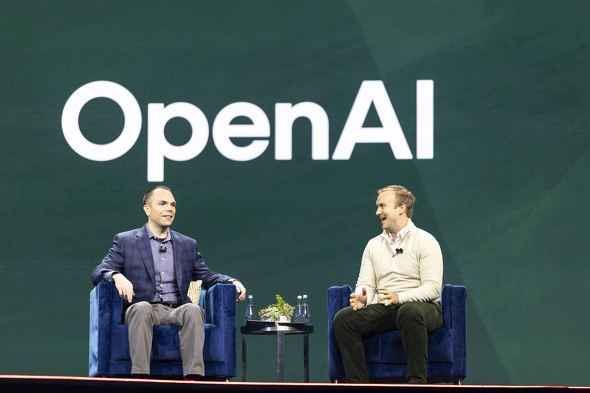

Oracle クレイ・マグワイク氏(出典:Oracleの提供画像) (左)Oracle クレイ・マグワイク氏、(右)OpenAI ピーター・ヘシュリー氏(出典:Oracleの提供画像)

(左)Oracle クレイ・マグワイク氏、(右)OpenAI ピーター・ヘシュリー氏(出典:Oracleの提供画像)