『AIに聞いてみた』の疑問点を「NHKに聞いてみた」 “AI”から受ける印象と実態の「ちぐはぐさ」(2/2 ページ)

では、どんな手法で分析したのか

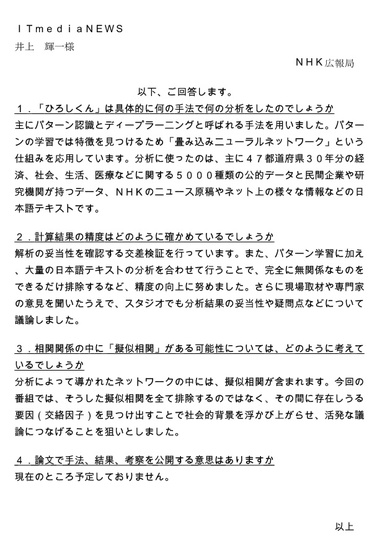

では、具体的に何の手法で何の分析をしたのか。筆者の質問に対し、NHKは「主にパターン認識とディープラーニングと呼ばれる手法を用いた」としつつ、「パターンの学習では特徴を見つけるために『畳み込みニューラルネットワーク』という仕組みを応用した」と答えた。

「計算結果の精度はどのように確かめたのか」という問いには、「解析の妥当性を確認する交差検証を行っている」と説明。「また、パターン学習に加え、大量の日本語テキストの分析を合わせて行うことで、完全に無関係なものをできるだけ排除するなど、精度の向上に努めた」としている。

畳み込みニューラルネットワーク(CNN)を用いたというのは重要な情報かもしれない。画像処理系の機械学習に用いられているCNNを文字データの処理(自然言語処理)に使ったということなら、ただ「ディープラーニング」といわれるよりは分析手法の想像が付く(理解できるとはいえないが)。

「交差検証を行っている」とはどういうことか。機械学習では「過学習」という現象が起きる。学習に使用したデータの入力にはよく答えられるが、使用しなかった未知のデータを入れると答えられない現象のことだ。

そこで通常、機械学習のために集めたデータは「訓練データ」と「検証データ」に分けられる。訓練データで学習させ、検証データで正答率を検証してはパラメータを調整し、再度学習させる――というサイクルを繰り返すことで、過学習を起こさずに正答率を上げることができる。

交差検証は、この原理を応用。データをK個に分割し、K-1個を訓練データに、残りの1個を検証データとして使い、検証データのブロックをK回順に変えていくことで過学習を防ぎつつ正答率を上げる方法だ(参考:技術評論社)。

例えば、データを3個に分割する。ブロック1、2を訓練データ、ブロック3を検証データとして計算。次にブロック1、3を訓練データ、ブロック2を検証データとして計算。さらにブロック2、3を訓練データ、ブロック1を検証データとして計算――と、計3回の計算で得られた結果を平均したものが交差検証で得られたスコアになる。

CNNや交差検証を使用していることが分かり、当初よりは“霧が晴れた”ものの、具体的な数字やグラフがない状況で「納得した」というのは難しい。

内容の透明性のために、論文で公開する意思はないのか。「現在のところ予定していない」とNHKは回答した。

「擬似相関」はある

統計学には「擬似相関」という用語がある。

そもそも「相関」は、2つの事柄について「一方の値が大きい時、もう一方の値も大きい」(正の相関)ことや、「一方の値が大きい時、もう一方の値は小さい」(負の相関)ことを指す。

これに対し、擬似相関は「関係のない2つの事柄に、あたかも因果関係があるように見える相関」のことだ。

「アイスの消費量が増えると熱中症患者が増える」という関係を仮定してみよう。言うまでもないが、どちらの事柄も「気温の上昇」という原因で発生している結果であり、「アイス」と「熱中症」の間に正の相関関係はあっても、因果関係はないと考えるのが妥当だ。

この時の「気温の上昇」という3つ目の事柄を「交絡因子」(こうらくいんし)と呼び、交絡因子によってあたかも因果関係があるように見えることを擬似相関という。

NHKのAIが分析した相関ネットワークの中には、擬似相関はないのか。あるのであればどう考えているのか。

NHK側は「分析によって導かれたネットワークの中には、擬似相関が含まれる」と、疑似相関が含まれていることを認める。その上で「今回の番組では、そうした擬似相関を全て排除するのではなく、その間に存在しうる要因(交絡因子)を見つけ出すことで社会的背景を浮かび上がらせ、活発な議論につなげることを狙いとした」と説明する。

確かに、機械による相関計算だけでは因果関係は分からない。番組内では「AIは理由や因果関係は分からない」「AIの分析結果を読み解くのは人間の仕事」とも述べられている。

だが、その一方で「40代ひとり暮らしが日本を滅ぼす」や「少子化を食い止めるには結婚よりもクルマを買え」などと“AIの提言”は断定口調だ。「因果関係は分からない」としているのに、このような言い方にする必要はあったのだろうか。

人々がAIに「期待すること」と実態の“ちぐはぐさ”

「AIが計算した」と聞いた時、現代の人々はどう思うだろう。

将棋AI「PONANZA」、囲碁AI「AlphaGo」が人間のプロ棋士に勝ち、自動運転車の普及も目の前に迫っている時代だ。「AIが計算した」と聞けば、「それは正しいものだろう」と受け入れる人がいてもおかしくないのではないだろうか。

AIの正しさは「AIであること」が保証しているわけではない。ゲームAIは実際に戦って勝ってみせるから誰が見ても強いと分かり、自動運転車は実際に走ってぶつからないから誰の目にも安全だと示すことができるのだ(もちろんそれぞれもっと専門的な視点もある)。

NHKは、番組内でAIの正しさを誰の目にも分かるようには示さなかった。

番組内で東京大学の坂田一郎教授が話したように「(NHKの)AIの言うことの解釈は人間の責任」であり、活発な議論につなげることが狙いだとNHKはいう。

しかし、マツコ・デラックスさんが、AIの提言を「これが正解とは言わないけれど、分かりやすいお告げ」と評したことが、筆者にとっては印象深い。

人が議論しなくてはならない計算結果なのに、何となく正しそうな“AI”という権威からの「分かりやすいお告げ」の形にしてしまった「ちぐはぐさ」が、批判の声が出た原因ではないだろうか。

関連記事

素人でもディープラーニングができる「NVIDIA DIGITS」で文字認識をやってみた

素人でもディープラーニングができる「NVIDIA DIGITS」で文字認識をやってみた

「AIにノーベル賞を取らせる」──ソニーコンピュータサイエンス研究所所長が語る「AIと生物学の未来」

「AIにノーベル賞を取らせる」──ソニーコンピュータサイエンス研究所所長が語る「AIと生物学の未来」

「ノーベル委員会を相手にチューリングテストを挑む」というソニーCSL所長の北野CEO。「ノーベル賞を取れるAI」の未来像と、AIが打破すべき科学の課題を語った。 ロボットが池に“身投げ” その理由が判明

ロボットが池に“身投げ” その理由が判明

ワシントンD.C.のショッピングモールでセキュリティロボットが“身投げ”した問題について、開発元企業が原因を発表。仕事の過酷さを苦にした投身自殺――ではなかったようだ。 「魔法のよう」――pixivがお絵描きサービスにAI自動着色を取り入れた理由

「魔法のよう」――pixivがお絵描きサービスにAI自動着色を取り入れた理由

今や会員2300万人を抱える巨大サービスになったpixiv。彼らの新たな取り組み「pixiv Sketch」とは何か。AIを活用し、何を目指すのか。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR