ITmedia NEWS >

STUDIO >

YouTube、不適切動画チェック担当者を2018年に1万人以上に

» 2017年12月06日 09時15分 公開

[佐藤由紀子,ITmedia]

米Google傘下のYouTubeのスーザン・ウォジスキCEOは12月5日(現地時間)、不適切な動画対策の成果と今後の取り組みについて発表した。

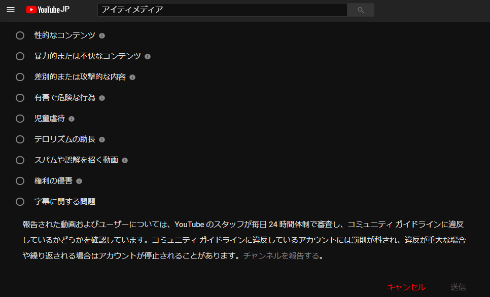

YouTubeでは3月、人種差別やイスラム過激派に賛同する内容などの不適切な動画が広告収入を得ているとして批判された。また、未成年が出演する動画への不適切なコメントや、「YouTube Kids」に子ども向けではない動画が表示される問題も浮上している。

Googleは6月、こうした問題に対処するために機械学習による問題コンテンツ検出システムの強化を約束した。

ウォジスキ氏によると、6月以来、機械学習システムは従来の5倍以上人間のレビュアーをサポートしたという。機械学習のサポートを得て、15万本以上の動画を暴力的過激主義だとして削除した。現在では、暴力的過激主義だという報告の98%は機械学習によるもので、そうして報告され、実際に問題だと人間のレビュアーが判断した動画の70%は投稿から8時間以内に削除されている。

機械学習システムの強化を継続しつつ、最終的な判断をする人間のレビュアーも増やす。2018年中にレビュアーチームを1万人以上にする計画だ。ちなみに米Facebookは5月、年内に人間のレビュアーを7500人にすると発表した。

ウォジスキ氏はクリエイター向けの公式別のブログで、「誤って不適切ではない動画から広告を排除しないよう、われわれがコンテンツレビューの際、もっと正確であるべきだという皆さんの声は届いている」とし、システムを改善していくと語った。

関連記事

YouTube、不適切なコンテンツ対策を強化 「YouTube Kids」ガイドライン公開も

YouTube、不適切なコンテンツ対策を強化 「YouTube Kids」ガイドライン公開も

YouTubeが、一見家族向けで実は子どもに見せられないような動画や、未成年が危険にさらされるような動画の増加を受け、対策強化を発表した。ガイドラインの適用範囲を広げ、既に50以上のチャンネルを停止した。 Google、YouTubeなどでのテロ対策強化を説明

Google、YouTubeなどでのテロ対策強化を説明

Facebookに続き、Googleもコンテンツサービスでのテロ行為対策について説明した。人工知能と人間による問題コンテンツ検出システムの強化やグレーな動画への広告非表示など、4つの取り組みを紹介した。 YouTube、LGBTQ動画への不適切フラグは誤動作だったとして謝罪し改善を約束

YouTube、LGBTQ動画への不適切フラグは誤動作だったとして謝罪し改善を約束

YouTubeの、不適切な動画を表示させないようにするオプション機能「制限付きモード」で、多数のLGBTQ動画が対象とされた件について、制限はシステムの誤動作だったとして謝罪し、修復していくと約束した。 YouTubeからの大手メディア広告引き上げを受け、Googleが自動システム改善を約束

YouTubeからの大手メディア広告引き上げを受け、Googleが自動システム改善を約束

英国政府や大手メディアが、YouTubeの不適切な動画に広告が表示されるとして、YouTubeやGoogle Display Networkから広告を引き上げたことを受け、Googleが広告ポリシーを改善し、広告表示先を管理しやすくすると約束した。 Facebook、問題コンテンツ対策強化で3000人増員へ

Facebook、問題コンテンツ対策強化で3000人増員へ

虚偽ニュース拡散や殺人動画配信が問題となっているFacebookが、報告のあったコンテンツをレビューするチームを向う1年間で3000人増員すると発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR