安易にAIを使って大丈夫? AIにまつわる法と倫理と社会課題(1/2 ページ)

今、AIがさまざまな分野で注目を集めています。自動運転や音声認識、人間を打ち負かすようなAI囲碁プレイヤーなど、AIを活用したモノやサービスが続々と登場していますが、世の中にAIが浸透すればするほど、法的、倫理的な観点による課題も浮き彫りになっています。

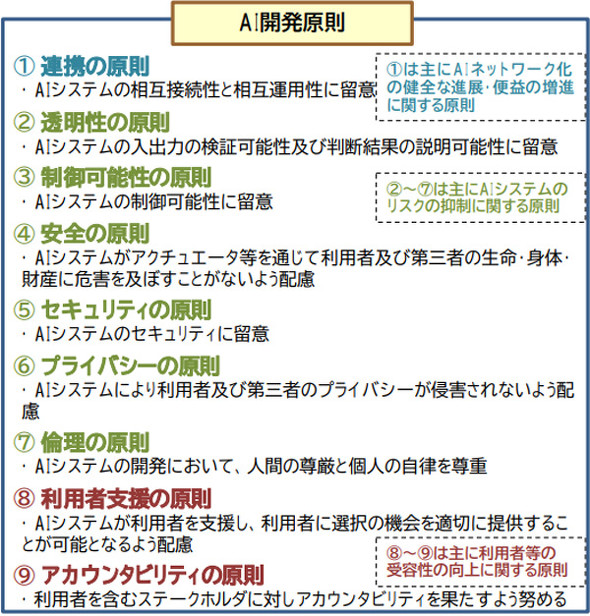

総務省や内閣府でAIのガイドライン作りに携わった中央大学の平野晋教授(国際情報学部)は、現状のAIには“減らすべき性質”があるといいます。詳しい話を聞きました。

減らすべきは「不透明性」「制御不可能性」「データに左右される特性」

平野教授は、AIやAIを載せたロボットの「不透明性」や「制御不可能性」「データに左右される特性」が課題だと言います。

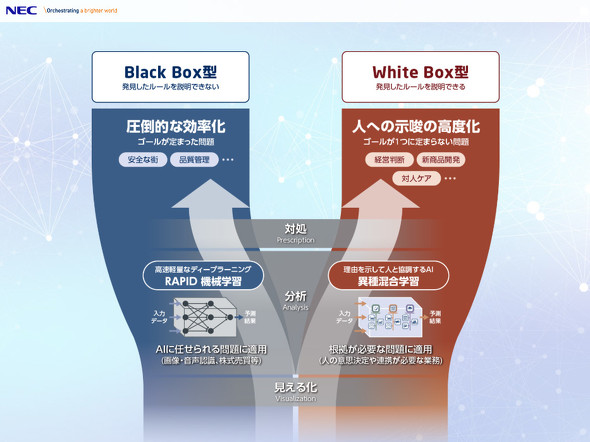

AIは学習したデータを基に考え、さまざまな課題について自律的に判断します。しかし、AIの多くは、なぜその判断を下したのかを自身で説明できませんでした。この「判断は下せるが理由は説明できない」という性質を「不透明性」と呼びます。

例えば、就活生のエントリーシートを読んで、採用するかどうかを判断するAIを考えてみましょう。AIは過去のエントリーシートや採用情報などから学習したロジックを基に、今読んでいるエントリーシートを書いた人を採用するべきかどうか考えます。

ところが、AIはその合否を下した理由を人間が分かるように説明できない恐れがあるのです。就活生がなぜ不採用になったのかと尋ねてきても、企業側が「理由は分からないが、AIが不採用だと判断したから」としか説明できないというのは問題です。

理由が説明できないとなると、AIが何か間違った判断をしたときにも、なぜ間違ったかを探りにくくなってしまいます。どこで間違うのか分からなければ、AIを活用した製品やサービスを改善しようにもどこを直せば良いか分からないですし、法的な責任を問うための証拠も見つけられません。

AIがコントロールする自動運転車が、ハンドルを切り間違えて人をひいてしまったとしましょう。このとき、なぜAIが間違った方向にハンドルを切るように判断したのかが分からなければ、乗っていた人、AIを開発した人、自動車を組み立てた人、学習用のデータを提供した人などのうちの誰が非難されるべきか、どこに責任があるのかを証明する証拠を示せません。被害者はなぜ車にひかれたのかも分からず泣き寝入りになってしまいます。

「特に、個人の人生に大きくかかわる場合には、判断の理由を示せることが重要になる」と平野教授は言います。娯楽品なら、AIがどう考えるのかが分からなくても、致命的な問題にはなりません。しかし、理由も分からず就職に失敗する、事故に遭うといったことが起こるのは問題です。

これは「ブラック・ボックス問題」と呼ぶこともあります。最近では、判断の理由を説明できる「説明可能なAI」(explainable AI)に注目が集まり、開発が盛んになってきています。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR