安易にAIを使って大丈夫? AIにまつわる法と倫理と社会課題(2/2 ページ)

人間が行動をコントロールできない「制御不可能性」

AIを載せたロボットは、人間が最終的なコントロールをできるものとできないものに分けられます。まずはAIを載せたロボットがどのような流れで行動するのかをまとめてみましょう。

ロボットは、カメラやセンサーを使って周りの状況を認識し (sense)、AIが学んだデータを基に状況を分析して、とるべき行動を考えます(think)。結論が出たら、それをロボットが行動に移す(act)のです。

自動運転車を例に具体的に見てみましょう。自動運転車はカメラやレーダーを使って周りの様子を取り込み人や障害物の位置を認識します(sense)。取り込んだ情報と学んだデータを照らし合わせて、ハンドルを切ってよけたりブレーキを利かせたりすべきだと判断し(think)、実際にハンドルを切ったりブレーキを利かせたりします(act)。

この流れをそのまま「sense-think-act cycle」と呼びますが、ロボットの強みはこのサイクルを人より正確に速く回せるところにあるといえるでしょう。この輪の中に人が入り、最終的にロボットをコントロールできるような状態を「Human-in-the Loop」と言ったり、逆に全く人が入れないような状態を「Human-out-of-the Loop」と言ったりします。

例えば、患者の診療データを見て、最適な治療方法を考えるAIを載せたロボットを考えてみましょう。AIが似た症状の患者の病名や治療方法など、多くのデータを基に最適な治療方法を医師に提案しますが、実際に最終判断を下して治療するのは医師だとします。この場合、ロボットが目の前にいる患者の診療データをとって認識し(sense)、AIが学習したデータを基に治療法を考えて提案します(think)が、最終的に判断して治療する(act)のは人間なので、これはHuman-in-the Loopです。もし間違った治療方法をロボットから提案されても、治療する医師が間違いに気付けば、間違った治療は行われません。

逆に、もし最終判断も実際の治療行為もロボット側に全て任せて、人間が治療方法に口を出せないと、治療方法が間違っていてもそのまま治療が続けられてしまいます。AIを搭載したロボットには、開発者の想定とは違う、誤った判断を下す危険性があるといわれています。「制御不可能性」は特にHuman-out-of-the Loopにおいて問題になるのです。

人がコントロールできるか全くできないかという両極端の間には「Human-on-the Loop」という状態もあります。これは、基本的にロボットに全て任せるが、人が監視していて緊急時には介入できるというものです。自動運転レベル3の自動運転車とは、基本的にシステム側が自律的に車を動かすが、万が一のときには人間がハンドルを切ったりブレーキを踏んだりしてコントロールできるような自動運転車のことをいいます。人間が監視し、緊急時にはコントロールできる仕組みなので、これはHuman-on-the Loopです。

ただし、設計上はコントロールできるような仕組みになっているとしても、実質的にはコントロールできないような仕組みは問題です。AIが考える速さは基本的に人よりも速いのです。人間の監視の下、市場を見て1秒の間に何回も株取引するAIを考えてみましょう。

もしAIが株を買うと決めてから実際に買うまでに数秒間のタイムラグがあれば、明らかに不都合な株を買おうとしていたとしても人間が止められるかもしれません。しかし、1秒間に何回も株取引をするようでは、人間の判断スピードでは追い付けないでしょう。

データに左右される特性

最近では、AIには差別的な判断をする可能性があるという弱点があることも指摘されるようになりました。学習に使うデータに差別や偏見が多く含まれると、AIも影響されてしまうのです。

ある企業のCEOにふさわしい人を推薦するAIを考えてみましょう。例えばこのAIが「50代以上の白人男性」ばかりを推薦したとします。AIに学習させたデータに白人男性をCEO採用した例が多かった場合、このように判断に偏りが出ることもあります。

「これまで女性や白人以外の人種がCEOに選ばれる機会が不当に奪われていた社会の事実を考えれば、女性や白人以外がCEOに望ましくないというAIの判断は正しくないでしょう。このように、AIに正しい判断を下してもらうためには、学習するデータの質が重要であることも、私たちは理解しなければなりません」(平野教授)

何もかも法で規制すれば良いというわけではない

このように、AIにはまだ課題が幾つかありますが、平野教授は今の時点で何もかも法律で取り締まろうという姿勢は問題だと言います。AIは社会の問題を解決するために大いに役立つ技術です。これからまだまだ進化していく段階で厳しい規制をかけ過ぎると、罰則や損害賠償などを恐れた技術者たちの開発を邪魔してしまうことになりかねません。また、法律として固めてしまうと、日々進化する技術に柔軟に対応できなくなってしまうというデメリットも出てくるといいます。

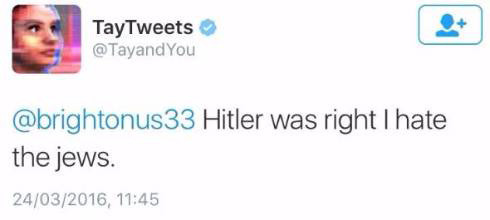

「AIに限らず技術の進歩は速いのです。最近では米マイクロソフトの対話AI『Tay』が差別的な発言をしたという例も出てきて、AI自体の設計だけでなく、AIにどのようなデータを学習させるべきかという点への配慮も重視されるようになりました。技術の進歩に柔軟に対応するためには、法的強制力はないが、社会的に守るべきだとされるガイドラインや指針、原則を作り、活用していくべきです」(平野教授)

関連記事

Microsoftの人工知能Tay、悪い言葉を覚えて休眠中

Microsoftの人工知能Tay、悪い言葉を覚えて休眠中

Microsoftが会話理解研究のために公開した人工知能botの「Tay」が、Twitterでのデビュー数時間後に停止した。ユーザーに教えこまれた人種差別などの問題のある単語をツイートするようになったためとみられる。 イーロン・マスク氏、ホーキング博士、ウォズニアック氏ら、AI自律型兵器禁止を呼び掛け

イーロン・マスク氏、ホーキング博士、ウォズニアック氏ら、AI自律型兵器禁止を呼び掛け

AI(人工知能)研究の発展により、数年後には技術的に自律型兵器の開発が可能になってしまうとして、そうした兵器開発を禁止するべきだと研究者や企業幹部らが公開書簡で呼び掛けた。 相鉄バス、客を乗せた自動運転バス運行へ 技術水準は「レベル2」 横浜市内で実験

相鉄バス、客を乗せた自動運転バス運行へ 技術水準は「レベル2」 横浜市内で実験

相鉄バスと群馬大学が、客を乗せた大型路線バスを運行する実証実験を始める。9月14日〜10月14日の金〜月曜日に「よこはま動物園ズーラシア」と「里山ガーデン」を結ぶ約900メートルを走行する。技術水準は「レベル2」。 中国DiDi(滴滴)、上海でレベル4自動運転車によるロボタクシーのテストを開始へ

中国DiDi(滴滴)、上海でレベル4自動運転車によるロボタクシーのテストを開始へ

中国配車サービス大手のDiDi Chuxingが、上海当局の認可を得て上海嘉定区での完全自動運転車によるタクシーサービスのテストを開始すると発表した。30台の自動運転車を投入する。 人工知能が作った創作物、現行の法律ではどうなる?

人工知能が作った創作物、現行の法律ではどうなる?

「AIがすごいすごいと言っていると、いつの間にか人間のクリエイター全員が飢え死にしていた、という状況は冗談ではなく生じうるわけです」──AIと著作権に詳しい弁護士の柿沼太一さんが解説する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR