OpenAI、文章から画像を生成する新モデル「GLIDE」 前モデルよりも高品質な画像を生成:Innovative Tech(2/2 ページ)

OpenAIは、DALL・Eと同時にCLIPという画像認識モデルも発表している。発表当時はDALL・Eのインパクトが強く影に隠れていたが、CLIPはその後、多数で応用され、影響を与える存在感のある技術となった。

CLIPでは、Webから収集した画像とそのキャプションの組み合わせ(4億ペア)で、類似度を返し、画像とテキスト間の双方向モデルを事前学習する。これまでの画像分類手法とは違い、微調整(fine-tune)をせずに予測するゼロショットを可能にしている。DALL・Eでは、CLIPを最後のリランキングで使っており、そのおかげで、高品質な画像生成を達成している。

今回の研究でもCLIPを使っているが、それよりも主要な技術はノイズ除去拡散確率モデル(DDPM: denoising diffusion probabilistic models。以下、拡散モデル)だ。拡散モデルは2、3年前から応用され盛り上がってきた技術で「GAN越えでは」の声もある。

実際にOpenAIは、拡散モデルを改良しGANより高い成果をたたき出した。「Diffusion Models Beat GANs on Image Synthesis」といった論文も発表したほど高い評価をしているモデルだ。

拡散モデルでは、元の画像データにガウシアンノイズを徐々に加え、元のデータが完全に失われてノイズのみになるまでマルコフ過程で行い、ノイズを除去したデータを逆向きに復元しながら生成モデルを学習する。

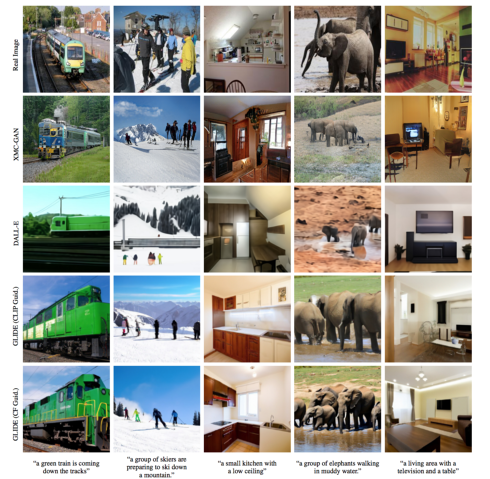

今回は、この拡散モデルをテキスト→画像の対応モデルに適応し検証した。具体的には、自然言語の記述を条件とするテキストエンコーダーを使った35億パラメータの拡散モデルを学習し、CLIPガイダンスと分類器なしガイダンスの2つを方法を試して、どちらがテキストを入力としてフォトリアリスティックな画像を合成できるかを比較した。

その結果、CLIPガイダンスよりも分類器なしガイダンスの方がフォトリアリスティックかつテキストに忠実に画像生成できると示した。前モデルのDALL・EよりもGLIDEの方が、人の評価でフォトリアリスティック評価では87%、キャプションの類似性評価では69%の確率で好まれる結果が得られた。

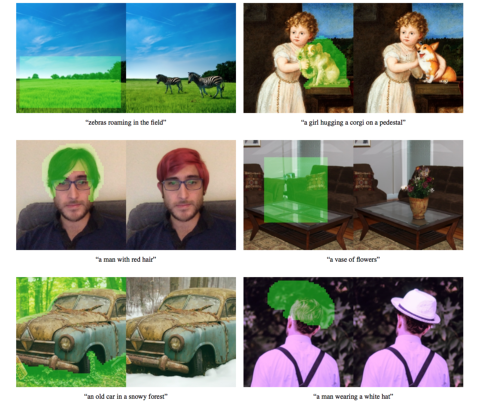

これらはゼロショットでレンダリング可能だが、複雑なテキストに対してフォトリアリスティックな画像生成が困難な場合がある。そのため、このモデルを微調整(fine-tune)して画像の一部をインペインティングすることで、編集機能を持たせ、より複雑なテキストでも良質な画像生成ができるように強化した。

画像の一部を塗りつぶして、テキスト入力すると、その箇所だけがテキスト通りに変わるわけだ。しかも、変わったその箇所は周囲の文脈のスタイルや照明に応じた影や反射を含み、周囲と調和し合成できる。

Nichol, Alex, et al. "Glide: Towards photorealistic image generation and editing with text-guided diffusion models." arXiv preprint arXiv:2112.10741 (2021)

関連記事

VRキャラクターに耳を「フー」してもらえるヘッドフォン、東大が開発 風源なしで温冷風を再現

VRキャラクターに耳を「フー」してもらえるヘッドフォン、東大が開発 風源なしで温冷風を再現

東京大学 Human & Environment Informatics Labの研究チームは、物理的なファンによる風がないにもかかわらず、風の感覚を耳で得られるヘッドフォン型ウェアラブルデバイスを開発した。 実世界に溶け込むCG 空中に浮かずに配置し、光の当たり具合も適切に調整

実世界に溶け込むCG 空中に浮かずに配置し、光の当たり具合も適切に調整

オーストリアのグラーツ工科大学とVRVis Research Center、ニュージーランドのオタゴ大学の研究チームは、実世界に溶け込むようにバーチャルオブジェクトをレンダリングする技術を開発した。 無表情だと誤解されがちな人向け「人工眉毛付きメガネ型デバイス」 7種類の感情を眉毛で支援

無表情だと誤解されがちな人向け「人工眉毛付きメガネ型デバイス」 7種類の感情を眉毛で支援

公立はこだて未来大学などの研究チームは、人工眉毛の形状が多様に変化することで表情を拡張する眼鏡型ウェアラブルデバイスを開発した。 VTuberの動きをオーバーリアクションに自動変換 中の人の表情などをアニメーションに反映

VTuberの動きをオーバーリアクションに自動変換 中の人の表情などをアニメーションに反映

米パデュー大学の研究チームは、バーチャルYouTuber(VTuber)の配信において、ストリーマーの実際の動きよりも表現豊かな動きとして拡張し出力するシステムを開発。ストリーマーのトラッキングから得た音声や表情などに基づいてアニメーション生成する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR