実世界に溶け込むCG 空中に浮かずに配置し、光の当たり具合も適切に調整:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

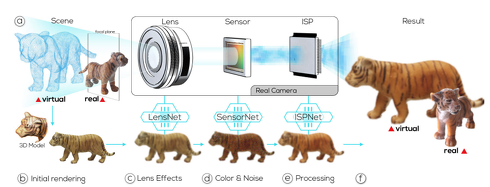

オーストリアのグラーツ工科大学とVRVis Research Center、ニュージーランドのオタゴ大学の研究チームが開発した「Neural Cameras: Learning Camera Characteristics for Coherent Mixed Reality Rendering」は、実世界にバーチャルオブジェクトを重ねて描画するビデオベースのMR(Mixed Reality)において、両者が調和しているかのようにレンダリングする深層学習を使った手法だ。物理的なカメラ特性を考慮することで実現した。

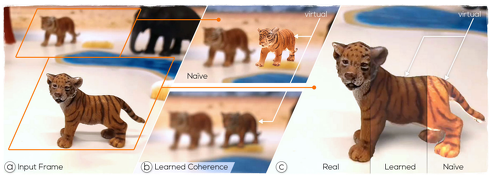

(a)虎のおもちゃ、(b)上段が従来の方法でレンダリングした3Dスキャンした虎のバーチャルオブジェクト。下段がこの手法を使って出力した虎のバーチャルオブジェクト、(c)虎の左が実物、中央がこの手法の出力結果、右が従来の出力結果

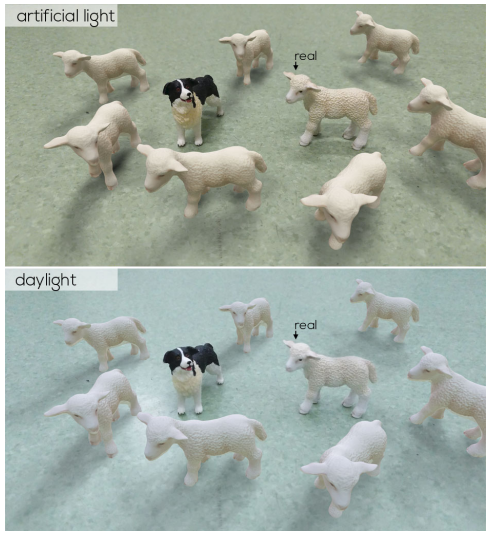

(a)虎のおもちゃ、(b)上段が従来の方法でレンダリングした3Dスキャンした虎のバーチャルオブジェクト。下段がこの手法を使って出力した虎のバーチャルオブジェクト、(c)虎の左が実物、中央がこの手法の出力結果、右が従来の出力結果実世界にバーチャルオブジェクトを表示するMRは、両者がどれだけ調和できるかが求められる。バーチャルオブジェクトが静止画ではなく、アニメーションを含むとなると難易度も上がる。そのために、実世界の物体と調和した配置(空中に浮いたりめり込んだりしていないか)と、実世界の動きに応じたリライティング(光の当たり具合)などを行う

一方で既存の方法では、バーチャルカメラに依存しており、物理的なカメラ特性を考慮しきれていないのが現状だ。これには、実際のレンズやセンサー、ISP(Image Signal Processor)が含まれる。今回は、このカメラ特性(レンズ、センサー、ISP)をDNN(Deep neural network)を使って推定し、バーチャルオブジェクトに適応することで、カメラ特性に応じたレンダリングを実行する。

具体的には、レンズシステムの動作を模倣するための「LensNet」、イメージセンサーを模倣するための「SensorNet」、そしてISPによって追加されるエフェクトを含むために「ISPNet」の3つのネットワークを設計した。このように3つのネットワークに分けることで、それぞれに最適なデータセットで学習できる。

この手法は、データセット内の画像に共通するカメラ特性を模倣してオフラインで学習するため、実行時に物理的なカメラに関する詳細な情報を必要としないのが特徴だ。

学習したモデルを介してレンダリングしたバーチャルオブジェクトは、高品質のぼかしや色合いが実世界と調和して表現される。従来のバーチャルカメラを使った場合と比べても、例えば、虎のおもちゃとそれを3Dスキャンした虎のバーチャルオブジェクトを並べると、 虎のバーチャルオブジェクトは実世界の色やブラーとの不一致が起こり、見る者に強烈な違和感を与えるが、今回のモデルを活用すると、レンダリングの色やブラーを実世界に合わせるため、実世界に溶け込んだような表現ができる。

関連記事

VTuberの動きをオーバーリアクションに自動変換 中の人の表情などをアニメーションに反映

VTuberの動きをオーバーリアクションに自動変換 中の人の表情などをアニメーションに反映

米パデュー大学の研究チームは、バーチャルYouTuber(VTuber)の配信において、ストリーマーの実際の動きよりも表現豊かな動きとして拡張し出力するシステムを開発。ストリーマーのトラッキングから得た音声や表情などに基づいてアニメーション生成する。 無表情だと誤解されがちな人向け「人工眉毛付きメガネ型デバイス」 7種類の感情を眉毛で支援

無表情だと誤解されがちな人向け「人工眉毛付きメガネ型デバイス」 7種類の感情を眉毛で支援

公立はこだて未来大学などの研究チームは、人工眉毛の形状が多様に変化することで表情を拡張する眼鏡型ウェアラブルデバイスを開発した。 月経痛と血の漏れを体験できるVR、奈良女などが開発 電気と温度で症状を再現

月経痛と血の漏れを体験できるVR、奈良女などが開発 電気と温度で症状を再現

奈良女子大学と甲南大学の研究チームは、月経症状を体験できるVRシステムを開発した。電気刺激による月経痛と、温度刺激による血の漏れ感覚を再現する方法で月経症状を再現する。 ポリ袋と同じ薄さの太陽電池、米スタンフォード大が開発 人間の皮膚にも装着可能

ポリ袋と同じ薄さの太陽電池、米スタンフォード大が開発 人間の皮膚にも装着可能

米スタンフォード大学の研究チームは、軽量で薄く曲げられる太陽電池を開発した。これまでのパネル式と比べ、 厚さが6マイクロメートル未満(ポリ袋程度の厚さ)の薄さを持ち、高いエネルギー変換効率を達成した。 作業中に「ツンデレ」されるとやる気は高まるか? メイドアバターで、奈良先端大が検証

作業中に「ツンデレ」されるとやる気は高まるか? メイドアバターで、奈良先端大が検証

奈良先端科学技術大学院大学の研究チームは、冷たい対応と優しい対応を組み合わせた動作「ツンデレ」が作業意欲にどのような影響を与えるかを検証した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR