「同席しているみたい」──ビデオ会議の相手を3Dモデル化 Googleの「Project starline」 その仕組みは?:Innovative Tech(2/3 ページ)

キャプチャーシステム

従来の物理的に集まる会議では、目から対面の人を見てそのまま認識するが、ビデオ会議などのオンラインになると、目だけではなく、相手側の固定カメラの位置や角度に応じた映像に依存する。そのため、ビデオ会議だと、できるだけ真正面にカメラを配置し、互いの目の高さを合わせて対面感を維持しようとする。

しかし、自分が動いても相手側のカメラは動かないため、リアリティーは失われ、画面越し感は残る。それを解決したのがVRなわけだが、今回は使えない。

映像に映る相手の左右の目に1台ずつカメラを配置し、顔の動きと連動してカメラも動くシステムを導入するという力技も考えられるが、ディスプレイの中央に組み込まなければいけないため、到底実装できない。となると、ディスプレイの周辺に複数のキャプチャーセンサーを設置して捉えるしかない。

研究チームは、この大きな視差を補正するために、可視光と近赤外線のグローバルシャッターイメージセンサーを組み合わせて、ユーザーの幾何学的な近似値を再構成し、できるだけ左右の目から見ているかのような表現を目指した。

市販のRGBDセンサーでは解像度が不十分なため、テクスチャ用のRGBカメラ(1600×1200)と、近赤外線カメラ(1280×1024)のペアを採用し、合計で4つの視点からカラー画像を、3つの視点からデプスマップをキャプチャーし、胴体や頭の全体像だけでなく、顔の細かい部分まで捉える。

レンダリング

従来のビデオ会議と違い、離れたシステムへキャプチャーした人物の3Dモデルをリアルタイムかつ連続的に伝送し表示しなければならない。しかも、ユーザーの左右の目の位置から見える相手のレンダリングを必要とする。

レンダリングの手法は、4台のカラーカメラのそれぞれについて、レイキャスティングによるシャドウマップと、左右の目に対してデプスマップ、各デプスマップの点のシャドウマップから色をそれぞれ計算する。

昨今の技術では、リアルな3Dモデルを再構築する場合、照明の当たり方を考慮したリライティング技術を使うが、この手法ではそれらを使用せず、代わりに4台のカラーカメラからのテクスチャ補間を行っている。

そのため、反射を持つ表面が正しくレンダリングされないデメリットが発生するが、ディスプレイユニットとバックライトユニットの側面と背面に設置した白色LEDライトでバウンス光を生成し、ソフトな照明環境の構築により、そのデメリットを緩和している。

また同時に、被写体に立体感を持たせるため、ディスプレイの片側を強めに発光して、露光比を約2:1にしている。

3Dオーディオシステム

物理的に人がいる場合、相手の話し声は口の位置から発して、自分の耳の位置に到達し聞こえる。既存の3Dオーディオ技術とヘッドフォンを使えば、ユーザーに対してこれらを提供できるが、今回はヘッドフォンレスなため非常に難しい。

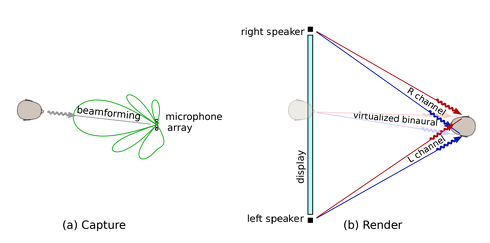

再現するためにこのオーディオシステムでは、相手の口と自分の耳を常に追跡し、口から耳へピンポイントで3次元的に音を届けているように錯覚させるためのビームフォーミング方式を採用する。

クロストーク・キャンセルと振幅パンニングのハイブリッドな組み合わせも取り入れ、さらに周囲の騒音や残響の低減、話し手の声がラウドスピーカーやマイクに反響するのを防ぐ仕組みも取り入れた。

ディスプレイ下部に設置した4つの単一指向性マイクロフォンを使い、サンプリングレート44.1kHzで音声をキャプチャーし、両側のステレオスピーカーから3Dオーディオを実行する。これにより、ディスプレイに映る相手の口の位置に空間的に合わせた音声が耳に聞こえる感覚を提供できる。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR