GPTを超える大規模言語アーキテクチャ「Hyena」とは何か?:清水亮の「世界を変えるAI」(2/2 ページ)

長文に対応 目標は本10冊分の自動生成

もう一つ、大きな違いは、長いシーケンス(文章)に対応することだ。現在のTransformerではだいたい長さ4000トークン(単語数)前後のシーケンスを扱うように訓練されている。例えばGPT-3のdavinci-003モデルは、4097トークンまでしか学習されていない。

しかし、今後、画像生成から動画生成へ変化したり、長い音声データを生成したりするように発展していくことを考えると、4000トークンでは短すぎる。だからChatGPTと長時間同じスレッドで会話を続けていると会話が破綻してくる。これは扱えるシーケンス長が短いからだ。

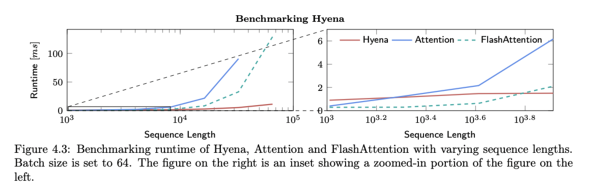

HyenaとTransformerを比べると、6000トークンくらいからHyenaの方が効率的になり、10万トークンくらいまで長いシーケンスになると、100倍高速化することが実験によって確かめられている。

上のグラフでは、青線が従来のTransformerで用いられるAttentionで、赤線がHyenaだ。

横軸はシーケンスの長さ(トークン数)である。トークンが十分短い場合は差は少ないが、長くなればなるほど差が開いていくのが分かる。

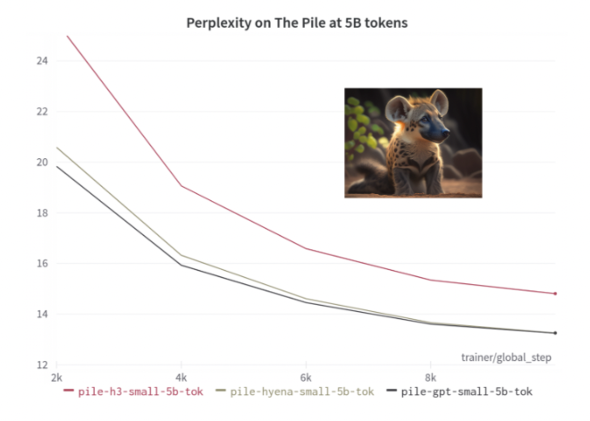

Hyenaは、本一冊くらいの長さの文章を扱うデータセット「PG-19」で訓練した場合でも、16000トークンのシーケンスで学習すると、同規模のパラメータ数のGPTに匹敵する性能を達成している。逆にシーケンスが短いとGPTに負けてしまう。

また、画像認識など文章以外の分野でもTransformerと同じ性能に達することが分かっており、今後Transformer一辺倒だったものが少しずつHyenaに置き換わっていく可能性もある。

研究チームの次なる目標は、さらに長いシーケンス長として、100万トークンのシーケンスを学習することを目指している。日本では新書などに必要な文字数が、最低8〜10万字といわれているので、まさに本一冊どころか小説10巻分の文章の自動生成においてさらなる性能向上を狙っているようだ。

これだけ長いシーケンスが扱えるようになると、今は非常に素朴なやりとりしかできないChatGPTのようなものも、人生の友と呼べるくらいに長く付き合える可能性がある。

人は、かなり親しい人との間でも、100万語も言葉を交わすことは滅多にないはずだ。

筆者プロフィール:清水 亮

新潟県長岡市生まれ。1990年代よりプログラマーとしてゲーム業界、モバイル業界などで数社の立ち上げに関わる。2005年、IPA(情報処理推進機構)より「天才プログラマー/スーパークリエイタ」として認定。株式会社ゼルペム所属AIスペシャリスト。現在も現役のプログラマーとして日夜AI開発に情熱を捧げている。

関連記事

なぜ人々は、ChatGPTという“トリック"に振り回されるのか? Google「Bard」参戦、チャットAI戦争の行方

なぜ人々は、ChatGPTという“トリック"に振り回されるのか? Google「Bard」参戦、チャットAI戦争の行方

OpenAIが2022年に発表した対話型AI「ChatGPT」の衝撃は、米国ビッグテック最強の一角であるGoogleを動揺させた。Googleは急ぎ「Bard」と名付けたチャットボットを投入し、巻き返しを図る。 日本を画像生成AIで再現する 「自分の見た景色」を学習したAIは強力な思い出再生装置に

日本を画像生成AIで再現する 「自分の見た景色」を学習したAIは強力な思い出再生装置に

AIで漫画を書こうとするとひとつ不便なことがある。StableDiffusionの元になっている学習データは「全世界」の画像を使っているので、日本人がイメージするような「郵便局」とはまったく異なるイメージになってしまう。そこで街のあちこちの景色を写真に撮った。これをAIに学習させて、独自の日本的な画像生成AIを作ろうというのだ。 AIで好きなポーズを出すために、モデルを10万枚撮影して手動でタグ付けしてみた

AIで好きなポーズを出すために、モデルを10万枚撮影して手動でタグ付けしてみた

最初にAIで漫画を描くときのハードルは、「同じキャラクターが出せない」というものだったが、これはDreambooth(Memeplexではカスタムモデル学習)を使うことで解決できた。次のハードルは、「欲しいポーズが出せない」というものである。 まさに「世界変革」──この2カ月で画像生成AIに何が起きたのか?

まさに「世界変革」──この2カ月で画像生成AIに何が起きたのか?

2022年8月22日。日本時間にして午前4時ごろ、「世界変革」はついに実行された。「どんな絵も描ける」AIである「Stable Diffusion」がついにオープンソースとして公開されたのだ。そこからの2カ月を振り返る。 AIでどこまでできる? 絵心のないプログラマーが「ChatGPT」と「作画AI」でマンガを描いてみた

AIでどこまでできる? 絵心のないプログラマーが「ChatGPT」と「作画AI」でマンガを描いてみた

クリスタにAI作画機能搭載が見送られたと聞いて、なるほどなあと思いつつ、では絵が全く描けない筆者が、AIを使って漫画を書くことはできるのか、実際にやってみることにした。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR