ラズパイで動く大規模言語モデルがGitHubで公開 性能は“GPT-3相当”、Metaの「LLaMA」派生

Raspberry Pi上で動かせる、GPT-3相当の大規模言語モデル(LLM)「Alpaca LoRA」がGitHub上で公開された。米MetaのLLM「LLaMA」の派生モデル「Stanford Alpaca」を再現できるという。

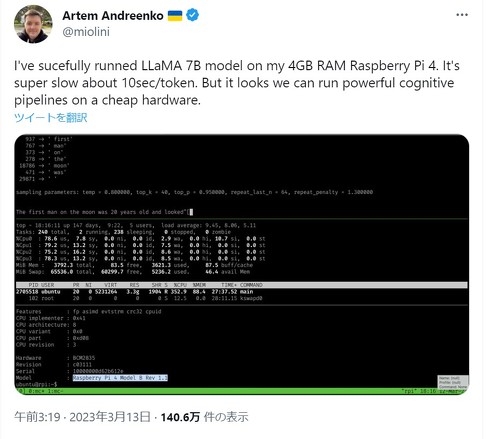

米国のIT技術者であるアルテム・アンドレネコ(@miolini)さんは3月13日、LLaMAの7Bモデルを「Raspberry Pi 4」で動かせるか検証したところ、超低速ながら稼働したと報告。1トークン当たり10秒という超低速スピードであるが「安価なハードウェアで強力なコグニティブ・パイプライン(※AIパーツの1種)を実行することができそうだ」と今後に期待を寄せるコメントをしている。

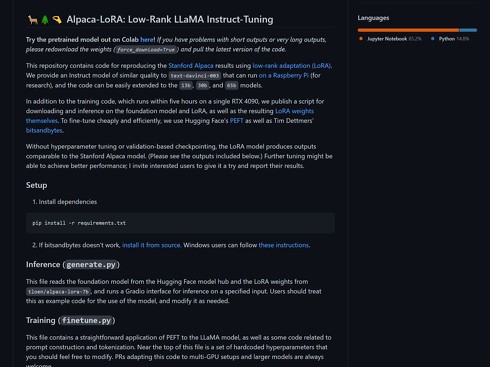

アンドレネコさんが紹介したと思われるのは、米スタンフォード大学が公開したLLM「Stanford Alpaca」を再現したという「Alpaca LoRA」。単一のGPU「RTX 4090」で5時間ほど学習させることで利用可能で、Raspberry Pi上で動かせるほど軽量なのが特徴という。GitHubからアンドレネコさんの報告ツイートへのリンクが設定されていることから、アンドレネコさんが実際に稼働するか検証したと思われる。

LLaMAは米Metaが独自開発した大規模言語モデル。LLM分野の研究推進を支援するため、研究者向けに2月にリリースした。大規模インフラを利用できない研究者のために小規模ながら性能の高いことが特徴で、7B(=70億)、13B、33B、65Bの4種類のパラメーターを用意している。13Bモデルはベンチマークで米OpenAIのLLM「GPT-3」を上回るという。

米スタンフォード大学は、LLaMAの7Bモデルを派生させ独自のLLM「Stanford Alpaca」を開発。このモデルは研究や学術目的でのみ利用でき、娯楽や商用での利用は禁止している。Alpaca LoRAでは、Stanford Alpacaが生成するトークン(単語列)を再現できるという。

関連記事

Meta、独自大規模言語モデル(LLM)の「LLaMA」を限定リリース

Meta、独自大規模言語モデル(LLM)の「LLaMA」を限定リリース

Metaは独自の大規模言語モデル「LLaMA」(Large Language Model Meta AI)を研究者向けにリリースした。「ChatGPT」のLLM「GPT-3.5」よりも小規模でも高性能としている。 Google、GPT競合のLLM「PaLM」のAPIを提供へ 生成系AIアプリ開発を支援

Google、GPT競合のLLM「PaLM」のAPIを提供へ 生成系AIアプリ開発を支援

Googleは、大規模言語モデル(LLM)「PaLM」のAPIを発表した。PaLMのトレーニングツール「MakerSuite」と生成系AIアプリ開発プラットフォーム「Generative AI App Builder」も発表。まずはプライベートプレビューで提供を開始する。 Microsoft 365 Copilotでできること──プロンプト例で紹介

Microsoft 365 Copilotでできること──プロンプト例で紹介

Microsoftが発表したLLM採用のビジネス支援ツール「Microsoft 365 Copilot」はどう使う? Word、Excel、PowerPoint、Outlook、Teams、Business Chatで使えるプロンプト例で紹介する。 「GPT-4」発表 日本語でもChatGPT英語版より高性能、司法試験で上位10%、「この画像何が面白いの?」にも回答

「GPT-4」発表 日本語でもChatGPT英語版より高性能、司法試験で上位10%、「この画像何が面白いの?」にも回答

大規模言語モデル「GPT-4」が登場。テキストでのやり取りだけでなく、ユーザーから画像も受け取れるようになった。司法試験の模擬問題を解かせると上位10%のスコアで合格する。ChatGPTの有料版やAPI経由でこれから利用可能になる。 AIプロ集団から見た「ChatGPTの歴史」 たった5年で何が起こったのか

AIプロ集団から見た「ChatGPTの歴史」 たった5年で何が起こったのか

AIのプロ集団であるELYZAが現在大流行中の「ChatGPT」について、その進化の歴史を解説した。ほとんどの出来事はここ5年以内に起こっており、市場環境は目まぐるしく変化している。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR