最小のAIハード「エッジデバイス」の選び方 SBC、FPGA、産業用組み込みPCを解説(1/2 ページ)

2012年、カナダ・トロント大学のジェフリー・ヒントン教授らが、画像認識コンペでディープラーニングの威力を示したことで、第3次AIブームが巻き起こった。AIはその後も予想を超える速度で進化し、今では「Midjourney」や「ChatGPT」といった生成系AIが、さまざまなシーンで活用されるようになっている。

こうしたAIの急速な発展を支えているのが、AI演算を効率良く実行できるAIハードだ。一口にAIハードといっても、スパコンからエッジまでさまざまな製品があり、用途によって最適な製品が異なる。そこでこの特集では3回に分けて、用途別にAIハードの選び方を解説したい。

エッジデバイスの「エッジ」ってどういう意味?

第1回は、AIハードの中でも1番小さなハードであるエッジデバイスを取り上げる。エッジとは、「端」という意味を表す言葉であり、ITの文脈ではネットワークの末端を指す。具体的にはスマートフォンやPCなどがエッジとなるが、IoTデバイスもエッジの代表に含まれる。特にAIハードとしては組み込み用のSBC(シングルボードコンピュータ)を指すことも多い。

エッジデバイスは、小型で消費電力が小さく、コスト的にも安いことが利点である。AI処理は、AIモデルの学習(トレーニング)と、学習させたAIモデルを使った推論(インファレンス)に分けられるが、学習のほうが推論よりも遙かに負荷が高いため、エッジデバイスでのAI処理は、基本的に推論が対象となる。こうしたエッジでのAI処理はエッジAIと呼ばれる。

AI向けSBCの代表製品4種、その特徴は?

エッジAIのためのデバイスの代表がSBCである。特にエッジAIに適した製品としては、「Raspberry Piシリーズ」「Beagle Boneシリーズ」「NVIDIA Jetsonシリーズ」「Tinker Board S」などが挙げられる。それぞれのデバイスの特徴を簡単に紹介する。

- Raspberry Piシリーズ

英Raspberry Pi財団が開発しているRaspberry Piシリーズは、特にAI向けに開発されたSBCではないが、最も広く使われているSBCであり、ユーザーが多く、資料が多いことが利点だ。

また、入出力端子が豊富で、カメラモジュールなどの拡張モジュールが数多く販売されているため、プロトタイピングに向いている。一方、AI用アクセラレータを搭載しているわけではないので、AI処理のための演算性能が足りないこともある。ただし、SoC内蔵のGPU「VideoCore VI」を利用してAI処理を高速に行うプラットフォームを開発している企業もある。

- BeagleBoneシリーズ

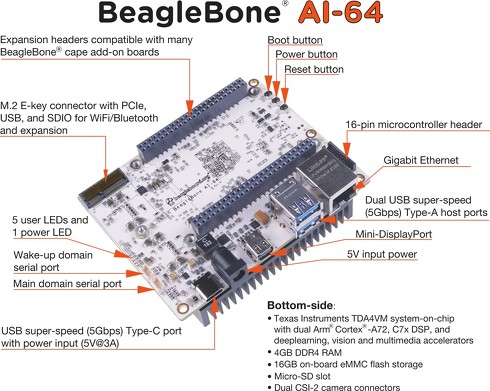

BeagleBoneシリーズは、Raspberry Piよりも高速なSoCを搭載しており、処理性能が高いことが利点。しかし、技適(技術基準適合証明)を取得していないため、無線機能を搭載した製品でも日本国内では無線機能を利用できないという欠点がある。

BeagleBoneシリーズの中でも「BeagleBone AI-64」は、AI向けの製品であり、SoC以外にAI処理用のDSPやCPUなどを搭載し、高い演算性能を実現しているため、大規模なAIモデルを使った推論にも適している。

- NVIDIA Jetsonシリーズ

米NVIDIAは、AI向けの製品ラインアップが非常に充実してるベンダーであり、エッジデバイスとして「NVIDIA Jetsonシリーズ」をリリースしている。

高性能な「Jetson AGX Orin」や「Jetson AGX NX」から、小型で価格が安い「Jetson Orin Nano」までさまざまな製品があり、どの製品もCPUと別に高速なGPUを搭載し、SBCとしてはトップクラスの演算性能を誇る。特にフラグシップモデルの「Jetson AGX Orin 64GB」では、275TOPSという高い性能を実現しており、自動運転のように高い演算性能が要求される用途に向いている。

- Tinker Board S

ASUS製のSBCで、Raspberry Piよりも高速なCPUとGPUを集積したSoC「Rockchip RK3288」を搭載する。前モデルの「Tinker Board」には搭載されていなかった16MBのeMMCをオンボードで載せており、microSDを使わずにシステムの起動が可能に。前モデルに比べて動作の安定性も向上している。サイズはRaspberry Piと同じで、Raspberry Piでは演算性能が足りない場合にもおすすめ。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR