“画像の面白さ”を解説できるAI「MiniGPT-4」 写真からラップや詩、料理レシピ作成 デモサイトも公開中:Innovative Tech(1/2 ページ)

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。Twitter: @shiropen2

サウジアラビアのキング・アブドゥッラー科学技術大学に所属する研究者らが発表した論文「MiniGPT-4: Enhancing Vision-language Understanding with Advanced Large Language Models」は、画像の視覚的特徴を捉えて大規模言語モデル(LLM)で高品質な言語出力を行うシステムを提案した研究報告である。ユーザーは、画像1枚と何をして欲しいかの文章をセットに入力すると、画像に応じたテキスト回答が得られる。

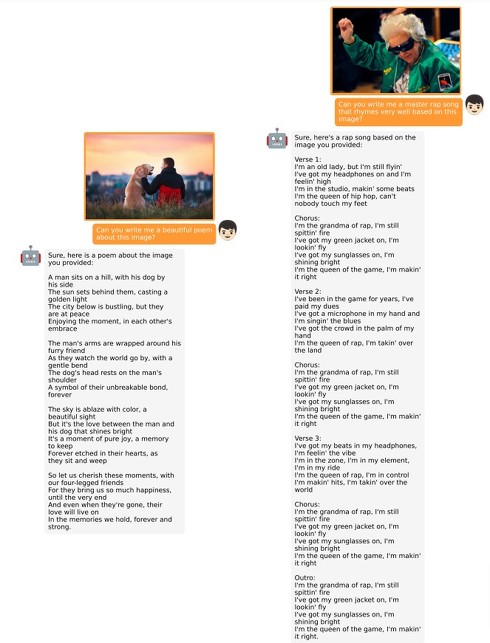

「MiniGPT-4」と呼ぶこのシステムは、GPT-4と同様に、画像の詳細な説明文の生成、画像の面白さの特定、手書きのテキストからWebサイトの生成などができる。

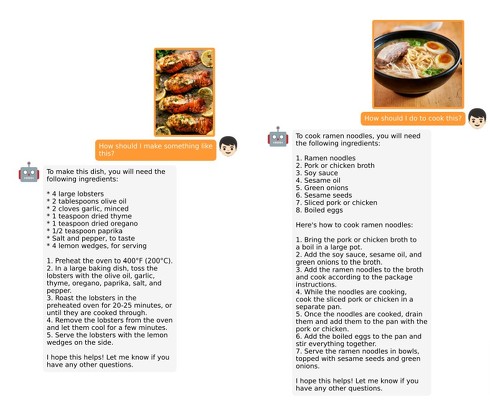

さらに、MiniGPT-4では他にも「料理の写真を見て詳しいレシピを作成する」「画像からインスピレーションを得て詩やラップを作る」「画像のストーリーを書く」「画像で商品の広告を作る、個人の識別、鋭い画像コメントを付ける」などを行えるという。

入力プロンプトの具体例としては、「なぜこの画像が面白いのか説明してください」や、枯れかけの植物の画像とともに「この植物は何が問題なのか?」などである。

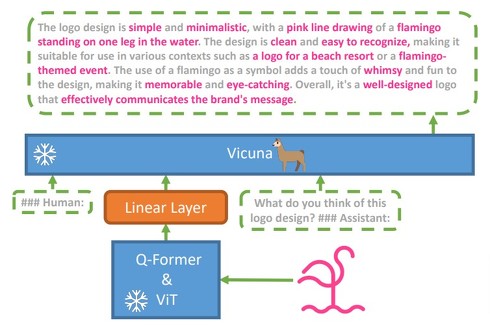

MiniGPT-4では、事前学習されたビジョンエンコーダーとLLMを連携させたシステムを採用する。具体的には、言語デコーダーとして大規模言語モデル「LLaMA」をベースに構築し、幅広い複雑な言語タスクを実行できるAIチャット「Vicuna」を利用している。

また、視覚-言語モデルの効率的な事前学習が行えるフレームワーク「BLIP-2」で使用される、画像認識モデル「Vision Transformer」(ViT)と、画像エンコーダーとLLMの間を橋渡しする役割のクエリ変換器「Q-Former」を利用している。

効果的なモデルを実現するために、研究チームは2段階のトレーニングアプローチを提案する。第1段階では、画像とテキストのペアを大量に収集し、視覚言語の知識を獲得するためにモデルを事前学習する。第2段階では、会話テンプレートを設計した、より小さいが高品質の画像テキストデータセットを用い、事前学習したモデルを微調整、モデルの生成信頼性と使いやすさを向上させる。

これにより、GPT-4に匹敵する精度の言語出力を達成した。プロジェクトページでは、ブラウザ上で試せるライブデモも公開されている。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR