米Microsoftら、“コーディング専用”大規模言語モデル「WizardCoder」開発 文章から高品質なコード出力:Innovative Tech

Innovative Tech:

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

Twitter: @shiropen2

米Microsoftや香港浸会大学に所属する研究者らが発表した論文「WizardCoder: Empowering Code Large Language Models with Evol-Instruct」は、米Hugging Faceが5月に発表したCode LLM(コーディング専用大規模言語モデル)「StarCoder」を軽量で高精度に強化する手法を提案した研究報告である。リポジトリはこちら。

コード生成に関連する課題に取り組むため、多数のCode LLMが提案されている。これらのCode LLMは、大量のコードデータを使用して事前学習を行うことで、さまざまなコード関連のタスクで優れた性能を発揮し、素晴らしいパフォーマンスを示している。しかし、既存のモデルのほとんどは、コードデータを用いて事前学習を行っているが、命令データの微調整は行っていない。

この研究では、命令データを自動生成する「Evol-Instruct」をコードのドメインに適応させることで、複雑な命令の微調整でCode LLMを強化する「WizardCoder」を提案する。コード固有のEvol-Instructを通して複雑なコード命令データを生成することにより、SOTAオープンソースのCode LLMである「StarCoder」の機能を強化する。

これを実現するために、まず基本的なコード命令データである「Code Alpaca」を進化させ、次に新たに作成したコード命令学習セットを用いてStarCoderの微調整し、WizardCoderを得る。

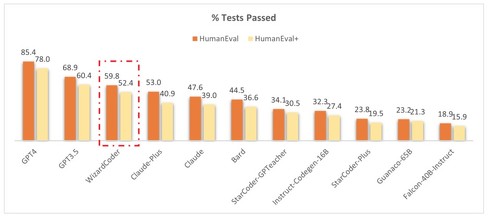

HumanEval、HumanEval+、MBPP、DS-100の4つのコード生成ベンチマークで得られた実験結果は、WizardCoderが他の全てのオープンソースのCode LLMを超え、最先端の性能(SOTA)を達成したことを示した。

クローズドソースLLMと比較した場合は、GPT-4、GPT-3.5に続き3位であった。特筆すべきは、他のモデルに比べてサイズが大幅に小さいことである。サイズが小さいにもかかわらず、Claude、Bard、PaLM、PaLM-2、LaMDAなどと比較して、コード生成で優れた結果を達成した。

Source and Image Credits: Luo, Ziyang, Can Xu, Pu Zhao, Qingfeng Sun, Xiubo Geng, Wenxiang Hu, Chongyang Tao, Jing Ma, Qingwei Lin, and Daxin Jiang. “WizardCoder: Empowering Code Large Language Models with Evol-Instruct.” arXiv preprint arXiv:2306.08568(2023).

関連記事

Microsoft、法人向け「Bing Chat Enterprise」発表 正式版はユーザー当たり月額5ドルに

Microsoft、法人向け「Bing Chat Enterprise」発表 正式版はユーザー当たり月額5ドルに

Microsoftは2月から提供している「新しいBing」の法人版「Bing Chat Enterprise」を発表した。同日からプレビュー版を法人版「Microsoft 365」ユーザーに無償提供するが、正規版はユーザー当たり月額5ドルにする計画だ。 法人向け「Microsoft 365 Copilot」はユーザー当たり月額30ドルに

法人向け「Microsoft 365 Copilot」はユーザー当たり月額30ドルに

Microsoftは、法人向け「Microsoft 365」で提供するAIツール「Copilot」の価格を、1ユーザー当たり月額30ドルと発表した。Copilotは現在早期アクセスプログラム中で、正式版については向こう数カ月以内に発表するとしている。 言語生成AIの入力文、最初と最後に“重要情報”を入れた方が良い結果に 米スタンフォード大などが検証

言語生成AIの入力文、最初と最後に“重要情報”を入れた方が良い結果に 米スタンフォード大などが検証

米スタンフォード大学などに所属する研究者らは、大規模言語モデル(LLM)の性能について、入力コンテキストの長さや関連情報の位置を変えることでどのような影響があるかについて調査した研究報告を発表した。 生成AIに“生成AIが作った文章”を学習させ続けるとどうなる? 「役立たずになる」と英国チームが報告

生成AIに“生成AIが作った文章”を学習させ続けるとどうなる? 「役立たずになる」と英国チームが報告

英オックスフォード大学や英ケンブリッジ大学、英インペリアル・カレッジ・ロンドン、米トロント大学に所属する研究者らは、GPT-4などの大規模言語モデル(LLM)が別のLLMが生成したテキストを学習し続けるとどうなるかを調査した研究報告を発表した。 企業の“生成AI活用”のトレンドは? 他社モデル活用と独自モデル開発、東大発ベンチャー・ELYZAが解説

企業の“生成AI活用”のトレンドは? 他社モデル活用と独自モデル開発、東大発ベンチャー・ELYZAが解説

国内外問わず、さまざまな企業で言語生成AIの利用が急速に進んでいる。東大発ベンチャー・ELYZAは、他社製のAIモデルを活用する動きと、独自の大規模言語モデルを開発する動きの2つがトレンドになっていると指摘。それぞれの特徴について解説した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR