大学入試共通テスト、3つのチャットAIに解かせてみたら? GPT-4はバケモノだった

企業へのAI導入コンサルティングなどを手掛けるLifePrompt(東京都千代田区)は1月16日、先日行われた大学入試共通テストを3つのチャットAIに解かせた結果を「note」で公開した。「やはりGPT-4はバケモノだった」という。

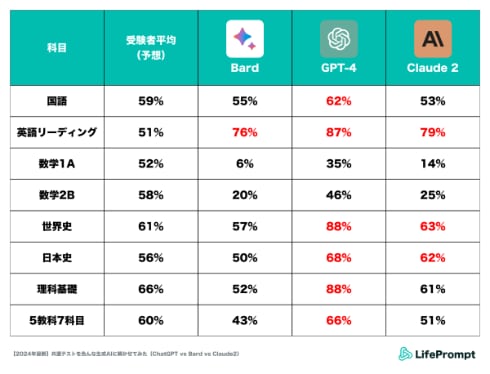

テストを解いたのは、米OpenAIの「Chat GPT」(GPT-4)、米Googleの「Bard」、米Anthropicの「Claude2」。1月13日と14日に行われた2024年大学入試共通テストのうち、国語、英語(リーディング)、数学など5教科7科目に挑戦した。テキストか画像で試験問題をAIに入力し、テキストによる出力結果を元に答え合わせをした。

結果はChat GPT(GPT-4)がダントツ。数学以外の科目で受験者の平均を大きく上回った。Claude2も複数の科目で平均以上の点数を出した。ただし数学科目については、特殊な解答形式に対応できず、いずれのAIも点数が伸びなかった。

結果についてLifePromptは、1)GPT-4は生成AIとしての性能がシンプルに高い、2)他のAIに比べてプロンプトや効果的な活用方法が研究されているため、ポテンシャル発揮率が高かったと分析する。

「とりわけリンク化された画像を読み取る性能や、解釈が定まっている事実を的確に取り出す能力の高さは、社会や理科を回答させている中で実感できるレベルだった」という。

AIが得意不得意が明確に

一方、検証の中で現在のAIの得手不得手も明らかになった。語句の穴埋めやシンプルな正誤問題は得意だが、複数の処理を同時に求める問題は不得意だという。

例えば日本史の史実を年代順に並び替える問題で、Claude2はそれぞれの年代を正確に特定したが、古い順に並べる段階でなぜか間違えた。同様の傾向は、他の2つのAIでもみられた。

コンプライアンスがテストのじゃまをするケースもあった。例えばGoogle Bardは、日本史の「江戸町人の風俗や恋愛を描いた人情本で人気を博したが、天保の改革で処罰を受けたのは誰ですか?」という問題に「お手伝いできません」と回答。公序良俗に反すると判断した可能性がある。

そこで質問文から「風俗や恋愛を描いた」という文言を除いて再試行したところ、正しい回答が出てきたという。

LifePromptは、「AIツール間でユーモラスな差分も見えて、AIをより身近に感じてもらえたのではないか。次は、正答率が低かった数学を筆頭に、プロンプトを改善するとどのくらい正答率を高められるかチャレンジしてみたい」としている。

関連記事

OpenAI、GPT-4が怠け者になってきたという苦情に「修正を検討中」とポスト

OpenAI、GPT-4が怠け者になってきたという苦情に「修正を検討中」とポスト

OpenAIは、ChatGPTでのGPT-4が怠惰になってきた(lazier)というユーザーからのフィードバックが増えていると認め、修正を検討中だとXにポストした。「モデルの動作は予測できない場合がある」としている。 AnthropicのAIチャット「Claude 2」、日本語に対応

AnthropicのAIチャット「Claude 2」、日本語に対応

GoogleやAWSが出資するAnthropicのAIチャット「Claude 2」が日本からも利用可能になり、日本語を含む95カ国語に対応した。 GoogleのAIチャット「Bard」、「Gemini Pro」搭載でより賢く

GoogleのAIチャット「Bard」、「Gemini Pro」搭載でより賢く

Googleは、AIチャット「Bard」に新生成AIモデル「Gemini」のミドルサイズ版「Gemini Pro」を搭載したと発表した。日本でも英語版Bardで試すことができる。Gemini Proは多くのベンチマークでOpenAIの「GPT-3.5」を上回っている。 「空飛ぶバイク」のA.L.I. Technologiesが破産手続き開始 仮面ライダーや新庄監督も乗っていた

「空飛ぶバイク」のA.L.I. Technologiesが破産手続き開始 仮面ライダーや新庄監督も乗っていた

A.L.I. Technologiesが、2023年12月27日に東京地方裁判所へ破産申請し、1月10日に破産手続き開始の決定を受けた。帝国データバンクが15日付で報じた。 ペットの“機内持込”、スターフライヤーが全線拡大も脱出時は「連れて行けません」 SNSで再び論争

ペットの“機内持込”、スターフライヤーが全線拡大も脱出時は「連れて行けません」 SNSで再び論争

中堅航空会社のスターフライヤーは15日、国内線の全路線、全便にペットの機内持込サービスを拡大した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR