ITmedia NEWS >

企業・業界動向 >

Meta、動画内アイテム識別AIモデル「SAM 2」をApache 2.0で公開

» 2024年07月30日 10時48分 公開

[ITmedia]

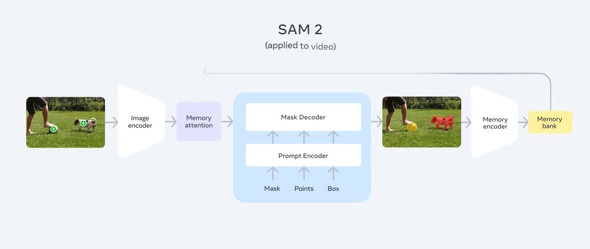

米Metaは7月29日(現地時間)、動画内のアイテムも識別できるAIモデル「Segment Anything Model 2」(SAM 2)を発表した。コードとモデルの重みを「Apache 2.0」ライセンスの下、GitHubで公開した。

また、SAM 2の構築に使ったデータセット「SA-V」を「CC BY 4.0」ライセンスでMetaのサイトで公開した。このデータセットは、約5万1000本の実際の動画と60万点以上の時空間マスクで構成されているというが、その動画がどこから持ってきたものかは明示されていない。

SAM 2は、昨年4月リリースの「SAM」のアップデート版。SAMは画像内から個々のオブジェクトを選択できるというものだったが、2では動画内のオブジェクトも選択できるようになった。

SAMは既に、科学や医学などの現場で活用されているという。例えば、海洋科学でのソナー画像をセグメント化することでのサンゴ礁の分析や、医療分野での細胞画像のセグメント化による皮膚がんの検出などに使われている。

SAM 2で動画内のセグメント化が可能になったことで、自動運転車のトレーニング用視覚データの注釈付けなどに貢献できるとしている。

関連記事

Meta、画像内アイテム識別のAIモデル「SAM」と大規模データセットを無償公開

Meta、画像内アイテム識別のAIモデル「SAM」と大規模データセットを無償公開

MetaのAI部門Meta AIは、画像内のオブジェクトをセグメント化するAIモデル「SAM」を無償公開した。また、このモデルのトレーニングに使った大規模データセット「SA-1B」も公開。従来のマスクデータセットの400倍の規模だ。 Meta、「Llama 3.1」ベースの「AI Studio」を米国で開始

Meta、「Llama 3.1」ベースの「AI Studio」を米国で開始

Metaは、最新LLM「Llama 3.1」採用のクリエイター向けツール「AI Studio」を米国で展開開始した。AIでキャラクターを設定したAI botを作成し、InstagramのDMなどで使える。 Meta、無料で商用可の「Llama 3.1」リリース 「世界最大かつ最も高性能なオープンモデル」

Meta、無料で商用可の「Llama 3.1」リリース 「世界最大かつ最も高性能なオープンモデル」

Metaは、“オープンソースの”LLMの最新版「Llama 3.1」を発表した。最大モデルは4050億(405B)のパラメータを持ち、米NVIDIAの1万6000個以上の「H100」でトレーニングした。AWSなどの環境で実行するために掛かるコストは、GPT-4oの約半分という。 Meta、ジェネレーティブAIのチーム結成を発表 AIペルソナ開発目指し

Meta、ジェネレーティブAIのチーム結成を発表 AIペルソナ開発目指し

MetaのザッカーバーグCEOは「ジェネレーティブAIチーム」結成を発表した。長期目標として、人間を支援するAIペルソナの構築を掲げた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR