電気がなくてもデータは消えない、メモリ技術の最新事情:「ムーアの法則」を超える新世代コンピューティングの鼓動(1/3 ページ)

前回は現在のコンピュータのアーキテクチャが抱える問題点とその回答の1つとして新しいアーキテクチャを紹介しました。今回は特にポイントとなる記憶領域について、詳しく解説します。

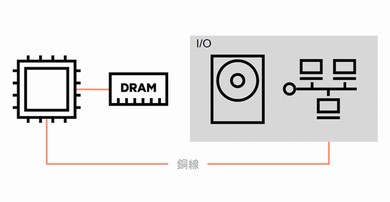

約60年間変わっていないコンピュータのアーキテクチャの一つに、階層化された記憶領域があります。CPUにSRAM(Static Random Access Memory)で構成されたキャッシュがあり、DRAM(Dynamic Random Access Memory)で構成されたメインメモリあるいは主記憶装置と呼ぶもの、そしてSSD(Solid State Drive)やディスクで構成された外部記憶装置あるいは補助記憶装置、さらにテープ装置などが接続されている、というのが今日のコンピュータのよくある形です。

なぜこのようになっているのでしょうか。理由の1つは、電源を失うとデータが失われてしまうため、データを永続化する仕組みが必要だからです。もう1つの理由は、SRAMやDRAMの容量単価が高いため、全てのデータをより安価な外部記憶装置に置く必要があったためです。

このような理由で階層化された記憶領域には、当然ながらアクセス速度に大きな差があり、容量単価が安くなればアクセス速度が遅くなります。その差は非常に大きいものです。

アクセス速度の違いがどれぐらい大きなものか、実社会の距離に例えてみましょう。仮に、プロセッサ内の処理に必要な1ナノ秒を1メートル歩く時間とします。

キャッシュに使われるSRAMは、5メートルほどの距離の移動に相当し、小幅で歩いても9歩程度の時間で済みます。メインメモリに使われるDRAMは、100メートルになります。やや時間はかかりますが、まだ現実的といえる範囲だと思います。今後、外部ストレージの主流になるSSDはどうでしょうか。距離にすると200キロほどになります。休まず歩いても4日になりますので、これぐらいの距離になれば、移動は自動車などの道具に頼ることになります。ディスクでは実に1万キロもの距離の移動に匹敵し、もはや飛行機に乗る距離です。テープについては、言わずもがなでしょう。

このように外部記憶装置のアクセス速度を高めるには、何らかの道具が必要になることが分かります。このため、これらのデバイス上にあるデータにアクセスするには、高速にアクセスするための仕組みが必要であり、キャッシュのようなものが必要とされる理由です。

CPUの速度に合わせるためのキャッシュはCPUキャッシュですが、DRAM上にもそれより圧倒的に低速な外部記憶装置のデータを扱うためのキャッシュが存在します。例えば、ファイルシステムのバッファキャッシュの場合、アクセス頻度の高いものや現在使用されているファイルは子のバッファキャッシュに置かれ、高速にアクセスできるようになります。

しかし、新たに別のファイルが必要になった場合はどうでしょうか。そのファイルは外部記憶装置から読み出されてキャッシュに載ります。このデータはDRAM上にあります。このままでは電源が失われてしまえば、データの中身が損なわれます。したがってキャッシュに載っているものは、永続性を保つために定期的に外部記憶装置に書き出される機構が含まれます。

関連記事

コンピュータの限界を変えるための3つの視点

コンピュータの限界を変えるための3つの視点

膨大なデータの活用を妨げになる現在のコンピュータの問題はどうすれば解決できるのでしょうか。今回はそのために必要な新しいコンピュータのアーキテクチャについて考えてみます。 IoTフル活用の未来に立ちはだかるコンピュータの課題とは何か

IoTフル活用の未来に立ちはだかるコンピュータの課題とは何か

前回はIoT時代にデータを全て利用できれば、どのように便利な生活が実現されるかを取り上げました。ですが、すぐにこんな時代になるとは言い切れません。今回はITの側面における大きな問題点に触れてみたいと思います。 IoTのデータをフル活用した先にできることを予想すると……

IoTのデータをフル活用した先にできることを予想すると……

IoTの時代に私たち膨大な情報を得ることができます。この情報を全て有効に活用できたとしたら、どのようなことができるようになるのでしょうか。そのシナリオを占ってみます。 【新連載】コンピュータの進化はもう限界? ITの歴史で読み解くその真相

【新連載】コンピュータの進化はもう限界? ITの歴史で読み解くその真相

日進月歩で発展し続けてきたコンピュータの世界ですが、技術的な限界が近づきつつあると言われています。果たしてそれは本当なのでしょうか? これまでの常識にとらわれない新しい動きを紹介していきましょう!

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 初期侵入口は“またVPN” 日本医大武蔵小杉病院にランサムウェア攻撃

- 「2027年1月12日」は運命の日? サポート切れOSを使い続ける会社の末路

- 富士通、ソブリンAIサーバを国内製造開始 自社開発プロセッサー搭載版も

- ホワイトハッカーが明かす「ランサムウェア対策が破られる理由」と本当に効く防御

- Googleが「AI Threat Tracker」レポートを公開 Geminiを標的にした攻撃を確認

- シャドーAIエージェントを検出 Oktaが新機能「Agent Discovery」を発表

- SOMPOグループCEOをAIで再現 本人とのガチンコ対談で見えた「人間の役割」

- 「AI前提」の国家戦略と「思考停止」の現場 大半の企業で“何も起きない”未来を予見

- AIエージェント普及はリスクの転換点 OpenClawを例に防御ポイントを解説

- 生成AIの記憶機能を悪用して特定企業を優遇 50件超の事例を確認