ビッグデータ活用のヒント――BIの4モデルとは:ユーザー自身の「解」の発見を支援

ビッグデータの活用で新たなビジネス価値を模索する動きが活発化している。顧客のニーズを明らかにし、その実現を支えるCEPやHadoopなどの基盤技術について、NTTデータのキーマン3人に話を聞いた。

(このコンテンツは日立「Open Middleware Report vol.58」をもとに構成しています)

処理の高速化だけでない、新たな価値の創造を

日本最大級のSIerとして、企業や社会の発展を支えるソリューションを提供し続けているNTTデータ。同社は、RFIDや各種センサーなどから得られるセンシングデータ、ユーザーの購入履歴やSNSなどから得られるライフログデータなどが「ビッグデータ」として注目を集める以前から、増え続ける大量のデータを効率的に処理し、有効活用する取り組みをスタートさせていた。

その具体例の1つが、2008年から開始されたHadoop活用である。きっかけは、現在のHadoopで主流となる“バッチ処理の高速化”だけでなく、“大規模データをリーズナブルに蓄積・解析したい”というユーザーニーズへの現実解としての導入だったと、基盤システム事業本部の濵野賢一朗氏は振り返る。

「従来のDWHやRDBMSでは扱えないペタバイトクラスの大量データを迅速に解析するには何を使えばいいのか――そこを出発点に、われわれが探し出してきたツールがHadoopでした。当初は通信関連を中心とした業界内で特定の解析要求に応えるシステムという位置づけでしたが、数年もしないうちに金融や流通など幅広い業界から同様の要望が寄せられるようになり、一気に現在のビッグデータ活用という流れへシフトしていった感があります」

Hadoopを早い段階から導入し、大規模データ分析の構築・運用ノウハウを蓄積してきたNTTデータだが、これと並行し、次々と発生する大量データをリアルタイムに分析することで、これまでにない業務改革やサービス革新につなげる新たなBIの開発も進展させている。

「既存の処理を高速化するITアーキテクチャの導入だけでは、ビッグデータに対応したシステムとは言えません。データを分析して得られる新たな価値の創出を支援する仕組みこそが重要なのです」と技術開発本部の中川慶一郎氏は指摘する。

その仕組み作りのためには、顧客が持つデータの種類や分析内容に応じ、さまざまな粒度・鮮度を持つ多様なデータを柔軟に分析できる基盤設計を行う必要がある。分析基盤が構築できれば、市場の環境変化に即応できる企業経営を推進したり、ユーザーのニーズに合致したサービスを適切なタイミングで提供したりといった、ビッグデータの活用が可能となる。

ユーザー自身の答えを導く、BIの4モデル

しかし、どのようなデータからどのような形で新しい価値を見出していくのか、その“解”をユーザー自身が持ち得ていないのが現状だ。そこでNTTデータでは、長年にわたる豊富なBI案件の実績と多数のデータ分析コンサルティングの経験から、顧客ニーズに最適な情報活用のあり方を提示している。

その取り組みの1つが顧客ニーズを明らかにするためのBIの分類だ。NTTデータでは「集計分析型」「発見型」「WHAT-IF型」「プロアクティブ型」の4タイプにBIを分類し、顧客が望むデータ活用の形を明確化する取り組みを進めている。さらに、これら4種のBIに対して、これまで実施してきた200を超えるデータ分析事例をもとにした「予兆発見型」「予測・制御型」など9つの分析シナリオを適用している。これにより、顧客要求に最適なシステム実装を支援していくという。中川氏は次のように解説する。

「集計分析型は多次元分析ツールを使ってデータを集計し、その結果に基づいて“見える化”を行うタイプのBIです。DWHを元に売上や在庫、利益などの指標を視覚的に管理し、事実に基づく客観的で合理的な経営を実現することに向いています。次に発見型は、データマイニング技術を活用して、膨大なデータの中から隠れた関係性や規則性を発見するタイプ。この2つは現在広く普及している代表的なタイプのBIで、これまでにも多くの企業でさまざまな実績を上げてきました」

また、中川氏はこれからのビジネスに大きな変革をもたらす牽引力になる新しいタイプのBIとして、以下の2つを挙げる。

「WHAT-IF型は、新しい業務のやり方をデザインすると同時に、その効果を事前に試算するタイプのBIです。未知の取り組みとなる業務改革には常に大きなリスクが伴いますが、過去のデータや業務上の制約などを織り込んだリアルなシミュレーションを行うことで、そのインパクトを事前に推計できるため、業務改革を推進するテコの役割を果たします。もう1つのプロアクティブ型は、ユーザー行動に基づいて一歩先回りしたサービスを提供するBIであり、リコメンドサービス、ネットワーク攻撃への予兆検知、不審な決済行動の検出によるマネーロンダリングの防止措置などに活用できます」

蓄積されたデータだけでなく、リアルタイムに発生しているデータを活用する点から、NTTデータでは4年ほど前から、このプロアクティブ型BIの必要性と有効性を提案してきたという。

当時は膨大なデータをリアルタイムに分析し、適切なアクションを実施できる技術が普及していなかったため後者2つのBIを現実的なコストで実現するのは難しかった。しかし、ここ数年の基盤技術の進化によって、その問題が解決しつつある。

複合イベント処理技術でリアルタイム分析を実現

従来のBIでは、データを一度貯めてから処理するのが一般的とされている。しかし現在のビッグデータ活用では、データの発生から活用までの時間差が非常に短くなっており、データを蓄積する前に分析処理を終わらせておかないと、そのデータの価値が下がってしまう場合がある。

「例えば、株式などを自動売買するアルゴリズムトレードや、ITS(高度道路交通システム)における交通状況のモニタリングなどがそれにあたります。そこで、絶え間なく到着するストリームデータをリアルタイム処理するための基盤技術としてわれわれが適用しているのがCEP(Complex Event Processing:複合イベント処理)です」と技術開発本部の横川雅聡氏は説明する。

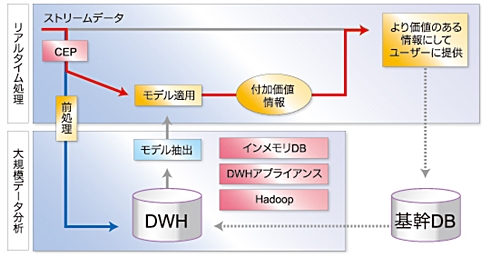

CEPは、多数のソースから発生するデータをミリ秒レベルで高速処理する技術である。一連の処理はすべてメモリ上で行い、HDDは基本的に使用しない。プロアクティブ型BIを構成するIT基盤は、フロントエンドのリアルタイム処理と、バックエンドの大規模データ分析をシームレスに連結する形で構成される。つまり、過去に蓄積したデータをバックエンドでモデル化し、そこで得たルールやロジックに基づいてフロントエンドのCEPで処理することで、瞬時に付加価値の高い情報を生み出していくという仕組みである。

ハイブリッド型のシステムで効率的に大量データを分析

CEP製品の開発は国内外の主要ベンダーによってすでに進められている。そのうちの1社が2008年11月よりストリームデータ処理基盤製品「uCosminexus StreamData Platform」を提供している日立製作所だ。

「コストを度外視するなら、CEPを手組みで構築できることは以前から理解していました。しかし3年ほど前、初めて日立のuCosminexus Stream DataPlatformを見た時は、これが基盤製品としても実現できるのかと驚いた記憶があります。ただし、当時はまだ大規模データ分析の方が追いついていない状態で、お客さまのニーズも今ほど顕在化していなかった。そんな時代でしたね」と中川氏は振り返る。

一方、大規模データ分析ではDWHアプライアンスやHadoop、インメモリDB、KVS(Key-Value Store)などの基盤製品を適用する。これらの技術はレイテンシーやデータ構造(構造化/非構造化)、扱えるデータ量にそれぞれ違いがあるため、適材適所で使い分けることが必要だ。従来のRDBMSも決してその役割を終えたわけではなく、これらの選択肢と相互補完的にデータストアの重要なポジションで活用されることになる。

「例えば、数時間前までの時系列データ処理はインメモリDBやKVSの層で行い、数日〜数ヶ月前のデータ処理はDWHアプライアンス、それ以上時間を遡るデータ処理はHadoopで行うといった方式選択が考えられます」(横川氏)

こうした観点から、NTTデータでは各層のアーキテクチャを柔軟に組み合わせ、最適なパフォーマンスを発揮できるビッグデータ活用のハイブリッドモデルを提唱している。

今後、NTTデータでは大量のデータが発生するさまざまな分野において、プロアクティブ型BIに代表される次世代BIの普及展開を図っていく予定だ。そこで重要なポイントになるのが、顧客要件にきめ細かく対応するための基盤技術の品揃えである。

「いま注目しているのが、東京大学と共同研究開発している日立の超高速データベースエンジンです。大量データを扱いつつ、場合によってはインメモリDBに近いレイテンシーが出せるため、大規模データ分析における選択肢を一段と拡大してくれるものと考えています」(横川氏)

多様な分析のための基盤を固めビッグデータの価値を高める

早い段階からビッグデータ活用に取り組んでいる企業では、すでにさまざまな経営メリットや競争優位性を顕在化させている。だが、加速度的に増え続けるビッグデータを、よりリアルタイムに的確な意思決定に反映させていくためには、「まだ乗り越えるべき課題がいくつも残っている」と横川氏は指摘する。

「システムレベルでは、クライアント側で利用されている分析ツールがビッグデータの処理に追随できていない現状があります。このため、これまでクライアント側の分析ツールで行っていたデータ管理や分析処理を、DWH内で行う形での実装を進めていかなければなりません。また、オンプレミスやクラウドといった提供方式への対応も必要です。活用レベルでも、数値データの分析にとどまらず、多様なデータに基づく傾向分析や予測・コントロールなどを展開していくことが求められます」(横川氏)

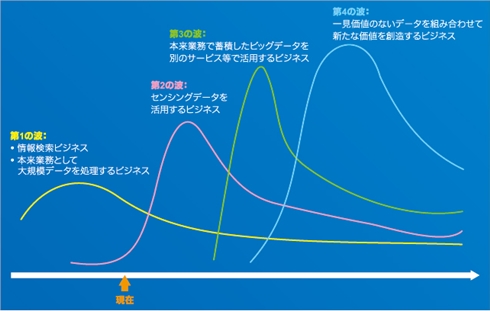

NTTデータが独自にまとめたビッグデータ活用の発展モデルでは、「1.本来業務の大規模データ処理」「2.センシングデータの活用」「3.本来業務以外でのデータ活用ビジネス」「4.一見無関係のデータから新たな価値を創造するビジネス」といった4つの波の到来を予測している。中川氏は今後の展望を次のように語る。

「現在はそのうちの第2の波が立ち上がりかけている段階に過ぎません。われわれは今後、こうしたロードマップに沿ってビッグデータの分析価値を高めながら、企業の競争力向上に力を注いでいくつもりです」

関連記事

スポーツ分野への適用も――ビッグデータの新たな価値を見出す

スポーツ分野への適用も――ビッグデータの新たな価値を見出す

新たな価値創造に欠かせないソリューションとして期待が高まるビッグデータ。JSOLは既存の事業領域における新たな価値提供と、これまでにないビジネスモデルの創出という2つのアプローチから取り組みを始めている。- 第一弾は金融機関向けに:ビッグデータを包括的に支援する「vRAMcloud」を発表 日立

各種ソフトウェア製品と新たなフレームワークを組み合わせたビッグデータソリューションを日立が発表した。まずは金融業界に提供を開始する。  日立がCosminexusの新版発表 ビッグデータ活用やPaaS管理のニーズに応える

日立がCosminexusの新版発表 ビッグデータ活用やPaaS管理のニーズに応える

Cosminexusの最新バージョン「V9」には、ビッグデータの活用やプライベートクラウドへの移行を図る企業を支援する製品が追加される。 「大量データ」活用に向けた技術の選択基準は

「大量データ」活用に向けた技術の選択基準は

世の中で扱われるデータ量が増加する中、企業ではこうした「大量データ」を活用する動きが本格化しつつあります。ではどのような技術を適用していけばよいのでしょうか。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 一気読み推奨 セキュリティの専門家が推す信頼の公開資料2選

- NTTデータ、仮想化基盤「Prossione Virtualization 2.0」発表 日立との協業の狙いは

- ホワイトハッカーが明かす「ランサムウェア対策が破られる理由」と本当に効く防御

- 7-Zipの偽Webサイトに注意 PCをプロキシノード化するマルウェア拡散

- Claude拡張機能にCVSS10.0の脆弱性 現在も未修正のため注意

- NTTグループは「AIがSI事業にもたらす影響」をどう見ている? 決算会見から探る

- ドローンいらず? 飛行動画作成できる「Google Earth Studio」登場

- 500万件のWebサーバでGit情報が露出 25万件超で認証情報も漏えい

- 「SaaSの死」騒動の裏側 早めに知るべき“AIに淘汰されないSaaS”の見極め方

- Gartner、2026年のセキュリティトレンドを発表 6つの変化にどう対応する?

基盤システム事業本部 OSSプロフェッショナルサービス シニアエキスパート 濵野 賢一朗氏

基盤システム事業本部 OSSプロフェッショナルサービス シニアエキスパート 濵野 賢一朗氏 技術開発本部 IT活用推進センタ ビジネスインテリジェンス・ソリューション担当 部長 中川 慶一郎氏

技術開発本部 IT活用推進センタ ビジネスインテリジェンス・ソリューション担当 部長 中川 慶一郎氏 NTTデータが考える4つのBI

NTTデータが考える4つのBI 技術開発本部 IT活用推進センタ シニアエキスパート 横川 雅聡氏

技術開発本部 IT活用推進センタ シニアエキスパート 横川 雅聡氏 プロアクティブ型BIデータ分析基盤のアーキテクチャ

プロアクティブ型BIデータ分析基盤のアーキテクチャ