データ分析をクラウドでやれば、コストは4分の1に――みずほ銀行が「BigQuery」を試して分かったこと:実用性を測る“3つの検証”(1/2 ページ)

データ分析の高度化と分析に使うデータ量の増加に伴い、オンプレミスでの環境に限界が見えてきたというみずほ銀行。分析基盤をクラウドに移すため、Google Cloud Platformを試したという同社が得た知見とは。

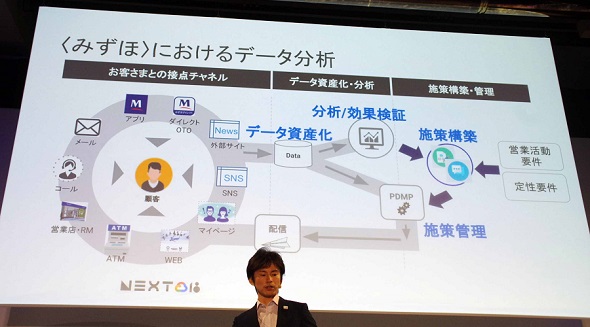

昨今、FinTechなどを背景に金融業界でのデータ活用が進んでいるが、同時にデータ分析の難度も大きく高まっている。WebのアクセスログやSNSでの行動など、テクノロジーの進化によって収集、分析すべきデータは増え続けており、施策の構築までも含め、膨大な工数を取られるケースも少なくない。

素早く有効な施策を打ちたいのに、分析に時間がかかり過ぎてしまう――メガバンクのみずほ銀行もそんな悩みを抱えていた。データの抽出からクレンジング、加工と、分析したいデータが増えれば増えるほど、その“前準備”にかかる時間も増えていくためだ。同社は、オンプレミス環境に1000人規模の社員が利用するDWH(Teradata)があるものの、データ加工などに向くツールではなく、データの増加に対応し切れなくなってきたのだという。

データ分析基盤をクラウドへ Google Cloud Platformで検証

「機能の拡張性や外部データとの連携などの視点で考えれば、データの加工や分析については、クラウド上で行うのが理想的だといえます」

こう話すのは、同社の個人マーケティング推進部の山泉亘さんだ。大手複合機メーカーでクラウド化を進めてきた経験を生かし、2018年にみずほ銀行に転職。みずほ銀行でもクラウド活用を進める活動を行っている。

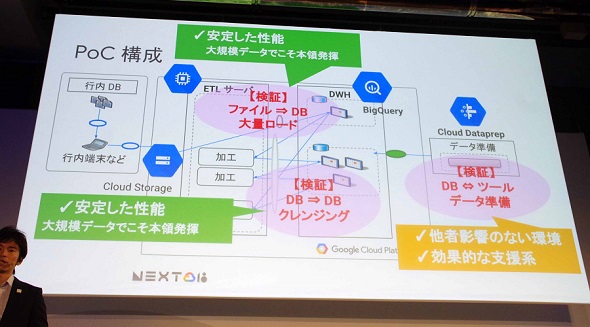

データ分析基盤をパブリッククラウドへと移行することを検討している中で、GoogleのBigQueryに注目し、IT部門とPoCを共同企画。Googleに相談したところ、ちょうどBigQueryが東京リージョンで使えるようになるタイミングだったため、アルファユーザーとして参加したという。PoCを実施したのは2018年の3月のこと。社内システムからGoogle Cloud Storageにデータを手動コピーする形で行い、3つの項目を検証した。

- Google Cloud StorageからBigQueryへデータを読み込ませる際の性能

- GCP上のETLサーバで加工したデータをBigQueryへ読み込ませる際の処理性能

- データ分析準備サービス「Cloud Dataprep」の性能

検証の結果、BigQuery周りについては「現状使っているTeradataと同等の性能」が得られ、Cloud Dataprepについては、データ処理方法のレコメンドなどの支援機能が有用であり、ユーザー部門自らがデータ準備ができることを確かめられたという。しかし、PoCの中でいくつか反省すべき点があったと山泉さんは話す。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 知らない番号でも一瞬で正体判明? 警察庁推奨アプリの実力を検証

- 生成AIで消えるのは仕事、それとも新人枠? 800職種のデータから分かったこと

- Windows RDSにゼロデイ脆弱性 悪用コードが22万ドルで闇市場に流通

- もはやAIは内部脅威? 企業の73%が「最大リスク」と回答

- 政府職員向けAI基盤「源内」、18万人対象の実証開始 選定された国産LLMは?

- ZIPファイルの“ちょっとした細工”で検知停止 EDRも見逃す可能性

- M365版「Cowork」登場 Anthropicとの連携が生んだ「新しい仕事の進め方」

- 「ExcelのためのChatGPT」ついに登場 GPT-5.4で実用レベルに?

- その事例、本当に出して大丈夫? “対策を見せたい欲”が招く逆効果

- 本職プログラマーから見た素人のバイブコーディングのリアル AIビジネス活用の現在地

みずほ銀行 個人マーケティング推進部 調査役 山泉亘さん

みずほ銀行 個人マーケティング推進部 調査役 山泉亘さん