NECの取り組みから探る 生成AIのリスクに「生成AIで」どう対応する?:Weekly Memo(1/2 ページ)

生成AIが抱えるハレーションや情報流出などのリスクが、ビジネスで利用する上で課題になっている。こうしたリスクに生成AIでどう対応できるのか。NECの研究開発の取り組みから探る。

この記事は会員限定です。会員登録すると全てご覧いただけます。

生成AIがもたらすリスクに生成AIで対応する――。そんな技術の研究開発を進めているNECが、その取り組みについて2024年9月18日、研究開発拠点がある神奈川県川崎市中原区のNEC玉川事業場で記者説明会を開いた。今回はその内容を取り上げ、生成AIがもたらすリスクに生成AIでどこまで対応できるのかについて考察したい。

生成AIがもたらす「新たなセキュリティリスク」

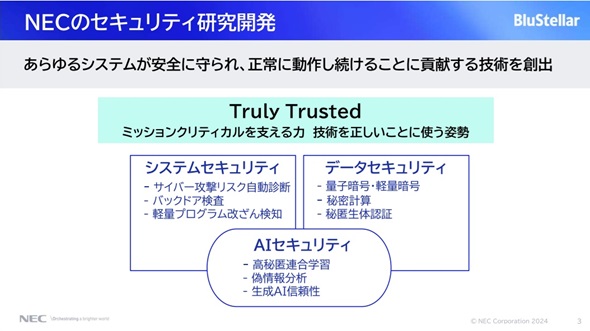

「当社が価値創造を支える事業ブランドとして推進している『BluStellar』(ブルーステラ)では、生成AIとセキュリティをキーテクノロジーとして挙げ、両分野の研究開発に注力している。今回の説明会では、特にこの両分野を掛け合わせた『生成AI×セキュリティ』における研究開発の取り組みを紹介したい」

NEC セキュアシステムプラットフォーム研究所 所長の藤田範人氏は、説明会でこう切り出した。

藤田氏によると、同社のセキュリティ分野における研究開発は「Truly Trusted」というコーポレートメッセージのもと、「あらゆるシステムが安全に守られ、正常に動作し続けることに貢献する技術を創出する」ことをミッションとして、「システムセキュリティ」「データセキュリティ」「AIセキュリティ」の3つのテーマについて取り組んでいる(図1)。

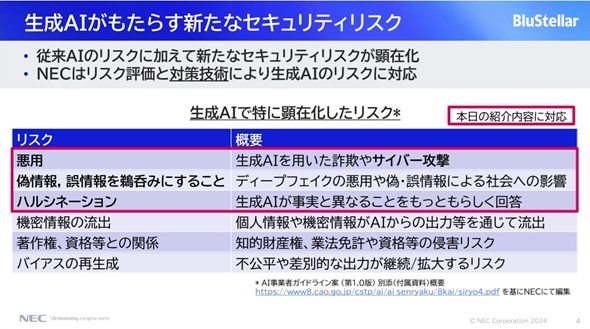

その上で、同氏は「従来のAIのリスクに加えて新たなセキュリティリスクが顕在化するようになってきた」と指摘し、2024年4月に政府が発表した「AI事業者ガイドライン」から生成AIで特に顕在化したリスクをピックアップしたものを表1に示した。

表1の内容について藤田氏は、「悪用と偽・誤情報のリスクは、生成AIが持つ非常に高いコンテンツの生成品質に起因している。また、ハルシネーションや機密情報の流出は、生成AIの出力が必ずしも制御できるものではないといった特性に基づくリスクだ」との見方を示した上で、「当社はこれらのリスク評価と対策技術によって生成AIリスクを低減し、解消するというアプローチで対応している」と強調した。

今回の記者説明会では、表1の赤枠で囲まれた3つのリスクについて、それぞれの対策技術が紹介された。サイバー攻撃への悪用には「LLM(大規模言語モデル)を用いたセキュリティリスク診断」、偽・誤情報には「偽・誤情報分析」、ハルシネーションには「ハルシネーション対策機能」だ。それぞれの要点は以下の通りだ。

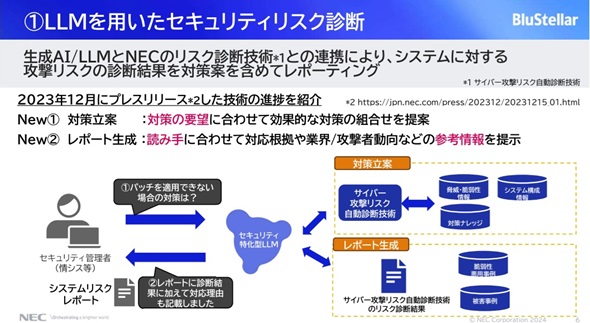

LLMを用いたセキュリティリスク診断

LLMを用いたセキュリティリスク診断は、NECがこれまで培ってきたセキュリティリスク診断の知見や独自のサイバー攻撃リスク診断技術をLLMと組み合わせることで、対話形式によるセキュリティリスク診断のシステムを開発したものだ。利用者はLLMに対して簡単な指示文を入力するだけで専門知識がなくても脆弱性調査や攻撃診断、また対策の立案まで対応できる(図2)。

藤田氏によると、「生成AIおよびLLMと当社のリスク診断技術との連携により、システムに対する攻撃リスクの診断結果を、対策を含めてレポーティングする」というのが特徴だ。

関連記事

- 「Weekly Memo」記事一覧

富士通とNECの最新受注状況から探る「今後の国内IT需要の行方とリスク」

富士通とNECの最新受注状況から探る「今後の国内IT需要の行方とリスク」

国内IT需要の今後の動きはどうなるか。どんなリスクがあるのか。富士通とNECの最新受注状況から探る。 NECの戦略から考察 DXを成功に導く「シナリオ作り」の勘所とは?

NECの戦略から考察 DXを成功に導く「シナリオ作り」の勘所とは?

DXに着手する企業は多いが、期待するほどの効果が出ていないのはなぜなのか。「DXを成功に導くシナリオをどう作るか」を焦点にしたNECのソリューションに着目し、考察する。 イオングループの「データの生かし方」「生成AIの使い方」とは? 外部人材登用の理由を考察

イオングループの「データの生かし方」「生成AIの使い方」とは? 外部人材登用の理由を考察

データ活用を社内にどう浸透させるか。生成AIをどう有効に使うか。データドリブン経営を目指すイオングループの事例を基に考察する。 近い将来、サイバー攻撃の17%に生成AIが関与する Gartnerが予測を発表

近い将来、サイバー攻撃の17%に生成AIが関与する Gartnerが予測を発表

Gartnerは世界の情報セキュリティ支出に関する調査結果を公開した。2024年に1839億ドルに達し、2025年には15.1%増加するとGartnerは予測している。この他、生成AIの導入がサイバー攻撃にも影響を及ぼすとし、全攻撃の17%に関与する見込みだ。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- 結局、M365 Copilotって元取れるの? グループ9000人に導入した住友商事に聞いた

- 生成AIを悪用か 世界55カ国で600台超のFortiGate侵害が発生

- VS Code拡張機能4件に重大な脆弱性 累計ダウンロード数は1.2億

- 悪いのは本当にVPN? 日本医科大武蔵小杉病院のランサムウェア事件をダークWebから解明

- 「SaaSの死」論議の本質はどこにある? Salesforceの取り組みから探る

- 能登の総合病院は「1000台規模の“遅いVDI”」をどう解消したのか?

- 中国AI3社がClaudeに大規模蒸留 Anthropicが指摘する「重大なリスク」

- 106カ国2516の標的をClaude Codeなどで偵察 FortiGate狙う攻撃が判明

- AIエージェントの乱立、コロコロ変わる規制 2026年「AIトレンド4選」を紹介

- Anthropicが「Claude Code Security」発表 脆弱性発見・修正はもうお任せ?

NEC セキュアシステムプラットフォーム研究所 所長の藤田範人氏(筆者撮影)

NEC セキュアシステムプラットフォーム研究所 所長の藤田範人氏(筆者撮影)