「AIコンピューティング需要は前年比10倍」 Google Cloudのインフラ、データ基盤、セキュリティのアップデートと導入事例まとめ:Google Cloud Next Tokyo 2025

Google Cloudは「Google Cloud Next Tokyo '25」を開催し、基調講演ではAIエージェント構築を支える最新技術や、国内大手企業の先進的な活用事例が明かされた。AIが自律的にシステムを運用する未来が、すぐそこに迫っていることを実感させる内容だ。

この記事は会員限定です。会員登録すると全てご覧いただけます。

Google Cloudは8月5〜6日の2日間、東京ビッグサイトを会場に「Google Cloud Next Tokyo '25」を開催した。2日目の基調講演ではAIエージェントの構築に利用できるインフラやデータ基盤、セキュリティ製品のアップデートが紹介された。合わせて、NPBエンタープライズやソニー、三菱UFJフィナンシャルグループ、セブン&アイ・ホールディングスといったユーザー企業の事例が公開された。

Google Cloudのインフラの進化と発展

まず、Google Cloudのカスタマーエンジニアリング 技術本部長の渕野大輔氏はインフラ部分における取り組みを紹介した。渕野氏は「生成AIの台頭により、AIコンピューティングの需要は前年比で10倍以上に増加。わずか8年間で1億倍に達した」と述べ、急増するAIコンピューティング需要が膨大な電力消費を伴っていると指摘した。同社が高い電力効率と演算性能を両立可能なAI専用チップ「TPU」(Tensor Processing Unit)の開発に継続的に取り組んでいると強調した。

同氏はハードウェアのレイヤからイノベーションを推進していることがクラウド企業の中でも「Google Cloudの唯一無二の強み」であり、「明確な差別化ポイント」だと強調。その具体的な成果として最新の第7世代TPU「Ironwood」のスペックを紹介した。Ironwoodは前世代TPUから10倍以上の性能向上を達成、最初期のTPUとの比較では処理性能で3600倍、エネルギー効率で29倍という大幅な進化を果たしている。これらのハードウェアによって構築されるGoogle CloudのAIインフラは「AI導入を簡素化し、パフォーマンスを向上させ、コストを最適化するために設計された『AI時代のスーパーコンピューティングシステム』だ」と同氏は語った。

併せて、TPUに加えてGPUの需要に応えるため、NVIDIA製の最新GPUである「NVIDIA B200」と「GB200 NVL72」の両方を他のクラウドプロバイダに先駆けて提供開始する他、次世代の「NVIDIA Vera Rubin GPU」も先行投入予定であることが明かされた。

その他、「Cluster Director」(大規模なコンピューティングクラスタを簡単にデプロイ・管理、一般提供)や「Hyperdisk Exapools」(AIクラスタ当たり最高の性能と容量を誇るブロックストレージ、プレビュー)、「Cloud Storage Anywhere Cache」(一貫したゾーンキャッシュによりレイテンシを最大70%削減、一般提供)、「Rapid Storage」(AIワークロード向けゾーンバケット。スループット6TB/s、プレビュー)といった新機能が次々と紹介された。

ソフトウェアレイヤーにおいても、「Pathways」(Geminiを動かす分散ランタイム。動的スケーリングによるディスアグリゲート型推論を提供、プレビュー)や「vLLM on TPU(慣れ親しんだライブラリでTPU推論を簡単に、一般提供)、「GKE Inference Gateway」(インテリジェントなルーティングと負荷分散に最適化されたモデル対応ゲートウェイ、プレビュー)といった取り組みが紹介された。

渕野氏は「この1年でユーザーが利用するTPUとGPUの総稼働時間は3倍に達した」と述べ、その意義を「私たちが提供するAIインフラがいかに迅速に、そして大規模にお客さまのイノベーションを加速させているかの証」と位置づけた。グローバルで主要AIユニコーン企業がGoogle CloudのAIインフラを活用していることに加え、国内ユーザー企業による活用事例としてトヨタ自動車(製造現場の従業員向けにMLモデルを導入)、ソニーホンダモビリティ(「AFEELA 1」のAD/ADAS基盤モデルの研究・開発)、東京科学大学(「Gemma 2」をベースにした日本語LLM「Swallow LLM」を開発)などを挙げ「AIの活用促進をブレイクスルーできるAIインフラは整いつつあり、日本国内でもその有効活用事例が次々と生まれてきている」ことを明らかにした。

Google Cloudでのモダナイゼーション 大規模な導入事例も

Google Cloudのブラッド・カルダー氏(VP&GM、クラウド プラットフォーム&テクニカル インフラストラクチャ)はアプリケーションのモダナイズに関して講演した。同氏はGoogle発のイノベーションであり、現在のITインフラを支える基盤技術として広く活用されている「Kubernetes」と「Google Kubernetes Engine」(GKE)のこれまでの10年以上にわたる歩みを振り返り、今後の進化の方向性について解説した。

新機能として、「新しいコンテナ最適化コンピューティング」が「GKE Autopilot」で一般提供開始される。これは、最大7倍高速なPodスケジューリングや低レイテンシなオートスケーリングを実現するもので、既に利用可能となっている。「GKE Standardモード」に「Autopilotイノベーション」を導入し(Rapidチャネルで提供中)、ユーザーの選択肢が増えたことでクラスタを移行せずGoogleによるノード管理の恩恵を得られるようになった。

同氏は「AIワークロードにおけるGKEの強み」として「低コスト・低レイテンシ」や「メガスケールでの高速トレーニング」「GPUとTPUへの経済的なアクセス」「Cloud Run with GPU」といった特徴を挙げ、Google Cloudを基盤としたコンテナプラットフォームがAIアプリケーションの効率的な運用に役立つさまざまな機能を実装していることを強調した。

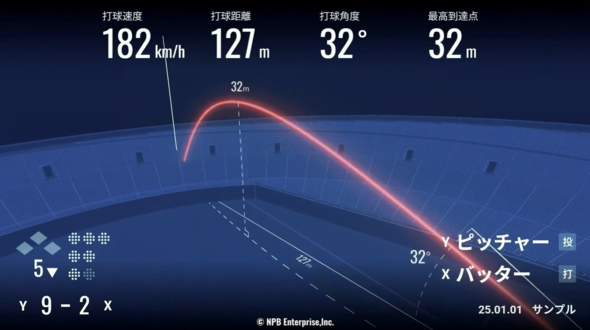

Google Cloudのユーザー企業であるNPBエンタープライズの丹羽大介氏(執行役員デジタル事業部長)は日本のプロ野球における試合データのデジタル化の取り組みについて紹介した。丹羽氏は「日本のプロ野球界は今まさにデータ活用の新しい時代を迎えようとしている」とし、「日本のプロ野球の全試合データを一元管理し、チーム強化への貢献はもとより、プロ野球ファンの皆さまにより深く新しい野球の楽しみ方を提供するシステムの構築を進めている」と語った。「打者の打つ打球の速度、投手の投げる投球の回転数や変化量、選手の成績やパフォーマンスなど、さまざまなデータがリアルタイムで見られるようになっていく」と言い、自動でCGコンテンツを生成するシステムを通じてデータの可視化も行い、「これまでにない新しい対戦環境を実現していきたい」とした。

このシステムは、Google Cloudのクラウド基盤と、ソニーの「Hawk-Eye」による高精度なトラッキング技術によって支えられる。ソニーの平位文淳氏(執行役員)は2024年シーズンにHawk-Eyeシステムの全12球団への導入が完了し、各球場に専用カメラやサーバなどのシステムが設置されたことを紹介。「Hawk-Eyeから得られる膨大なデータを活用するため、熟慮の末、豊富な実績と高い信頼性を持つ最先端のクラウド基盤であるGoogle Cloud上で今年から本格的にシステムを稼働させている」と明かした。同氏はGoogleクラウドを活用するメリットとして、「Cloud Run」やGKE、GKE Autopilot、「Cloud GPU」といったアプリケーション実行基盤の強みに加え、Googleのエンジニアと密接な協力関係を構築できる「TAPプログラム」によって「単なる技術提供に留まらず、より包括的な視点からビジネスの未来を共に創造する協力関係を築けた」ことを挙げている。

続いて登壇した三菱UFJファイナンシャル・グループの山本忠司氏(執行役 リテール/デジタル事業本部長 兼 グループCDTO)は、2025年6月2日から始動した新たな金融サービスブランド「エムット」の取り組みについて紹介した。エムットの開始を踏まえて「従来の銀行とは異なる全く新しいデジタルバンクの設立」も予定されているといい、そこでは銀行業務の中核を担う勘定系システムをフルクラウド開発するという目標が掲げられている。

Google Cloudはそのための基盤環境として選定されており、2025年4月から本格的な開発がスタートしているそうだ。同氏は選定理由として「金融機関に求められる高い信頼性と堅牢(けんろう)なセキュリティ、将来の成長に合わせてシームレスに拡張できる圧倒的なスケーラビリティと柔軟性」を挙げた上で、リージョンレベルの障害があってもサービスが止まらず、そのような状況でもデータの不整合が発生しないという、ミッションクリティカルなデータベースに不可欠な2つの要件を実現できる「Cloud Spanner」が選定の決め手となったことも明かしている。

AIによるアプリケーション開発支援の最新動向も紹介された。カルダー氏は「Google社内のコードの30%以上がAIによって生成されている」というデータを紹介し、AIによるソフトウェア開発支援が既に実用段階にあることを強調。「Gemini」を活用したさまざまなコーディング支援ツールが提供されていることも紹介した。ソフトウェア開発者向けのインタフェースとして用意された「Gemini CLI」と、「GitHub Actions」との連携によってAIエージェントとして動作させる「Gemini CLI GitHub Actions」(プレビュー)のデモも行われ、AIエージェントによってソフトウェア開発のプロセスが大幅に効率化される様子が示された。

データ基盤とセキュリティにも続々アップデート

データ基盤とセキュリティ分野の製品アップデートについては、Google Cloudのアンディ・ガットマンズ氏(GM&VP、データ クラウド)が解説した。同氏は「Google Cloudはビジネスプロセスを革新する次世代のインテリジェント・アプリケーションと自律型エージェントを構築する力を提供する。これを実現するためには、これまでとは異なる種類のデータプラットフォームが必要となる。孤立したツールの集合体ではなく、単一で統合されたAIネイティブのクラウドが必要であり、これがGoogle Data Cloudが目指すところだ」と語った。

同社はこの領域でもAIエージェントなどを活用したさまざまな機能拡張を行っている。講演では「BigQuery」でのデータエンジニアリングエージェント(プレビュー)、「BigQuery Notebooks」でのデータサイエンスエージェント」(プレビュー)、対話型分析エージェントとコードインタープリタ(プレビュー)といったユーザーのロールごとにそれぞれの作業支援を行うAIエージェントが紹介された。

エージェントと外部ツール間の連携を実現する「Model Context Protocol」(MCP)のサポートや、AIエージェントの動作を確実にするためのマルチモーダル検索、BigQueryでの自動エンベディング生成とインデックス作成(プレビュー)、BigQueryでの「AIクエリエンジン」(プレビュー)、Spannerの「カラム型エンジン」(プレビュー)といったさまざな取り組みが行われていることも紹介された。

業界内で急速に存在感を高めつつある「Apache Iceburg」のサポートとなる「Google BigLake Iceburg」の利用が拡大するなど、オープンなエコシステムへの積極的な取り組みの成果も明かされた。OracleとGoogle Cloudの戦略的パートナーシップに基づき、まずは東京リージョンで接続が完了し、2026年初頭には大阪リージョンでも展開予定となっていることも発表された。

Google Cloudを活用したデータ基盤整備に関して、セブン&アイ・ホールディングスの西村 出氏(常務執行役員 グループDX本部長)から紹介が行われた。同社は2020年に「セブンCENTRAL」というリアルタイムのデータ基盤を構築した。その規模感は「1日のレコード数にして52億件」「おにぎりの販売数は年間で20〜22億個で、これは毎秒63個というトランザクションに相当」「1日のPOSレジ通過顧客数は2000万人」だという。

この大規模なトランザクションを支えるデータ基盤として同社が選定したのがBigQueryだ。同氏は選定理由として「安心安全」「柔軟性」「サービスの網羅性」などを挙げた。次世代型店舗システムの開発、展開に取り組んでいることも紹介され、2万1000店にも達する同社の各店舗に置かれたストアコンピュータのデータやそこで実行されるロジック全てをクラウド移行するという。クラウドに蓄積されたデータをリアルタイムで活用していくための仕組み作りとして同氏は「セブンイレブン AIライブラリー」を構築して真のデータの民主化を目指すことも明らかにするなど、AI時代の新たなデータ活用の取り組みが既に現実化しつつある現状が語られた。

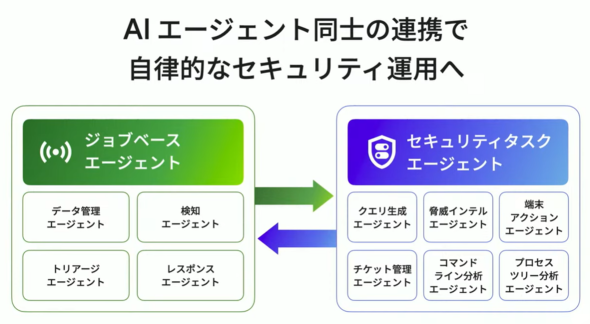

Google Cloudの北迫清訓氏(プリシパル アーキテクト)からはセキュリティに関する取り組みが紹介された。同氏は、サイバー攻撃者がAIを悪用してこれまで以上に巧妙な攻撃を仕掛けてきている現状を指摘し、防御側でもAIを活用する「AIで守る」というコンセプトを打ち出した。AI機能に特化したセキュリティエージェントとして「アラートトリアージ エージェント」(2025年第4四半期に一部顧客向けにプレビュー提供予定)が紹介された他、さまざまなセキュリティタスクを実行するエージェント同士の連携で自律的なセキュリティ運用を実現していくという方向性が打ち出された。企業内のAIアセットを攻撃や悪用から保護する「AIを守る」取り組みについても紹介された。

生成AIの登場によって急速に進化したAI活用は、現在業務にAIエージェントを活用していく段階に入り、ハイパースケーラー各社は必要なテクノロジーやサービスを整えつつある。本講演は、こうした現状を改めて再確認し、さらにこの先のAIエージェントによる自律的なシステム運用へと続いていく未来像を実感できる内容となっていたのではないだろうか。

関連記事

“AIエージェント一色”のGoogle Cloud年次イベントで語られた最新動向と導入事例

“AIエージェント一色”のGoogle Cloud年次イベントで語られた最新動向と導入事例

グーグル・クラウド・ジャパンは年次イベントで、生成AIとAIエージェントがビジネス価値を高める未来像を示した。本稿では「Gemini」の進化や企業の導入事例が紹介された初日の基調講演の内容を伝える(編集:村田知己)。

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- Claude拡張機能にCVSS10.0の脆弱性 現在も未修正のため注意

- ホワイトハッカーが明かす「ランサムウェア対策が破られる理由」と本当に効く防御

- 7-Zipの偽Webサイトに注意 PCをプロキシノード化するマルウェア拡散

- 2026年はAGIが“一部実現” AIの革新を乗りこなすための6つの予測

- 一気読み推奨 セキュリティの専門家が推す信頼の公開資料2選

- 「SaaSの死」騒動の裏側 早めに知るべき“AIに淘汰されないSaaS”の見極め方

- 米2強が狙う“AI社員”の普及 Anthropicは「業務代行」、OpenAIは「運用プラットフォーム」

- Fortinet、管理サーバ製品の重大欠陥を公表 直ちにアップデートを

- NTTグループは「AIがSI事業にもたらす影響」をどう見ている? 決算会見から探る

- LINE誘導型「CEO詐欺」が国内で急増中 6000組織以上に攻撃

Google Cloud 渕野大輔氏(出典:編集部撮影)

Google Cloud 渕野大輔氏(出典:編集部撮影) Google Cloud ブラッド・カルダー氏(出典:編集部撮影)

Google Cloud ブラッド・カルダー氏(出典:編集部撮影)

Google Cloud アンディ・ガットマンズ氏(出典:編集部撮影)

Google Cloud アンディ・ガットマンズ氏(出典:編集部撮影)