「Google Lens」は画像内情報検索AI技術 Assistantやフォトと連係:Google I/O 2017

米Googleは5月17日(現地時間)、年次開発者会議「Google I/O 2017」の基調講演で、新たな検索技術「Google Lens」を発表した。まずは「Google Assistant」と「Googleフォト」で採用する。

Google Lensは名前から分かるように、レンズを通してGoogleのAIが“見た”画像内の情報を検索するAI技術。かつての「Google Goggles」や「Word Lens」の発展型とみることもできる。

基調講演では、Google Assistant(以下、アシスタント)との対話中に端末のカメラで花を撮影すると、アシスタントがそれが何という花かを答えたり、外出先で見かけたレストランの看板をカメラに映すとその店の名前や電話番号、レビューが表示されるなどのデモが行われた。

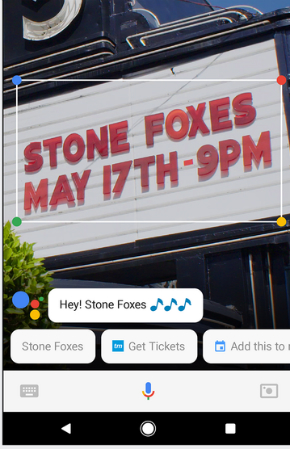

アシスタントは、店の情報を提示するだけでなく、予約するかどうかなども聞いてくる。右の画像は、コンサートの看板を映すとAssistantが「予約する」「スケジュールに入れる」というアクションの候補を提示しているところだ。

Google LensにはWord Lensと同様に、テキストを自動翻訳する機能もある。基調講演では、日本語の「たこ焼き 6個入り 130円」という看板をカメラで映すと英語に翻訳され、さらにたこ焼きについての情報が表示されるデモも行われた。

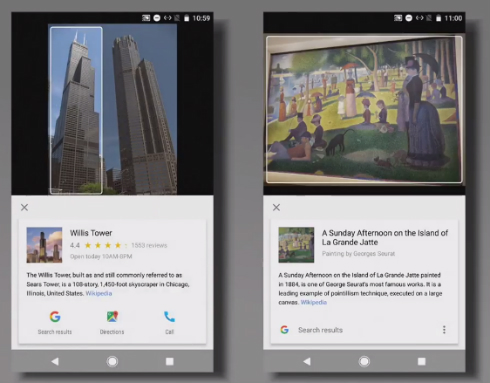

Googleフォトでは、ライブラリにある画像の検索に使われる他、撮影はしたもののそれが何か分からない建造物や美術作品の名称や情報を表示する。Googleフォトの1枚ずつの画像を表示する画面にLensアイコンが追加され、これをタップするとその画像についての情報が表示される。

Googleは今後、他のサービスにもGoogle Lensを応用していくとしている。Googleマップでの採用が楽しみだ。

関連記事

「Google Assistant」のiPhoneアプリ登場

「Google Assistant」のiPhoneアプリ登場

Googleが、Appleの「Siri」と競合するパーソナルアシスタント「Google Assistant」のiPhoneアプリを米国のApp Storeで公開した。「Google Assistant」搭載のソニーやオンキヨーの製品も開発されている。 「Google Home」、日本で年内発売へ

「Google Home」、日本で年内発売へ

GoogleのAmazon Echo対抗スマートスピーカー「Google Home」が今夏以降にようやく日本で発売される。米国ではGoogle Homeから電話を掛ける機能も使えるようになる。 Google、動画内検索を可能にするディープラーニング採用APIのβ提供開始

Google、動画内検索を可能にするディープラーニング採用APIのβ提供開始

Googleが、例えば「犬」「野球」などのキーワードで関連する動画を検索し、動画のどの部分に関連シーンがあるかを特定するためのディープラーニング採用API「Cloud Video Intelligence API」のプライベートβ版を公開した。 Google、アプリに画像認識機能を追加できる「Cloud Vision API」を公開

Google、アプリに画像認識機能を追加できる「Cloud Vision API」を公開

Googleが、GoogleフォトやSafeSearchで採用している機械学習画像認識機能をアプリに追加できる「Cloud Vision API」をGoogle Cloud Platformユーザー向け限定プレビューとしてリリースした。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR