AIで自殺ほのめかしを早期発見──Facebookが世界で開始

米Facebookは11月27日(現地時間)、自殺をほのめかす投稿や「ライブ動画」(以下、まとめて「投稿」)をAI(人工知能)を使って検出して専門対策チームに報告する機能を欧州連合(EU)を除く世界で提供開始したと発表した。

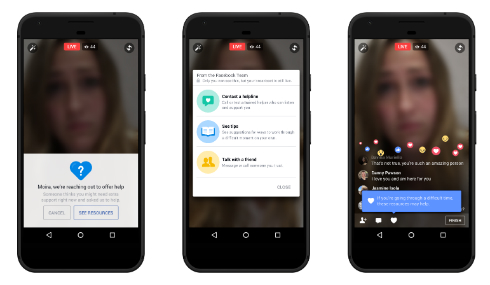

同社は2011年から自殺防止対策に取り組んでおり、問題のある投稿についての報告をFacebookの専門対策チーム(Community Operationsチーム)がレビューし、必要に応じて報告されたユーザーにアドバイスのメッセージを表示している。

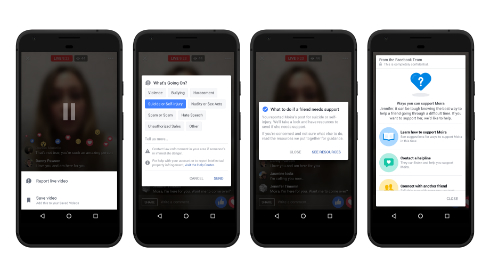

従来は、友達などの第三者からの報告に基づいていた。今後は、AIもパターン認識技術で自殺をほのめかす投稿を検出し、専門チームに報告する。これにより、従来より迅速に自殺の危険のあるユーザーに接触できるようになるとしている。米国では過去1カ月このAIをテストし、その間に100件以上の投稿がチームに報告されたという。

AIがチェックするのは投稿自体だけでなく、コメントも対象だ。例えばライブ動画のコメントに「大丈夫?」「助けが必要?」などのコメントが付くとAIがそれを検出し、報告する。

FacebookはAIを支援対象の優先度判断にも使う。問題を報告された投稿をパターン認識でさらに解析し、緊急性の高い投稿のレビューを優先するようCommunity Operationsチームに通知する。

また、チームメンバーが個々の投稿のどの部分が問題かを迅速に判断できるよう、例えば動画の場合はコメントが集中している部分を提示する。

Community Operationsチームは年内に7500人以上になる見込みではあるが、この人数で世界中から寄せられた報告に対処している。

FacebookはAI技術の正確性向上と偽陽性回避に努めていくとしている。

関連記事

菅官房長官「Twitter規制は検討対象になる」 座間9人遺体事件で

菅官房長官「Twitter規制は検討対象になる」 座間9人遺体事件で

座間市の事件を受け、政府が関係閣僚会議を実施。記者会見で、菅官房長官は「Twitter規制など検討の対象になるとは思う」と述べた。 「首吊り士」名乗り、自殺志願者と接触か 座間9人遺体事件

「首吊り士」名乗り、自殺志願者と接触か 座間9人遺体事件

死体遺棄容疑で逮捕された白石隆浩容疑者は、「首吊り士」などのTwitterアカウントを使い、自殺志願者を手助けする内容を投稿していた。 Facebookの問題コンテンツ対策マニュアルをGuardianがリーク

Facebookの問題コンテンツ対策マニュアルをGuardianがリーク

殺人動画やリベンジポルノの表示が問題になっているFacebookで、そうしたコンテンツの対策担当者向けの膨大なマニュアルを入手したとしてGuardianが一部を公開した。 Facebook、自殺防止対策を強化 メッセージでのアドバイスも

Facebook、自殺防止対策を強化 メッセージでのアドバイスも

Facebookはユーザーの自殺防止対策として、自殺の疑いがあるとの報告のあったユーザーに、プロのカウンセラーや友達に相談するよう勧めるメッセージを表示するようになる。 Facebook、ユーザーの自殺防止に関する取り組みを発表

Facebook、ユーザーの自殺防止に関する取り組みを発表

自殺をほのめかす投稿をFacebookに報告すると、Facebookが投稿者に自殺防止団体への無料電話番号とチャットのリンク(米国の場合)を送信する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR