ITmedia NEWS >

STUDIO >

Google、REP(ロボット排除プロトコル)のWeb標準化に乗り出す

» 2019年07月02日 12時02分 公開

[佐藤由紀子,ITmedia]

米Googleは7月1日(現地時間)、検索エンジンのクローラを制御する「robots.txt」の仕様である「REP(Robots Exclsion Protocol、ロボット排除プロトコル)」のWeb標準化を目指すと発表した。IETF(インターネット技術特別調査委員会)にドラフトを提出した。REPを1994年に考案したマーティン・コスター氏やWebマスター、他の検索エンジンとも協力していくとしている。

自身もWebマスターであるコスター氏はREPを、クローラによってWebサイトを運営しているサーバに負荷が掛かりすぎないようにする目的で開発した。REPは20年以上、Googleの「Googlebot」をはじめとする主要なクローラが事実上の標準として採用し、約5000万のWebサイトがこのプロトコルに頼っている。

だが、標準化されていないため、Webマスターは微妙なケースで判断が難しく、クローラやツールの開発者にとっても迷う原因になっているとGoogleは説明する。

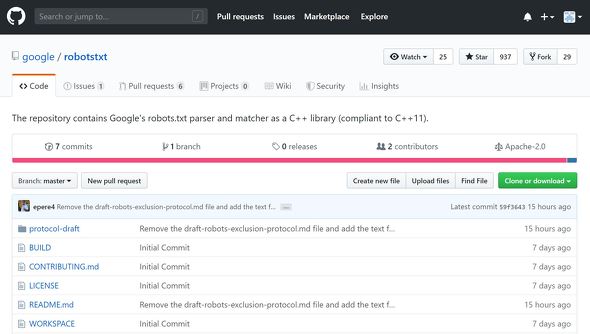

同社はまた、自社の「tobots.txt」のルール解析とマッチングに使っているC++ライブラリをGitHubでオープンソースで公開した。Webマスターがrobots.txtファイルを作成する方法や対処すべき問題についての説明も読むことができる。

関連記事

Apple、「Safari」にプライバシー重視の広告トラッキングツール搭載へ

Apple、「Safari」にプライバシー重視の広告トラッキングツール搭載へ

個人のプライバシーを重視するAppleが、個人データを集めずに広告トラッキングを解析できる新ツール「Privacy Preserving Ad Click Attribution」をプレビュー版の「Safari」(バージョン82以降)で提供を開始した。Web標準化を目指している。 Google、AMPの高速化技術のWeb標準化を目指す

Google、AMPの高速化技術のWeb標準化を目指す

Googleが推進するモバイルWeb高速化プロジェクトAMPで得た成果をWeb標準化する取り組みを発表した。この標準に準拠すれば、非AMPコンテンツでもGoogle検索結果でAMP同等に扱われるようになる。 Google検索およびGoogleニュースでの有料コンテンツの扱い変更

Google検索およびGoogleニュースでの有料コンテンツの扱い変更

Googleが有料コンテンツパブリッシャー向けに提供してきた「First Click Free(検索結果の最初の1本は有料でも無料で読めるようにするサービス)」を終了し、パブリッシャーが無料化するコンテンツを柔軟に決められる「Flexible Sampling」に移行した。 Apple独自のWebクローラー「Applebot」、公式に認める

Apple独自のWebクローラー「Applebot」、公式に認める

Appleが独自のWebクローラー「Applebot」の存在を公式に認めた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR