ITmedia NEWS >

STUDIO >

YouTube、年齢制限動画検出をAIで自動化

» 2020年09月23日 14時39分 公開

[ITmedia]

米Google傘下のYouTubeは9月22日(現地時間)、プラットフォーム上で未成年者を保護するための複数の取り組みを発表した。

まず、これまで機械学習で検出し、人間のTrust & Safetyチームが判定してきた年齢制限が必要な動画の判定を、AIで自動化する。

年齢制限の対象は、YouTubeのポリシーには違反していなくても、18歳未満の視聴者にふさわしくないと判断されたコンテンツ(動画だけでなく、その説明やサムネイルを含む)。18歳未満またはログインしていない視聴者は、制限を設定された動画を視聴できない。また、広告による収益が制限されるか、まったくなくなる可能性がある。制限されたクリエーターは、不服であれば申し立てが可能だ。

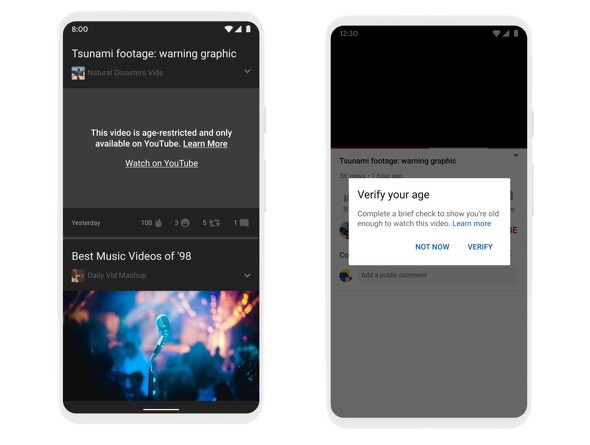

次に、YouTubeの外(サードパーティのWebサイトなど)で年齢制限が設定された動画を再生しようとすると、YouTubeにリダイレクトされるようになる。こうすることで、年齢制限のある動画がどこにあっても、適切な視聴者だけが視聴できることになる。

3つ目として、自動化すると対象動画が増えると想定し、年齢制限に関するポリシーを改めて調整した。新しいポリシーはこちらで確認できる。

最後に、欧州連合の視聴覚メディアサービス指令(AVMSD)などに準拠するため、欧州の一部のユーザーは、成人向けコンテンツの視聴の際に年齢証明を求められるようになる。視聴者が18歳以上であることをYouTubeが確認できない場合は、IDあるいはクレジットカード番号を入力することで年齢を証明するよう求めるという。

関連記事

YouTube、システムで自動削除した動画が倍増 ポリシー違反を判断する正確性より確実な削除を優先

YouTube、システムで自動削除した動画が倍増 ポリシー違反を判断する正確性より確実な削除を優先

YouTubeは、機械学習を活用してポリシー違反のアップロード動画を発見するシステムにより削除した動画の件数が、1〜3月が571万件だったのに対し、4〜6月は1084万件で倍増したと発表した。 子供向け動画アプリ「YouTube Kids」が、tvOSに対応

子供向け動画アプリ「YouTube Kids」が、tvOSに対応

Apple TVでYouTube Kidsが視聴できるように。 新型コロナウイルスで削除される動画が増える? パンデミックが促すYouTubeの変化

新型コロナウイルスで削除される動画が増える? パンデミックが促すYouTubeの変化

COVID-19の影響は動画サイトにも出ている。 YouTube、ゲームの暴力シーンの扱いを映画やテレビと同等に

YouTube、ゲームの暴力シーンの扱いを映画やテレビと同等に

YouTubeが、ゲームの暴力シーンの規制を緩和し、映画やテレビ番組と同等に扱うようガイドラインを変更した。 Google、YouTubeの児童保護法違反でFTCに1億7000万ドル(約180億円)の和解金

Google、YouTubeの児童保護法違反でFTCに1億7000万ドル(約180億円)の和解金

Googleとその傘下のYouTubeが、米児童オンラインプライバシー保護法(COPPA)違反で1億7000万ドル(約180億円)の和解金を支払う。YouTubeの子ども向けチャンネルの視聴者の個人情報を、保護者の同意を求めずに収集したため。 YouTube、不適切なコンテンツ対策を強化 「YouTube Kids」ガイドライン公開も

YouTube、不適切なコンテンツ対策を強化 「YouTube Kids」ガイドライン公開も

YouTubeが、一見家族向けで実は子どもに見せられないような動画や、未成年が危険にさらされるような動画の増加を受け、対策強化を発表した。ガイドラインの適用範囲を広げ、既に50以上のチャンネルを停止した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR