NVIDIA、データセンター向け“Ampere”GPUを強化 メモリ容量倍増し高帯域に

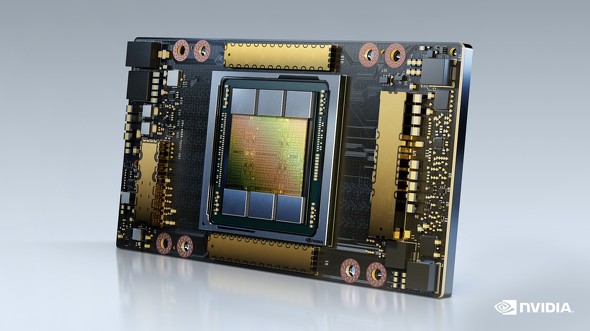

米NVIDIAは2020年11月16日、データセンター向けGPUの「NVIDIA A100 80GB GPU」を発表した。同社としては最新の「Ampere」アーキテクチャのGPUチップを使用している。フォームファクター(基板の形状)はNVIDIA独自の「SXM」を採用。OEMベンダーが製造するSXM対応マザーボードとのセット販売あるいはサーバに組み込んだ完成品の形での販売となる。

NVIDIAは5月にAmpereアーキテクチャのチップを発表した際、そのチップをSXMフォームファクターに搭載したGPU「NVIDIA A100 40GB GPU」を発表していた。今回の新製品は同じGPUを採用しながら、帯域幅が2.039Tバイト/秒の広帯域メモリ「HBM2e」を80GB搭載して性能を引き上げた。5月にNVIDIAが発表したNVIDIA A100 40GB GPUは帯域幅が1.555TB/秒の「HBM2」メモリを40GB搭載していた。新製品はメモリ帯域幅をおよそ1.35倍に拡張し、搭載メモリ容量は2倍となった。

複数GPUを搭載したサーバで、GPU同士を接続する高速インターコネクト「NVLink」を搭載している点や、GPUを最大7つに分割してそれぞれ別々に使用できる機能「Multi-Instance GPU」(MIG)を備えている点は5月発表の製品と変わらない。

NVIDIAは、メモリを特に強化した新製品について、大量のデータを使用するアルゴリズムでは特に性能が向上するとしている。例えばユーザーの好みを予測するレコメンデーションシステムに、深層学習を応用した「DLRM」(Deep Learning Recommendation Model)では、5月発表のGPUに比べて処理速度が3倍まで高速化が可能。気象予測や量子化学といった大量のデータを扱う科学技術計算では2倍近い性能を発揮するという。

NVIDIA A100 80GB GPUを搭載したサーバは、米Dell Technologies、米Hewlett Packard Enterprise、中国Lenovo、富士通といったサーバベンダーや、台湾QuantaなどのOEMベンダーから2021年前半に登場する予定。

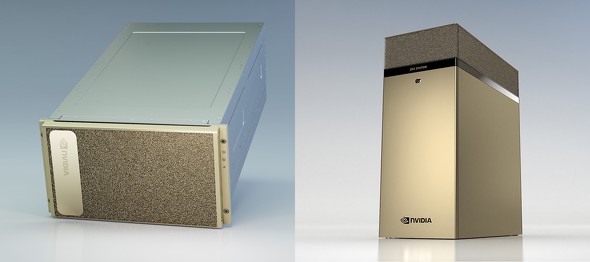

さらに、NVIDIAは今回発表した新製品を搭載したワークステーション「NVIDIA DGX Station A100」 と、6Uラックマウントサーバ「NVIDIA DGX A100」も発売する。両製品とも2020年中に出荷開始予定。

関連記事

最終回:RISC-Vエコシステムの発展 Arm、NVIDIAとの関係はどうなるのか?

最終回:RISC-Vエコシステムの発展 Arm、NVIDIAとの関係はどうなるのか?

RISCの生い立ちから現在までを振り返るこの連載もいよいよ最終回。 NVIDIA、RTXをArmに移植へ スマートフォンでリアルタイムレイトレーシングが可能に?

NVIDIA、RTXをArmに移植へ スマートフォンでリアルタイムレイトレーシングが可能に?

本格的なGPUがスマートフォンに搭載される未来が見えてきた。 NVIDIA、AIで新型コロナ患者を“トリアージ” 初診データから酸素供給の必要性を推定

NVIDIA、AIで新型コロナ患者を“トリアージ” 初診データから酸素供給の必要性を推定

米NVIDIAと米国の病院の研究チームは、新型コロナウイルス感染症患者が数時間後から数日後に酸素の供給を必要とするか判断するAIを開発したと発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR