ITmedia NEWS >

AI+ >

音声に合わせ顔の動きを深層学習で作成 Adobeなど「MakeItTalk」開発:Innovative Tech

» 2021年07月19日 10時14分 公開

[山下裕毅,ITmedia]

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

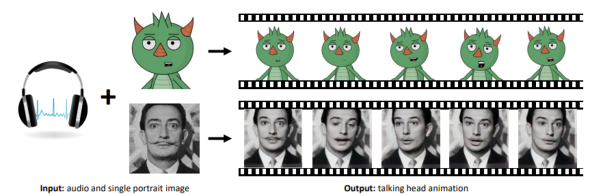

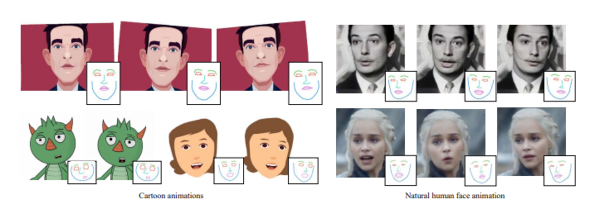

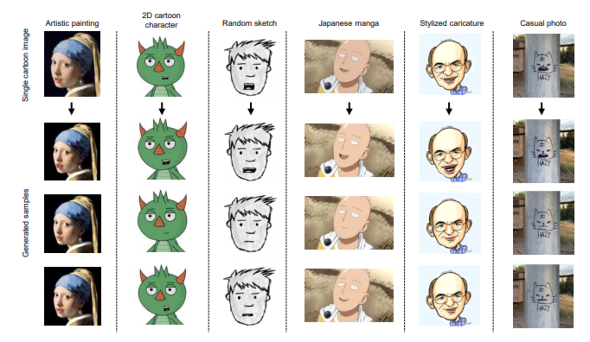

米マサチューセッツ大学アマースト校、米Adobe Research、中国Huya Incによる研究チームが開発した「MakeItTalk」は、音声に合った顔と頭の動きを生成する深層学習フレームワークだ。音声信号と顔の静止画像から、音声と同期した表情と頭部のアニメーションを生成する。実際の顔写真やアニメキャラクター、手描きスケッチまで、さまざまな顔に対応可能だ。

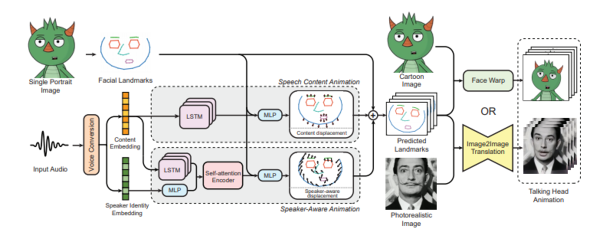

今回の手法は、音声とアニメーションの中間表現として、入力した顔画像から唇、顎、眉毛、鼻、頭のポーズなどの顔のランドマークを予測し、抽出したランドマークと音声信号で学習する。顔の表情と頭部の動きは別々に学習し、後で統合する仕組みだ。

アニメーション合成に用いる手法としては、写実的な顔に対しては画像から画像へ変換する学習ネットワーク、非写実的な顔に対しては画像を歪ませる手法の2つのアルゴリズムを採用している。

出力するアニメーションは、静止画像の顔を自然に動かし、あたかも話しているかのように錯覚させる。最先端の手法と比較しても、より表現力豊かで品質の高いアニメーションを実現したとしている。

関連記事

電気刺激によって勝手に動く指の動きで生体認証 シカゴ大学が技術開発

電気刺激によって勝手に動く指の動きで生体認証 シカゴ大学が技術開発

生体認証にチャレンジ&レスポンスを持ち込める。 リモコン付きラケットで自在に魔球 東大と東工大が超音波卓球「Hopping-Pong」開発

リモコン付きラケットで自在に魔球 東大と東工大が超音波卓球「Hopping-Pong」開発

オーグメンテッドスポーツの一つの形だという。 AirTag付けてなくても“あれどこに置いたっけ”を探す「GO-Finder」 東大が全映像記録による検索技術開発

AirTag付けてなくても“あれどこに置いたっけ”を探す「GO-Finder」 東大が全映像記録による検索技術開発

AirTagなどの忘れ物防止タグで探せるのは、あらかじめ装着したものだけ。想定していなかった探し物対策が考案された。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR