“iPhoneを手持ちで自撮りするだけ”の全身モーションキャプチャー センサーをフルに使い全身姿勢をリアルタイム推定:Innovative Tech(1/2 ページ)

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

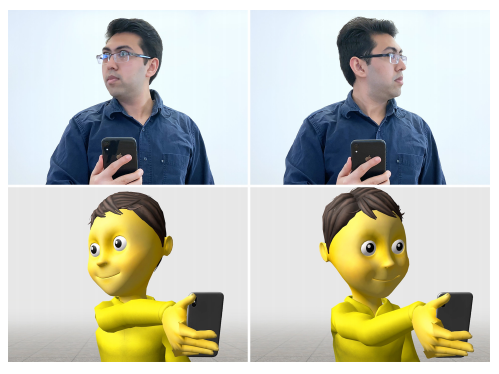

米カーネギーメロン大学の研究チームが開発した「Pose-on-the-Go」は、スマートフォンで自撮りするだけで全身の姿勢を推定し、リアルタイムで全身モーションキャプチャーができるシステムだ。スマートフォンの内蔵カメラ・センサーのみを用い、頭や体、腕、視線の動きから、歩行や回転、しゃがむなどの全身運動まで検出する。

全身モーションキャプチャーの手法は、マルチカメラリグとマーカー付きの特殊スーツを使うもの、ヘッドセットやハンドヘルドコントローラー、体に装着する小型センサーによるもの、カメラや深度センサーなどを駆使して全身画像を処理するコンピュータビジョンなどがある。しかしこれらは特殊なハードウェアを必要とし、計算処理が多大でコストもかかる。

今回の全身モーションキャプチャーシステムに必要なのは、スマートフォンだけ。カスタマイズも不要だ。スマートフォンを手に持って自分に向ける“自撮り”スタイルで全身の動きを捉えるため、コストが低く、周辺に機器を設置する必要もないので場所に依存しないのが特徴だ。

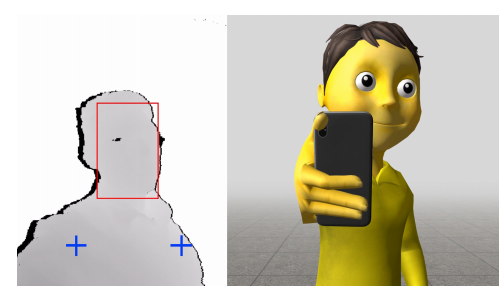

フロントカメラ、リアカメラ、ユーザー側の深度カメラ、静電容量式タッチスクリーン、IMU(慣性計測装置)など、スマートフォンに搭載されているセンサーを活用する。今回はこれら全てのセンサーを搭載するAppleの「iPhone XR」を採用し、開発した。

全てのセンサーと連動するスマートフォンアプリを作成し、データをWi-Fi経由でMacBook Proに送信。Root-MotionのVRIKライブラリをUnityエンジン上で実行した。

頭部の位置と向きは、カメラとARKitのARFaceAnchor APIを使って決定。視線も同じ方法で追跡し、アニメーションに反映する。

胴体の動きは、深度カメラを使って胴体の左右対称部分を正確に捉え、胸部のヨーベクトルを計算。

IMUと背面カメラを使用して3自由度の向きを追跡し、重力ベクトルを計算。このデータを使用して、スマートフォンを持っている方の手をアニメーション化する。この3自由度データと、頭の6自由度トラッキングを組み合わせることで、アバターの頭を正しい場所に配置し、その下に胴体の残りをぶら下げる。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR