ITmedia NEWS >

AI+ >

合成背景に人が溶け込むよう照明を調節する技術 Googleが開発:Innovative Tech(2/2 ページ)

» 2021年10月18日 08時00分 公開

[山下裕毅,ITmedia]

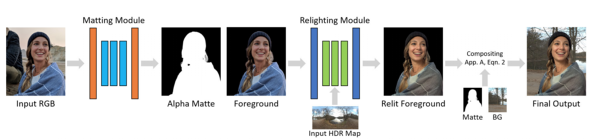

1つ目のモジュールで、入力したRGB画像からアルファマットと前景を推定する。これらを2つ目のモジュールに提供し、表面形状とアルベド推定を行い、ピクセルごとの照明表現やライトマップを使用してレンダリングした外観の拡散反射と鏡面反射の成分をモデル化する。最後のモジュールでは、再照明の結果とアルファマット、新しい背景を合成し、新しい背景で再照明された人物画像を生成する。

データセットには、異なる視点を持つ64台のカメラと331個のLED光源を含むLight Stageでキャプチャーした70人のOLATデータ(同じ被写体において、異なる角度からの照明を1つずつ照らして撮影した画像群)を用いた。

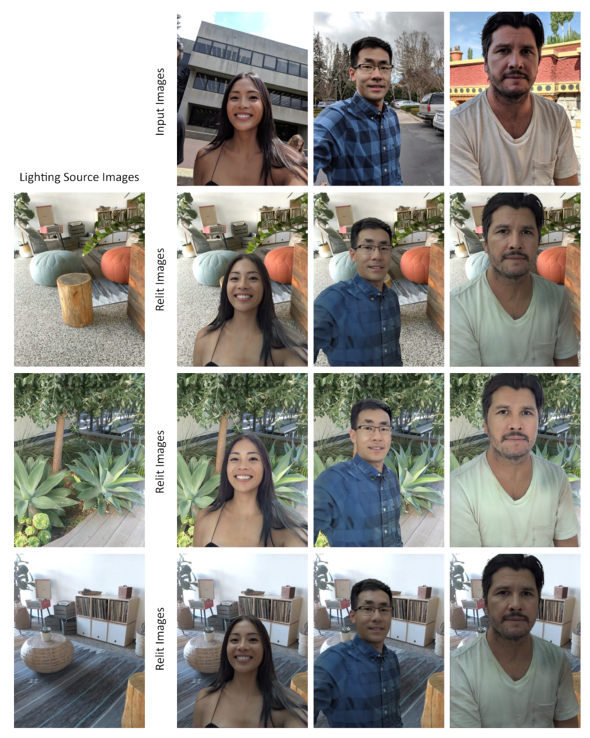

実写画像を用いた実験では、この再照明モデルが、表面下の散乱や鏡面反射などを説得力を持って表現できることを実証し、人物画像の再照明に関する最先端の類似技術を上回ったという。

このシステムはフレーム単位で動作するため、動く被写体に対しても時間的に一貫した効果を発揮するが、リアルタイムに処理するにはまだ最適化の必要があるという。

関連記事

リードで巧みに人間を誘導する盲導ロボット犬 米カリフォルニア大が開発

リードで巧みに人間を誘導する盲導ロボット犬 米カリフォルニア大が開発

盲導犬の代替を目指す4足歩行ロボット。 飛行中にプロペラを変形できるドローン 狭い場所の通過や運搬作業など自由自在

飛行中にプロペラを変形できるドローン 狭い場所の通過や運搬作業など自由自在

狭い空間を通過する時などは機体を小さくできる、ホバーパイルダーがマジンガーZにドッキングする時を思わせるシーンも。 ビデオ会議中のよそ見が可能に? 顔が常に前を向いているように見せる技術、NVIDIAが開発

ビデオ会議中のよそ見が可能に? 顔が常に前を向いているように見せる技術、NVIDIAが開発

相手と常にアイコンタクトを取っているように見せかける技術。 外部プロジェクターの映像をAR表示する眼鏡型デバイス 東工大などが開発

外部プロジェクターの映像をAR表示する眼鏡型デバイス 東工大などが開発

ARグラスは重くなりがち。その問題を解決する方法の1つが、外部から投影すること。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR