今日から君もラッパーに! カメラで写した猫も楽器もAIでラップ化 「Giorgio Cam」でテンションUPだ:遊んで学べる「Experiments with Google」(第2回)

「Experiments with Google」は、Googleが人工知能(AI)や拡張現実(AR)といった最新技術の可能性を示すために、実験的な応用例を紹介しているショーケースだ。膨大なコンテンツを公開しており、その多くはスマートフォンやPCで試せる。

この連載では、多種多様な応用例の中から興味深いものをピックアップして紹介。実際に遊んだ体験レポートを通して、裏側にある技術の解説を行っていく。

読者の皆さんも、ぜひ自分の手で試しながらその仕組みを学んでもらえたらうれしい。きっと、最新技術の魅力に気付くはずだ。

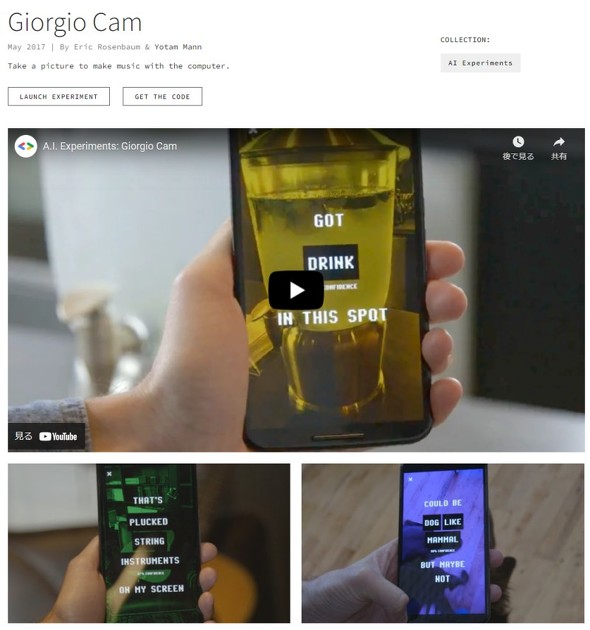

カメラを使って即興ラップを味わえる「Giorgio Cam」

連載2回目の今回は、スマホさえあれば誰でもラッパーになれる「Giorgio Cam」を取り上げる。

Giorgio Camは、スマホやノートPCのカメラを使うWebアプリケーション。カメラで写した物体をAIで認識し、認識したものを題材にラップ風の歌詞を自動生成して、ビートに乗せて歌う。ラップなので「歌詞」でなく「リリック」と呼ぶべきだろうか。

使い方は至って簡単。Webブラウザ上で動くので、Giorgio Camのサイトにアクセスして「LAUNCH EXPERIMENT」をタップするだけ。読み込み完了したら「LET'S GO」ボタンを押せばすぐにプレイできる。

ノリノリの音楽が流れ出してカメラが起動したら、近くにある物を画面に捉えてみよう。写ったものが何かAIで判断して、それをテーマにしたラップを即興演奏する。画面のエフェクトも、DJフロアの照明みたいで気分が上がる。

写真を撮るだけで、その場に合わせた即興のラッププレイを誰でもできてしまう。純粋に楽しいし、AIの物体識別や音声合成などの技術を気軽に体験できる良さもある。まさにExperiments with Googleらしさいっぱいのコンテンツだ。

たとえ誤認識されても、テンションはラップで上がる!

早速遊んでみよう。ノートPCとAndroidスマホで動くそうだが、さすがにPCを振り回すのは大変なのでスマホにした。

ところが、今回使った「Pixel 3」だと内側カメラでしか撮影できず、被写体を捉えにくかった。しかも画面に表示される映像が左右反転しないので、画角内にうまく収めることがなかなか難しい。サンプルビデオでは、外側カメラを使えていて便利そう。機種依存なのか、Android OSバージョン依存なのか分からないが、慣れるまで苦労した。

小さな物は認識されにくい

内側カメラだと持ち歩いて撮影しにくいので、スマホをスタンドに置いてやってみた。まずは手近にあった物から。一度起動すると、連続して5回プレイ可能。1回で2つの答えを歌ってくれる。

最初に写した腕時計は「sleeve」(袖)と「gesture」(ジェスチャー)に、2番目に写した万年筆は「hand」(手)と「finger」(指)になってしまった。

3番目に写した眼鏡は、素直に「glasses」(眼鏡)でなく「vision care」(視力補助具)という少しずれた解釈になり、続いて迷ったのか「thumb」(親指)と答えてきた。さすがに自信がないようで、表示された信頼度は80%と高くない。

4番目にハサミを見せたら「tableware」(食器類)と「nail」(爪)になった。トングを持つ手と間違えたのだろうか。

最後に「太陽の塔」のミニチュアを写したところ、「toy」(おもちゃ)と「creative arts」(アート作品)と歌ってくれた。やっと正解になって一安心だ。

どうも小さい物は苦手で、画面内にある別の目立つ物に影響されてしまう。もっとも、誤認識は誤認識で面白いし、拍手喝采で終わるのはフロアを盛り上げられたようで気分がいい。

大きい物だとほぼ全問正解

次にもう少し大きな物で試してみた。すると、5回のうち4番目に写したヘッドフォン以外は見事正解した。カメラで写したものとGiorgio Camが返した答えは次の通りだ。

- コップ:drinkware(飲み物用の食器)、tableware(食器)

- ワインのボトル:bottle(瓶)、wine(ワイン)

- カメラ:photographer(写真家)、digital camera(デジカメ)

- ヘッドフォン:arm(腕)、gesture(ジェスチャー)

- ノートPC:computer(コンピュータ)、laptop(ノートPC)

楽器の細かな違いは区別できない

毛色を変えて手元にあった楽器を試したところ、十分に大きいためか正解率が高かった。間違えたのは1番目のタンバリンだけで、画面に入った「arm」と「sleeve」に引きずられてしまった。

2番目に見せたシンセサイザーは「musical instrument」(楽器)、「keyboard」(キーボード)と正解。ちなみに、別のタイミングでピアノを見せたら「piano」と答えており、両者をきちんと区別できていると分かった。

ところが、3番目からのアコースティックギター、エレキギター、エレキベースは、以下の通り見分けられなかった。

- タンバリン:arm、sleeve

- シンセサイザー:musical instrument、keyboard

- アコースティックギター:guitar(ギター)、string instrument(弦楽器)

- エレキギター:musician(ミュージシャン)、plucked string instrument(撥弦楽器)

- エレキベース:hand、string instrument accessory(弦楽器の部品)

猫とぬいぐるみの区別は?

生き物とぬいぐるみは区別できるのだろうか。試してみた。

猫を写してみると、「cat」(猫)と正解しつつも「carnivore」(肉食動物)や「vertebrate」(脊椎動物)とひねった回答を出した。「leg」(脚)のように一部分だけ判定することもあり、案外難しいようだ。「comfort」(快適)と答えたこともあり、猫らしいと言えば猫らしいが、AIにどんな学習をさせたのだろうか。

ダンボは世界的に有名だからか、「toy」「stuffed toy」(ぬいぐるみ)と正解しつつも、「hand」「watch」(腕時計)を誤認識した。

チェコの国民的キャラクター「クルテク」と、日本で人気の「11ぴきのねこ」に登場する「のらねこ」は、結果が微妙だった。クルテクは「hand」「arm」の他、「joint」(関節)や「shoulder」(肩)と表示され、どうやら形に大きく影響されてしまった。のらねこは「head」(頭)、「product」(商品)、「eye」(目)というように、目立つ部分につられたようだ。

画像認識だけじゃ物足りない……それならラップにしよう

Giorgio Camは、機械学習をベースにしている。カメラで撮影した画像を認識して分類し、分類結果のテキストを合成音声で読み上げる仕組みだ。ただ、それだけだと遊び心に欠ける。そこで合成音声がラッパーに似ていることを利用して、音楽に合わせて発声させることで機械学習を楽しんで体験できるように開発した。

起動すると、クライアント側のJavaScriptアプリがWebRTC(Webブラウザを介してリアルタイム通信できる技術)を利用して撮影した画像をサーバに送信する。サーバ側では、画像内の情報を抽出する「Google Cloud Vision」を活用して写っている物を特定し、分類結果や信頼度を返す。

これらの結果をラップ風歌詞のテンプレートに埋め込んでテキストデータ化し、音声合成サーバ「MaryTTS」に送る。MaryTTSから送り返されたwavファイル形式の音声データを基に、Webブラウザ上で音楽を同期できる「Tone.js」を使って演奏する。

実際に使ってみると分かるが、精度は高くない。最近のスマホに搭載されているカメラアプリに比べると、よく間違える。

それでも、こうしたシステムの基本的な動作を学ぶには、良い教材になる。スマホのような小さなデバイスでも、サーバと通信して各種機能を組み合わせることで、以前だったら不可能な機能を簡単に提供できるのだ。

関連記事

Webブラウザで影絵遊び AIとカメラで手の形を認識、影が動物に変身――お題コンプリートは難易度高し

Webブラウザで影絵遊び AIとカメラで手の形を認識、影が動物に変身――お題コンプリートは難易度高し

Googleが公開している最新技術のショーケース「Experiments with Google」を試す連載。今回はPCやスマホで試せる影絵遊び「Shadow Art」を体験して、AIの活用方法や魅力を紹介する。干支をモチーフにした影絵あそびは意外と難しかった。 Google、AI研究の成果を体験できるWebサイト「A.I. Experiments」公開

Google、AI研究の成果を体験できるWebサイト「A.I. Experiments」公開

Googleが、人工知能(AI)技術でどんなことができるのかを紹介するWebサイト「A.I. Experiments」を公開した。描いた絵が何だかをAIが当てるゲームや膨大な量の鳥の声のデータベースなどで遊べる。 「VOICEPEAK」と「CeVIO Pro」、 新しい音声・歌声合成製品はどこがすごいの? 商用可能でMac対応でほぼ人間

「VOICEPEAK」と「CeVIO Pro」、 新しい音声・歌声合成製品はどこがすごいの? 商用可能でMac対応でほぼ人間

人間と区別できないレベルの音声合成・歌声合成が可能なソフトが登場した。さらに重要なポイントが2つある。 女子高生AI「りんな」がラップバトル 音楽SNS「nana」で対戦相手を募集

女子高生AI「りんな」がラップバトル 音楽SNS「nana」で対戦相手を募集

音楽SNS「nana」で日本マイクロソフトの女子高生AI「りんな」の音楽活動をサポートするプロジェクトの第3弾が始まった。りんなのパートが入った音源を使ってユーザーにラップバトルをしてもらい、投稿を受け付ける。 Google、WebブラウザとCardboardでVRを体験できる「WebVR」サイト公開

Google、WebブラウザとCardboardでVRを体験できる「WebVR」サイト公開

「誰もがVRを体験できるようにするべき」と主張するGoogleが、ダンボール式HMD「Cardboard」で「WebVR」コンテンツを体験できるようにし、VR体験サイトを公開した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR