1と0は遠くて、1と7は近い――AIは手書きの数字をどう認識している? “AIの頭の中”にある多次元データをのぞこう!:遊んで学べる「Experiments with Google」(第16回)(3/3 ページ)

数値化しにくい単語をどう扱う?

ここまで数字やアヤメなど画像の認識方法を見てきた。では、単語や言葉といった数値化しにくい情報をどう扱っているのだろうか。その仕組みの一端をつかむには、「Word2Vec」というモデルを活用できる。

Word2Vecは自然言語で使われる単語をベクトル化する手法で、Googleが考案した。各単語がどのような文章で使われているかを、大量のデータを使って数値化して200次元のベクトル値で表現する。そして単語のベクトル値を比較することで、単語同士の類似度や関係を数値で示せる。

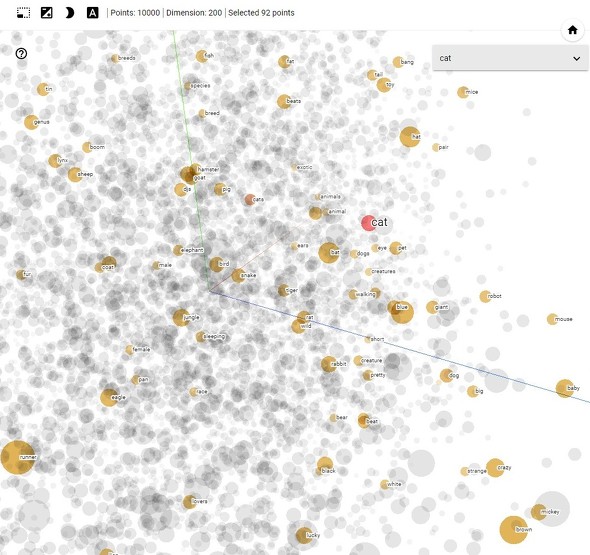

Visualizing High-Dimensional Spaceでは、1万個の単語をベクトル化した「Word2Vec 10K」で確認できる。「cat」で検索したところ、近くには「pet」「dogs」「animal」「creatures」、少し離れて「tiger」「rat」「rabbit」が存在していた。それぞれの単語が同じような文脈で使われることが多いため、周囲に分布しているのだろう。「eye」「walking」「pretty」「sleeping」という単語がcat近くにあるのも興味深い。

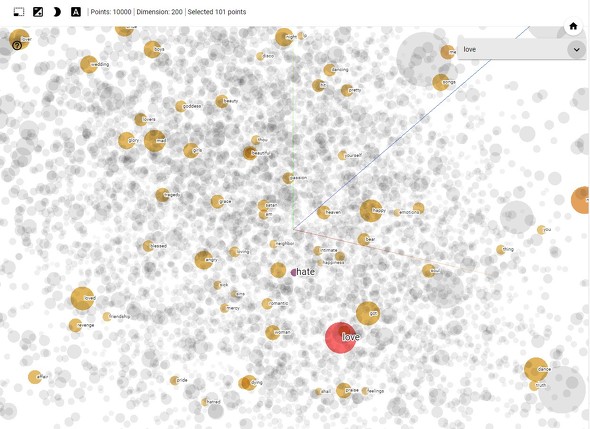

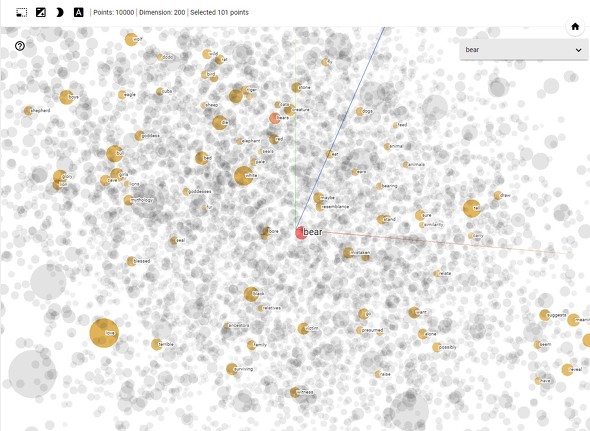

catのような具体的な物体を示す単語でなく、抽象的な「love」や多彩な意味を持つ「bear」(熊、運ぶ、辛抱するなど)を調べてみると、面白い結果になる。

文章もベクトルで表現する

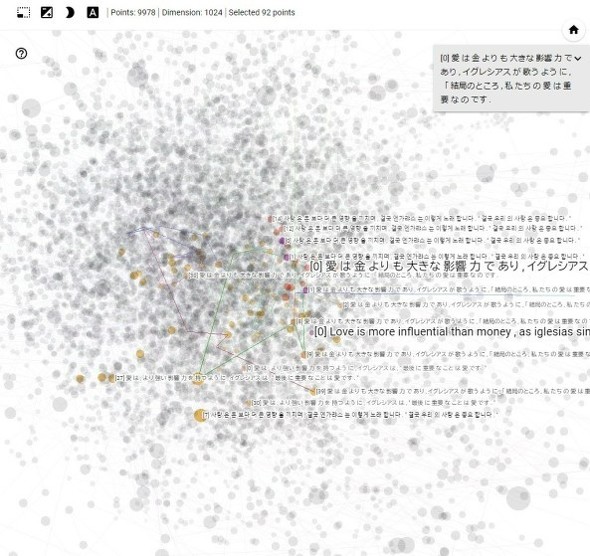

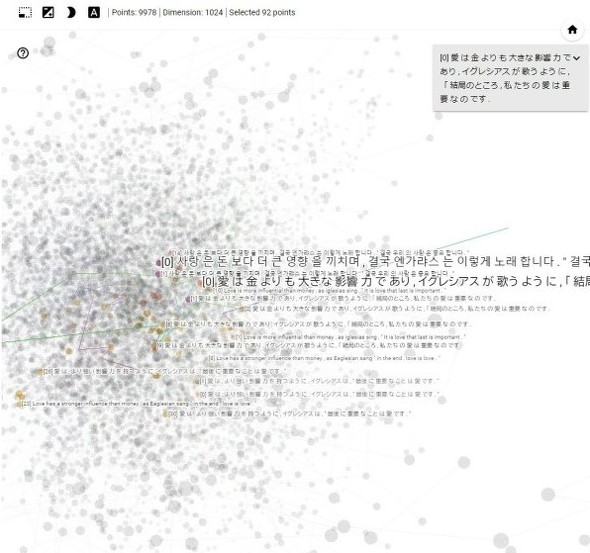

単語よりさらに抽象的で複雑なのが文章だ。これもAIで取り扱うことがある。Visualizing High-Dimensional Spaceでは、Googleが翻訳技術「Google Neural Machine Translation」(GNMT)で使っている中間言語「Interlingua」のデータを視覚化できる。ちなみに、データの次元数は1024もあり、人間には想像できない世界だ。

実際にチェックしてみると、同じ意味になる日本語と英語の文章が、近くに分布していることが分かる。

“AIの考え方”をつかめば、AIを適切に活用できる

機械学習アルゴリズムでは、ニューラルネットワークで構築されたモデル(一種の関数)に入力値を与え、得られた出力を利用して数字画像の認識や花の種類分けを実行する。この入出力で扱うデータが、Visualizing High-Dimensional Spaceの視覚化する多次元ベクトル値だ。

機械学習の動作を確認する上で多次元ベクトル値は重要だが、1つ1つが巨大で複雑なため、そのままでは人間が検証するのは難しい。そんなときにVisualizing High-Dimensional Spaceで視覚化すれば、直感的に状況をつかめる。Googleはオープンソースの機械学習ツールキット「TensorFlow」に、多次元ベクトル視覚化機能を同梱して公開しているので、必要なら活用をおすすめする。

今回紹介した多次元ベクトルの話は、AIのベースである機械学習技術のごく一部でしかない。ニューラルネットワークの仕組みや、モデルに訓練データを与えて学習させる動作などを理解しないと機械学習の全体像はつかめない。

そうした技術を学べる書籍やWebサイトはたくさんあるので、自分のレベルや目的に合ったものを選んで学ぼう。筆者の場合は、機械学習の原理を学ぶのに高校レベルの数学から復習したかったので赤石雅典さんの「最短コースで分かる ディープラーニングの数学」(日経BP)を参考にした。また自然言語処理に対するAIの応用方法や難しさを知るために、川添愛さんの「働きたくないイタチと言葉が分かるロボット」(朝日出版社)を読んでみた。

AIに関する知識を付けて、技術や処理の内容を理解すれば“AIの考え方”に対して勘が働くようになる。それを生かせば、AIを目的に合わせて使ったりチューニングしたりできる。一見すると難しそうに見えるが、Visualizing High-Dimensional Spaceのように分かりやすいものも多い。ぜひ試してみてほしい。

関連記事

AIに思い通りの絵を描かせられるのは誰だ! 「Midjourney」指示力選手権

AIに思い通りの絵を描かせられるのは誰だ! 「Midjourney」指示力選手権

画像生成AI「Midjourney」が今話題になっている。英語で絵の内容やテイストを伝えると、お題に沿った画像を生成するAIで、人間の指示力が問われる。編集部で「AIへの指示力選手権」を開いた このAI絵画のタイトルは何だ? 「Midjourney」お題当てクイズ

このAI絵画のタイトルは何だ? 「Midjourney」お題当てクイズ

ITmedia NEWS編集部で、画像生成AI「Midjourney」が出力したイラストの“お題”を当てるクイズをやってみた。AIの性格を理解する力、適切に指示する力は今後も重要なスキルになるかもしれない。 Midjourneyで話題のAI絵画は歴史的には要するにカメラである

Midjourneyで話題のAI絵画は歴史的には要するにカメラである

絵描きにショックを与えているというMidjourneyなどのAI絵画ですが、絵画の歴史的に考えると、これとほぼ同じことは過去にもありました。 Midjourneyを使って考えた「AIとクリエイティビティ」

Midjourneyを使って考えた「AIとクリエイティビティ」

西田宗千佳さんがAI描画サービスのMidjourneyを実際に試しつつ、クリエイティビティとの関係を探る。 AI作成の画像を修正する技術 単語を変えて「自転車に乗る猫」を「車に乗る猫」に 米Googleらが開発

AI作成の画像を修正する技術 単語を変えて「自転車に乗る猫」を「車に乗る猫」に 米Googleらが開発

米Google ResearchとイスラエルのTel Aviv Universityの研究チームは、AIが文章から生成した画像に修正を加えられる技術を開発した。入力に使った文章の一部を修正することで画像全体を大幅に変えず、その部分だけをピンポイントで変えられる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR