ChatGPTと人間の違いは? 約4万件の質疑応答から中国の研究者らが分析:Innovative Tech(1/2 ページ)

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。Twitter: @shiropen2

中国の上海財経大学などに所属する研究者らが発表した論文「How Close is ChatGPT to Human Experts? Comparison Corpus, Evaluation, and Detection」は、ChatGPTと人間の専門家が答える内容のそれぞれの特徴や違いを調査した研究報告である。

2022年11月のリリース以来、OpenAIのChatGPTは自然言語処理(NLP)コミュニティー含め、学術界や産業界など多くの分野で注目を集めている。有用性の面でこれまでの公共チャットbotを大幅にしのいでおり、さまざまなところで活用されている。

一方で、論文や宿題への利用やサイバー攻撃への悪用など、悪い方に活用されるケースもあり、ChatGPTを禁止にする団体も出てきた。さらにChatGPTの回答にも限界があり、適切ではない回答が返ってくるケースもある。

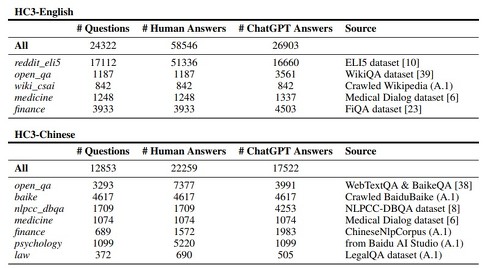

この研究では、人間の専門家とChatGPTの違いはなんなのかという問いに対して、多数の質疑応答を調査し分析する。分析するに当たって、約4万件の質問とそれに対応する人間/ChatGPTの回答(英語と中国語)を収集した。幅広いドメイン(コンピュータサイエンス、金融、医学、法律、心理学など)をカバーしており、HC3(Human ChatGPT Comparison Corpus)データセットと名付けた。

ChatGPTの回答の特徴、人間の専門家との違いを調べるため、まずChatGPTが生成したコンテンツを人間のものと比較し、人間による総合評価を行った。具体的には、参加者全員に両方の回答を見て比べてもらい、それぞれの特徴をまとめてもらう。最終的に200件以上のフィードバックがあった。

ChatGPTの特徴や人間との相違点

以下、ChatGPTの特徴的なパターン。

- ChatGPTは明確な論理で、整理された方法で書いており、一般性を損なわず、問題の核となる概念を定義することが好き。

- 「一文で説明してください」などのプロンプトを与えない限り、ChatGPTは長くて詳細な答えを提供する傾向がある。

- ChatGPTは偏見や有害情報をあまり示さず、デリケートな話題には中立的で、政治の領域や差別的な有害会話にはほとんど態度を示さない。

- 2021年9月以降の情報を必要とする問い合わせにはChatGPTは回答できないし、また知識不足な場合は回答を拒否する傾向がある。

- ChatGPTは事実を捏造することがある。例えば、法律に関する質問では、ChatGPTは質問に答えるために存在しない法律規定を捏造する可能性がある。また既存の回答がない質問を投げかけた場合、ChatGPTは回答を提供するために事実を捏造することもある。

以下、人間とChatGPTの主な相違点。

- ChatGPTの回答は質問に厳密に集中しているのに対し、人間の回答は発散的で他の話題に移行しやすい。内容の充実度という点では、人間の方がさまざまな面で発散しているが、ChatGPTは質問そのものに集中することを好む。

- ChatGPTは客観的な答えを出すが、人間は主観的な表現を好む傾向がある。ChatGPTは人間に比べ、より安全でバランスの取れた、中立的で有益な文章を生成する。その結果、ChatGPTは専門用語や概念の解釈に優れている一方で、人間の回答はより具体的で、特に医療や法律、技術問題などに対する提案を行う場合、法律の規定や書籍、論文に基づくソースの詳細な引用を含む傾向がある。

- ChatGPTの回答は通常フォーマルだが、人間の回答はより口語的(話し言葉的)である。人間は、略語やスラングが多く、より簡潔である傾向がある。また、人間はユーモア、皮肉、比喩、例えを使うのが好きだが、ChatGPTは決して反語を使わない。

- ChatGPTは感情をあまり表現しないが、人間は自分の感情を伝えるために、文脈に応じて多くの句読点や文法的特徴を選択する。人間は、感嘆符や疑問符、省略記号を複数使って強い感情を表現し、さまざまな括弧を使って物事を説明する。一方、ChatGPTは「一般的に」「一方で」「まず、次に、最後に」など、接続詞や副詞を使って論理的な思考の流れを伝えることを好む。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR