OpenAI、テキストが人間によるものかどうか判定するツールを無料公開

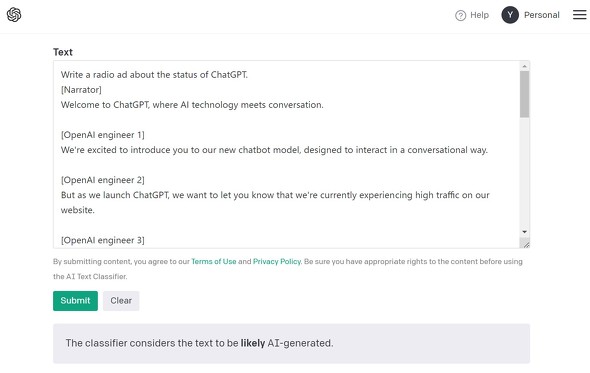

「ChatGPT」などを手掛ける米AI研究企業OpenAIは1月31日(現地時間)、テキストが人間が書いたものかAIが書いたものかを判定するツールを無料公開した。英語で書かれたテキストでのテストでは、人が書いたテキストを誤ってAI生成テキストと判定したのは全体の9%だったという。

同社は2019年にも同様の判定ツールを公開しているが、新ツールの信頼性は大幅に向上したとしている。

不完全ながらもこのツールを公開したのは、フィードバックを得るため。フィードバックも反映させつつ、AI生成テキスト検出ツールの改善を続けていく。

ツールはまだ不完全で制限事項も多く、OpenAIはこのツールを「主要な意思決定ツールとしてではなく、(AI生成かどうかを判定する)他の方法を補完するものとして」使うよう求めている。

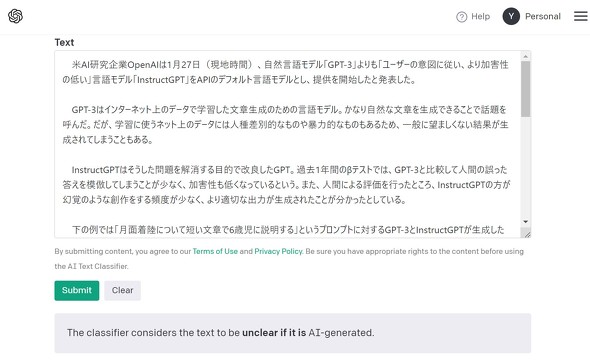

1000文字以上ないと判定できない。また、英語以外の言語では精度が大幅に下がる。コード(プログラム)についての判定結果は信用できない。人間が書いたテキストをAI生成だと自信を持って判定することがある。判定は、AI生成の可能性が非常に低い、低い、不明確、可能性がある、可能性が高いの5段階。

人間が書いたと確認済みの1000文字以上の日本語テキスト(アイティメディアの記事)で試したところ、判定は中間の「不明確」だった。

ChatGPT公開以来、スパムメール作成や学生による論文作成への利用が問題になっている。米国の教育機関の中には、ChatGPTの利用を禁止したところもある。

OpenAIは、「われわれは米国の教育者と協力し、ChatGPTの機能と制限について話し合って」おり、AI関連の問題の影響を受けている教育者に対し、フィードバックを送るよう求めた。

関連記事

ChatGPTと人間の違いは? 約4万件の質疑応答から中国の研究者らが分析

ChatGPTと人間の違いは? 約4万件の質疑応答から中国の研究者らが分析

中国の上海財経大学などに所属する研究者らは、ChatGPTと人間の専門家が答える内容のそれぞれの特徴や違いを調査した研究報告を発表した。 有能な秘書か、大ぼら吹きか 「ChatGPT」をスプレッドシートで使えるアドオンを試してみた

有能な秘書か、大ぼら吹きか 「ChatGPT」をスプレッドシートで使えるアドオンを試してみた

ビジネスツールであるスプレッドシートからChatGPTが呼び出せると、景色はちょっと変わる。行列の見出しを入力するだけで、自動で無限に欲しい情報が手に入る。 ChatGPTの言語モデル「GPT-3.5」、司法試験を受ける 結果は?

ChatGPTの言語モデル「GPT-3.5」、司法試験を受ける 結果は?

米Chicago-Kent College of Lawに所属する研究者らは、OpenAIの大規模言語モデル「GPT-3.5」で米国司法試験を受けるとどうなるかを検証した研究報告を発表した。 「AIで詐欺メールと攻撃プログラムの生成に成功」 セキュリティ企業が注意喚起 知識なくても攻撃可能に

「AIで詐欺メールと攻撃プログラムの生成に成功」 セキュリティ企業が注意喚起 知識なくても攻撃可能に

チェック・ポイント・ソフトウェア・テクノロジーズは、ChatGPTを使ったサイバー攻撃が起きる可能性があるとして注意喚起した。フィッシングメールや攻撃プログラムの生成に成功したという。 ChatGPTによる回答をStack Overflowが一時的に禁止 大量のもっともらしいが不正確な回答に対処しきれず

ChatGPTによる回答をStack Overflowが一時的に禁止 大量のもっともらしいが不正確な回答に対処しきれず

質問するともっともらしい回答をくれるOpenAIの「ChatGPT」。プログラミング関連のQ&AサイトStack OverflowがChatGPTで生成した回答の投稿を一時的に禁止した。このAIで生成したとみられる不正確な回答が急増したため。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR