AIプロ集団から見た「ChatGPTの歴史」 たった5年で何が起こったのか(2/2 ページ)

GPT-3の登場 パラメータは10倍、コストは460万ドルに

このScaling Lawという性質にのっとって、OpenAIは当時最大のパラメーター数を誇ったAIの10倍大きいモデルを約460万ドルかけて構築するという力業に出た。そしてできたのが「GPT-3」だ。

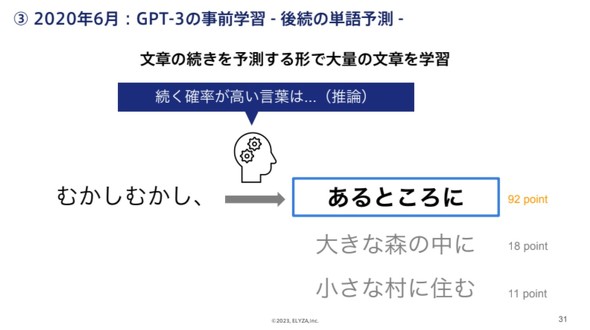

GPT-3は、「『むかしむかし』に続く文章は何か」というように文章の続きを予測させる形で大量の文章を学習した。AIに適切な指示を出せば、直後に続ける形でさまざまなタスクを実行できるようになった。

GPT-3リリース当時は、AIにプログラムを生成させる実験が注目されていた。「こんなアプリケーションが欲しい」と文章で指示を出せばAIがプログラムを書くというデモンストレーションが衝撃を与えていた。実際にプログラミングツールへの組み込みもされた。

同時期にはLINEもGPT-3以上の規模で日本語特化の大規模言語AIを開発すると宣言していた。

大規模化と同時に進んだオープンソース化 GAFAM独占を恐れて?

それ以降はモデルの大規模化が進んでいった。GPT-3のパラメータ数が1750億だったのに対し、米Alphabet傘下のDeepMindの「Gopher」は2800億(21年)、Google「PaLM」は5400億(22年)、中国では1兆7500億(21年)という規模のAIも開発された。

曽根岡CEOによると、GAFAMの独占を恐れてか、22年にはオープンソース化の流れも出てきたという。

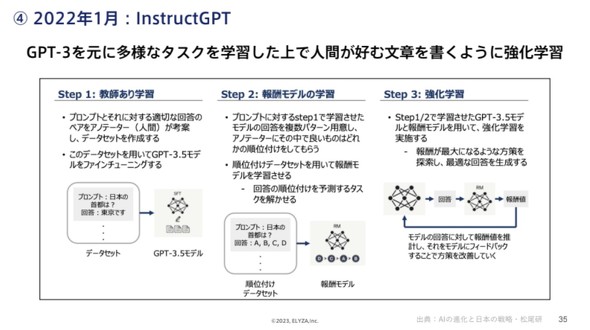

そんな中で、GPT-3の改良版「InstructGPT」も登場した。これは「日本の首都は?」「東京です」という応答のセットを使ってAIを調整したのちに、AIの解答へのフィードバックを繰り返すことで人間が好む文章を書くようにしたモデルだ。これが今のChatGPTにもつながっていく。

GPT-4は精度向上・捏造率低下

そして23年3月にはGPT-4が登場した。画像を入力に使えるなど機能面でのアップデートもあるが、精度面ではさまざまな言語での精度向上が注目点の一つという。

GPT-4にさまざまな国と地域の言語で高校・大学の問題を解かせたところ、調べたほとんどの言語でGPT-3.5における英語での解答より好成績だったという。

米国の司法試験模試で上位10%の成績をとるなど専門領域でも高いパフォーマンスを示した。

これが大規模言語AIの歴史だ。ここまででまだ5年たっていない。特にMicrosoftとOpenAIのタッグはかなりのスピード感で開発を進めユーザー獲得をしている。18年の大規模言語AI登場の4年後にChatGPTを公開したかと思えば即座に億単位のユーザーを獲得し、気付けばMicrosoftが追加出資を決め、ChatGPTの有料プランやAPIを公開し、GPT-4が登場した。

この競争環境に日本のIT業界はついていけるのかが今後の注目点となるだろう。

関連記事

機械に人間は裁けるか? 東大学園祭で「AI模擬裁判」開廷 GPT-4が裁判官に

機械に人間は裁けるか? 東大学園祭で「AI模擬裁判」開廷 GPT-4が裁判官に

東京大学の学園祭「五月祭」で、「AI法廷の模擬裁判」という催しが行われる。GPT-4が裁判官となって判決を下すという企画で、コンセプトは「機械に人間はさばけるか──?」という。 最新AI「GPT-4」利用殺到か 受付メッセージ数半減 4時間100問→50問に

最新AI「GPT-4」利用殺到か 受付メッセージ数半減 4時間100問→50問に

話題の「GPT-4」は、ChatGPTの有料版「ChatGPT Plus」で利用できる。当初は4時間当たりの100メッセージまで受け付けていたが、50に半減した。 ワードやエクセルと「GPT-4」が合体 「Microsoft 365 Copilot」発表 日本のDXも爆速化?

ワードやエクセルと「GPT-4」が合体 「Microsoft 365 Copilot」発表 日本のDXも爆速化?

米Microsoftのオフィスアプリ「Microsoft 365」に新機能「Microsoft 365 Copilot」が登場した。大規模言語モデル「GPT-4」を内蔵することで、「ChatGPT」のように「Word」や「Excel」などの作業をチャットするだけでサポートしてくれる。 「GPT-4」搭載ChatGPTに東大入試数学を解かせてみた GPT-3.5との回答の違い、点数は?

「GPT-4」搭載ChatGPTに東大入試数学を解かせてみた GPT-3.5との回答の違い、点数は?

AIチャットbot「ChatGPT」「新しいBing」に、人間には答えにくい質問や、答えのない問い、ひっかけ問題を尋ねてみたらどんな反応を見せるのか。それぞれの反応からAIの可能性、テクノロジーの奥深さ、AIが人間に与える“示唆”を感じ取ってほしい。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR