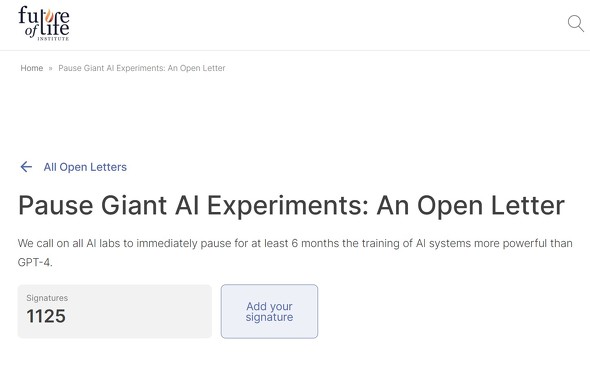

「GPT-4より強力なAIの開発を直ちに停止せよ」──公開書簡にマスク氏やウォズニアック氏が署名

AIの安全性について研究する非営利の研究組織Future of Life Institute(FLI)は3月28日、GPT-4よりも強力なAIシステムの開発と運用を少なくとも6カ月間停止するように呼びかける書簡を公開し、本稿執筆現在1000人以上が署名している。イーロン・マスク氏や、米Appleの共同創業者、スティーブ・ウォズニアック氏の名前もある。

人類にとって深刻なリスクをもたらす可能性のある一般的なタスクにおいて、人間と競合するようになったAIシステムに対する懸念から提示された。現在のAI技術が安全性や倫理性の問題を引き起こす可能性があるため、研究者や開発者に対して、これらのリスクを十分に評価し、必要な対策を講じるよう呼びかけている。

また、AIがもたらす利益とリスクの均衡を保つために、国際的な協力と競争の制限が重要だと主張する。信頼性、アライメント、忠誠心などを確保するために必要な共通の安全プロトコルの開発と実施を提唱している。

一時停止がすぐに出来ない場合、政府が介入してモラトリアムを設定する必要があるともしている。

「サピエンス全史」で知られる作家のユヴァル・ノア・ハラリ氏、Stability AIのエマード・モスタークCEO、GoogleのLaMDAに貢献しているCharactar.aiのノーム・シェイザーCEOなども署名している。Googleやその傘下のDeepMind、Amazon、Microsoft傘下のGitHubなどのエンジニアの名前もあるが、今のところMicrosoft、OpenAI、MetaなどAIに注力している大手の幹部や従業員の名前はない。

MetaのチーフAIサイエンティストを務めるヤン・ルカン氏は「私はこの書簡に同意しないし、署名もしない」とツイートした。

【更新履歴:2023年3月29日午後9時10分 Yann LeCun氏のカタカナ表示を修正しました。】

関連記事

GPT-4が労働市場に与える影響と各職種のリスク評価──OpenAIの研究者が論文発表

GPT-4が労働市場に与える影響と各職種のリスク評価──OpenAIの研究者が論文発表

「GPT-4」を手掛けたOpenAIの研究者が「GPTはGPT:LLMの労働市場への影響の可能性に関する初期の考察」と題した論文を発表した。米国の労働力の約8割が、少なくとも仕事の1割にGPT導入の影響を受ける可能性があるとしている。影響を受けやすいのはジャーナリスト、翻訳者、Webデザイナーなど。 AIプロ集団から見た「ChatGPTの歴史」 たった5年で何が起こったのか

AIプロ集団から見た「ChatGPTの歴史」 たった5年で何が起こったのか

AIのプロ集団であるELYZAが現在大流行中の「ChatGPT」について、その進化の歴史を解説した。ほとんどの出来事はここ5年以内に起こっており、市場環境は目まぐるしく変化している。 OpenAI、AGI(人間より賢いAI)へのロードマップを公表 「世界に深刻な害を及ぼす可能性」回避のために

OpenAI、AGI(人間より賢いAI)へのロードマップを公表 「世界に深刻な害を及ぼす可能性」回避のために

会話型AIサービス「ChatGPT」を手掛けるOpenAIは、AGI(Artificial General Intelligence;汎用人工知能)実現のロードマップを公開した。同社はAGIを「一般的に人間より賢いAIシステム」と定義する。AGIが世界に害を及ぼさないよう、公開協議が必要としている。 Googleを解雇されたAI倫理研究者が指摘していた「大規模言語モデル」の危険性

Googleを解雇されたAI倫理研究者が指摘していた「大規模言語モデル」の危険性

AI界隈で一目置かれているGoogleの倫理的AIチームリーダー、ティムニット・ゲブルさんが突然解雇されたとツイート。ゲブルさんは黒人女性ですが、発表しようとしていた言語モデルの問題点についての論文が原因のようです。 人工知能(AI)の“ターミネーター化”防止目的の37の研究にFLIが総額700万ドル提供

人工知能(AI)の“ターミネーター化”防止目的の37の研究にFLIが総額700万ドル提供

AIの安全性を研究する非営利団体Future of Life Instituteが、選抜した37の研究チームに総額700万ドルを提供する。例えばAIに態度から相手の好みを推測する人間のような能力を与える研究などが選ばれた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR