百花繚乱の大規模言語モデル その現状まとめ【2023年4月末版】:清水亮の「世界を変えるAI」(2/3 ページ)

特に注意すべきは、アーキテクチャとデータセットの組み合わせだ。

大規模言語モデルは、基本的にはアーキテクチャとデータセットを組み合わせたものである。ほとんどの大規模言語モデルはTransformerなので、差が出るとすれば、パラメータ数と学習に用いたデータセットになる。

RWKV(ルワクフと読むらしい)は、この表の中では唯一、独自のRNNベースのアーキテクチャをもっており、Transformerに比べると高速でしかも高価なVRAMを必要としないため、コミュニティが活発で期待されているものの1つである。

RWKVにAlpaca Datasetを学習させたRavenは中でも活発に学習されており、毎週のようにバージョンアップされている。

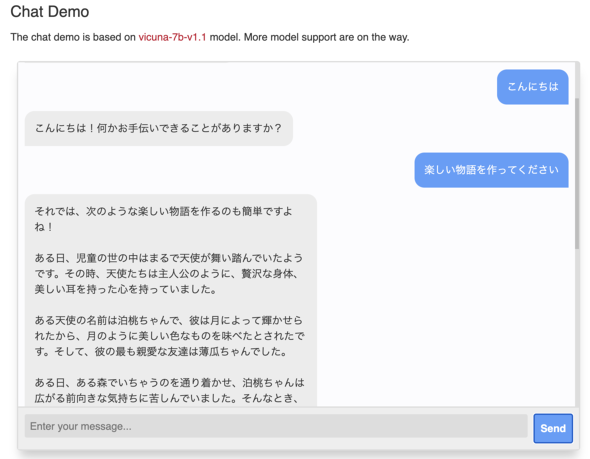

VicunaはWebGPUで動作するバージョンも公開されており、このバージョンのVicunaはWebGPU対応のブラウザがあればローカルで(つまり手元のPCで)動作する。要はNVIDIAの高価なGPUが不要になるわけで、このインパクトはすごい。

いまのところWebGPU対応ブラウザは多くないが、MacならChromeの開発者版であるChrome Canaryで試すことができる。

限定的ではあるが日本語も使えるし、GPT-4ほどではないが、英語ならGPT-3くらいのことはわずか7B(70億パラメータ)でもできそうな雰囲気がある。

というか、結局は「AIに何を聞きたいか」という人間側の都合の話という気もする。例えばLLaMAはGPT-3の10分の1程度のパラメータ数である13Bで、ほとんどのベンチマークでGPT-3と同等か、それ以上のスコアを達成したと説明されていた。

それはLLaMAが単純にGPT-3を上回っているということを意味するわけではなく、ベンチマークが大規模言語モデルの性能を測る上であまり意味をなさなくなってきていると考えるべきだろう。

例えばGPT-3とGPT-4を比べると、明らかにGPT-4の方が「高度な結果」を返して来るのだが、具体的に何がどのように高度なのか、定量的に説明するのが難しい。

日本ではGPTを大学のレポートに使うことの是非が問われるが、そもそもGPTをはじめとした言語モデルの出力の良し悪しを判断することが、もはや人間にも機械にも難しくなってきているのだ。

関連記事

なぜ人々は、ChatGPTという“トリック"に振り回されるのか? Google「Bard」参戦、チャットAI戦争の行方

なぜ人々は、ChatGPTという“トリック"に振り回されるのか? Google「Bard」参戦、チャットAI戦争の行方

OpenAIが2022年に発表した対話型AI「ChatGPT」の衝撃は、米国ビッグテック最強の一角であるGoogleを動揺させた。Googleは急ぎ「Bard」と名付けたチャットボットを投入し、巻き返しを図る。 仕事で使うGPT-4実践テクニック 実際に「AIアートグランプリ」の事務局で使ってみた

仕事で使うGPT-4実践テクニック 実際に「AIアートグランプリ」の事務局で使ってみた

第一回AIアートグランプリの興奮もさめやらぬなか、GPT-4があっさりと公開。せっかくなので、まずは第一回AIアートグランプリの報告書をGPT4にまとめてもらってみる。さらにChain of Thoughtでキャッチフレーズを考えさせるなど、事務局の仕事に活用してみた。 AIで好きなポーズを出すために、モデルを10万枚撮影して手動でタグ付けしてみた

AIで好きなポーズを出すために、モデルを10万枚撮影して手動でタグ付けしてみた

最初にAIで漫画を描くときのハードルは、「同じキャラクターが出せない」というものだったが、これはDreambooth(Memeplexではカスタムモデル学習)を使うことで解決できた。次のハードルは、「欲しいポーズが出せない」というものである。 日本を画像生成AIで再現する 「自分の見た景色」を学習したAIは強力な思い出再生装置に

日本を画像生成AIで再現する 「自分の見た景色」を学習したAIは強力な思い出再生装置に

AIで漫画を書こうとするとひとつ不便なことがある。StableDiffusionの元になっている学習データは「全世界」の画像を使っているので、日本人がイメージするような「郵便局」とはまったく異なるイメージになってしまう。そこで街のあちこちの景色を写真に撮った。これをAIに学習させて、独自の日本的な画像生成AIを作ろうというのだ。 まさに「世界変革」──この2カ月で画像生成AIに何が起きたのか?

まさに「世界変革」──この2カ月で画像生成AIに何が起きたのか?

2022年8月22日。日本時間にして午前4時ごろ、「世界変革」はついに実行された。「どんな絵も描ける」AIである「Stable Diffusion」がついにオープンソースとして公開されたのだ。そこからの2カ月を振り返る。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR