百花繚乱の大規模言語モデル その現状まとめ【2023年4月末版】:清水亮の「世界を変えるAI」(3/3 ページ)

トークン数の増加で長期記憶をもたせる

また、現状公開されている大規模言語モデルには全く別の問題点もある。それは、同時に扱える「トークン数」が極端に少ないということだ。

大規模言語モデルは、入力された文字列を内部で「トークン」という単位に区切る。英語の場合、トークンは一単語として扱われることが多いが、日本語など、非英語圏の言語では一文字の情報量が多いので一文字が複数トークンに分割されることが多い。その結果、GPTを使う時などは英語を使った方がより「良い」結果が得られるように思える。

GPT-3が扱えるトークン数は4096程度であり、GPT-4になっても普通に使えるのは8192トークン。日本語の文字数にしてトークンは3分の2くらいと考えられるので、大体、GPT-3で3000字程度、GPT-4で6000字程度ということになる。本一冊が大体10万字であるため、GPTは本一冊分の情報を整合性を保って認識することが通常では不可能である。

そこで最近注目を浴びているのが、AutoGPTやBabyAGI、それらを扱うLangChainなどの、「大規模言語モデルに長期記憶を持たせる」仕組みの構築だ。

原理としては、大規模言語モデルの出力をいったんファイルやデータベースに保存し、その情報を見ながらより複雑な指示に答える、というものである。

AgentGPTも最近日本語に対応したので、プログラミングができない人でも手軽にこうしたモデルを試すことができるようになった。

しかし、これは完璧な解決策とはほど遠く、その場しのぎのものに筆者には見える。

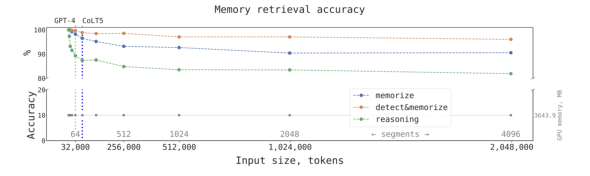

というのも、GPT-4は3万2000トークンに拡張されることがアナウンスされているし、RWKVはRNNなので原理上は長期記憶も持っている。

また、新しく注目を浴びているアーキテクチャであるHyenaは1万トークン以上の処理を可能にする上に、Transformerに対してトークン数が増えれば増えるほど高速という性能をウリにしている。

さらに、最近発表されたリカレントメモリートランスフォーマーという方式では、Transformerで100万トークンを扱えるようになったと主張している。

こうなると、AutoGPTが回避しようとしている「トークン数の制限」は、ほとんど無意味になるように見える。しかし「長いトークン」に配慮した結果、どれだけ全体の整合性を保てるのかは全くの未知数であるため、判断は保留したい。

100万トークンといえば、小説でも10巻以上に相当し、人間の著者でも完璧な整合性を維持できるとは言い難い。それが果たして本当に矛盾なく意味を維持できるか(そしてそれを人間または機械はどうやって確認するのか)は、そもそもそんなデータセット自体を人間が持っていない可能性がある。要は一人の人間が100万トークンもの矛盾しない文章を書いた例がほとんどないという問題にぶち当たる。

筆者はよくGPTをはじめとする言語モデルを「人間社会の鏡のようなもの」と説明する。りんごをどれだけ美しく鏡に映そうとしても、それが蝶になることは永遠にないのと同じように、人間がどれだけ自分たちより賢い(またはそう見える)機械を作ろうと奮闘しても、人間より賢くなることはあり得ないのかもしれない。

筆者プロフィール:清水 亮

新潟県長岡市生まれ。1990年代よりプログラマーとしてゲーム業界、モバイル業界などで数社の立ち上げに関わる。2005年、IPA(情報処理推進機構)より「天才プログラマー/スーパークリエイタ」として認定。株式会社ゼルペム所属AIスペシャリスト。現在も現役のプログラマーとして日夜AI開発に情熱を捧げている。

関連記事

なぜ人々は、ChatGPTという“トリック"に振り回されるのか? Google「Bard」参戦、チャットAI戦争の行方

なぜ人々は、ChatGPTという“トリック"に振り回されるのか? Google「Bard」参戦、チャットAI戦争の行方

OpenAIが2022年に発表した対話型AI「ChatGPT」の衝撃は、米国ビッグテック最強の一角であるGoogleを動揺させた。Googleは急ぎ「Bard」と名付けたチャットボットを投入し、巻き返しを図る。 仕事で使うGPT-4実践テクニック 実際に「AIアートグランプリ」の事務局で使ってみた

仕事で使うGPT-4実践テクニック 実際に「AIアートグランプリ」の事務局で使ってみた

第一回AIアートグランプリの興奮もさめやらぬなか、GPT-4があっさりと公開。せっかくなので、まずは第一回AIアートグランプリの報告書をGPT4にまとめてもらってみる。さらにChain of Thoughtでキャッチフレーズを考えさせるなど、事務局の仕事に活用してみた。 AIで好きなポーズを出すために、モデルを10万枚撮影して手動でタグ付けしてみた

AIで好きなポーズを出すために、モデルを10万枚撮影して手動でタグ付けしてみた

最初にAIで漫画を描くときのハードルは、「同じキャラクターが出せない」というものだったが、これはDreambooth(Memeplexではカスタムモデル学習)を使うことで解決できた。次のハードルは、「欲しいポーズが出せない」というものである。 日本を画像生成AIで再現する 「自分の見た景色」を学習したAIは強力な思い出再生装置に

日本を画像生成AIで再現する 「自分の見た景色」を学習したAIは強力な思い出再生装置に

AIで漫画を書こうとするとひとつ不便なことがある。StableDiffusionの元になっている学習データは「全世界」の画像を使っているので、日本人がイメージするような「郵便局」とはまったく異なるイメージになってしまう。そこで街のあちこちの景色を写真に撮った。これをAIに学習させて、独自の日本的な画像生成AIを作ろうというのだ。 まさに「世界変革」──この2カ月で画像生成AIに何が起きたのか?

まさに「世界変革」──この2カ月で画像生成AIに何が起きたのか?

2022年8月22日。日本時間にして午前4時ごろ、「世界変革」はついに実行された。「どんな絵も描ける」AIである「Stable Diffusion」がついにオープンソースとして公開されたのだ。そこからの2カ月を振り返る。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR