ITmedia NEWS >

企業・業界動向 >

「りんな」開発元、大規模言語モデルを公開 36億パラメーターで日本語特化

» 2023年05月17日 18時40分 公開

[ITmedia]

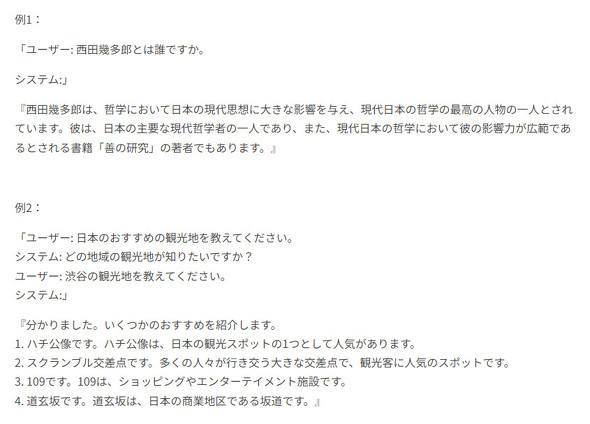

コミュニケーションAI「りんな」を提供するrinnaは5月17日、同社が開発したGPTベースの大規模言語モデルをオープンソースで公開した。日本語に特化した36億パラメーターを持つ汎用言語モデルと、対話言語モデルの2種類を用意。Hugging Faceでダウンロードできる。

汎用言語モデルは、日本語のWikipedia、C4、CC-100のオープンソースデータを元に作成。対話言語モデルは、HH-RLHF、SHP、FLANの一部を日本語に翻訳したデータを用いて学習する。特定の利用目的に最適化できるよう、fine-tuningやin-context learningによる精度向上も可能という。

同社はこれまで、日本語に特化した13億パラメーターのGPT言語をはじめ、BERT、HuBERT、CLIP、Stable Diffusionなどテキスト、音声、画像に関する事前学習モデルを公開。Hugging Faceでのモデルダウンロード数は累計160万を超えているという。

関連記事

サイバーエージェントが公開した大規模言語モデルの実力を試す

サイバーエージェントが公開した大規模言語モデルの実力を試す

5月16日、サイバーエージェントが商用利用可能な7B(68億パラメータ)の大規模言語モデルOpenCalm7Bを公開した。早速その実力を試してみた。 AIりんな、VTuberになる “中の人”は存在せず、AIがコメントに反応 YouTube、TikTokで配信

AIりんな、VTuberになる “中の人”は存在せず、AIがコメントに反応 YouTube、TikTokで配信

日本マイクロソフト発ベンチャーのrinnaが、自社キャラクター「AIりんな」をバーチャルYouTuberとしてデビューさせると発表した。YouTubeやTikTokで配信しながら視聴者と交流する。 「りんな」提供元、ChatGPTの技術を製品開発に活用へ 「Azure OpenAI Service」導入

「りんな」提供元、ChatGPTの技術を製品開発に活用へ 「Azure OpenAI Service」導入

rinnaが大規模自然言語処理モデル「GPT-3」などをクラウドサービス「Microsoft Azure」上で利用できる「Azure OpenAI Service」を導入。既存技術と組み合わせ、製品開発に活用するという。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR