東大発AIベンチャー、最大級の日本語LLM公開 metaの「Llama 2」を日本語化

東京大学松尾研究室発のAIスタートアップ、ELYZAは8月29日、日本語LLM(大規模言語モデル)「ELYZA-japanese-Llama-2-7b」を公開した。米Meta PlatformsのLLM「Llama 2」に日本語で追加事前学習を行い“日本語化”した。

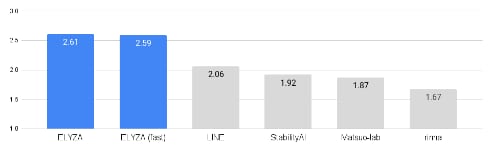

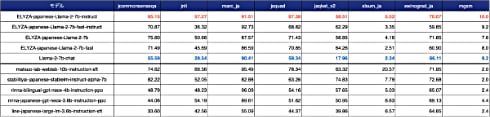

Llama 2の中では最も小さい70億パラメータのモデルを使用したが、性能評価では1750億パラメータを持つ「GPT-3.5 (text-davinci-003)」に匹敵するスコアを叩き出した。「日本語の公開モデルの中では最高水準の性能」。

ライセンスはLLAMA 2 Community Licenseに準拠しており、研究や商業目的で利用できる。同日、chatUI形式のデモ、推論用コード、性能評価用のデータセットと具体的な評価結果シートを公開した。デモはHugging Face hubで、また日本語化で得られた知見やノウハウを技術ブログとしてnoteに掲載している。

ELYZAは「国内では複数の企業が独自に日本語LLMの開発に取り組んでいるが、まだまだ小規模なものにとどまっている」と指摘。今回のように他の言語で学習されたLLMを用い、日本語で必要な学習量を減らすことで日本語LLMの開発を加速できるとした。同社は、Llama 2の130億/700億パラメータのモデルの日本語化にも着手済みで、今回と同様に公開を検討していく。

Llama 2は、7月18日にMetaが公開した英語ベースの大規模言語モデル。非常に性能が高く、英語圏ではOpenAIの「GPT-4」やGoogleの「PaLM」などのクローズドなLLMに対し、オープンモデルのデファクトスタンダードとなりつつある。

関連記事

Stability AI Japan、日本語言語モデル「Japanese StableLM Alpha」公開 他社上回る性能、商用利用も可能

Stability AI Japan、日本語言語モデル「Japanese StableLM Alpha」公開 他社上回る性能、商用利用も可能

英Stability AIの日本法人であるStability AI Japanは、日本語向け大規模言語モデル(LLM)「Japanese StableLM Base Alpha 7B」を公開した。パラメータは70億。ライセンスはApache License 2.0で、商用利用可能だ。 機械に話しかけて設定できる時代が来る? なぜ“小規模”なLLMが求められるのか

機械に話しかけて設定できる時代が来る? なぜ“小規模”なLLMが求められるのか

LLMにおいて、学習パラメータ数は性能に直結する。一方で、注目を集めているのがLLaMaのような小規模なモデルだ。それはなぜか。 サイバーエージェント、日本語の大規模言語モデルを一般公開 最大68億パラメータ 商用利用可能

サイバーエージェント、日本語の大規模言語モデルを一般公開 最大68億パラメータ 商用利用可能

サイバーエージェントは最大68億パラメータの日本語LLM(大規模言語モデル)を一般公開した。ライセンスはCC BY-SA-4.0で、商用や研究目的で自由に利用できる。 “和製GPT”競争勃発か サイバーエージェント、独自の日本語LLM発表 「活用を始めている」

“和製GPT”競争勃発か サイバーエージェント、独自の日本語LLM発表 「活用を始めている」

サイバーエージェントは11日、独自の日本語LLMを発表した。すでに130億パラメータまで開発が完了し、広告の制作などに活用を始めているという。 百花繚乱の大規模言語モデル その現状まとめ【2023年4月末版】

百花繚乱の大規模言語モデル その現状まとめ【2023年4月末版】

米OpenAIが独占的に提供する大規模言語モデル(LLM)に対し、さまざまなLLMが登場している。特に注目はオープンで自由な大規模言語モデル「Dolly-v2」だ。さながら現在は「不自由な大規模言語モデルと自由な大規模言語モデルの小競り合い」が起きている状態だ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR