「人を審査するAI」のリスクとは? 現金給付アルゴリズムが“暴走”した世界銀行の事例:事例で学ぶAIガバナンス(1/3 ページ)

イーロン・マスク氏などを筆頭に、AIの野放図な発展に反対する姿勢を取る人物は多い。AIは強力な存在であるが、何の制約もなく放置していては、大きな悪影響が生じる懸念がある。そのためAI導入を検討する企業の中には、あらかじめ自社が守る「AI倫理」を定めておき、この技術が正しく機能することを担保しようとするところが増えている。

そのAI倫理を構成する要素の一つが「透明性」(Transparency)だ。これは「あるAIがどのように機能するのか」「どのようにして特定の結論に至るのか」が外部からも理解できるようになっている状態を指す。特に後者の透明性は「説明可能性」(Explainability)と呼ばれる場合もある。

例えば、求人に応募してきた志望者の履歴書を読み込ませると、その人物を面接に進ませるかどうかを判断するAIシステムがあった場合、ある履歴書がなぜ合格になったのか(あるいは不合格になったのか)を志望者にも説明できるようになっているのが説明可能性だ。

そこから一歩進んで、このシステムの裏側にあるAIモデルのアルゴリズムやアーキテクチャ、さらにはモデルの学習に使われたデータセットの詳細、AIシステムの運用手順などまで公開されているのが、透明性が確保された状態といえる。

一方、企業や組織にとってAIは優位性を生み出す存在のため、その中身をさらけ出すというのは手の内を見せるようなものだ。またAIを実現する技術によっては、そもそもそれを開発した人物にも、なぜAIが特定の結論に至るのかよく分からないという場合もある。

そのため透明性の追求に踏み切り、実現し、維持することは容易ではない。しかしそれが、前述のAI規制論者が懸念するような、AIの社会的悪影響を防いだり検証したりするために欠かせない場合もある。

世界銀行が支援するプロジェクトで起きた事件

6月、国際的な人権NGOであるヒューマン・ライツ・ウォッチが「Automated Neglect」(自動化されたネグレクト)と題された報告書を発表した。「ネグレクト」とは、最近日本でも育児放棄などの文脈で使われることが増えてきたが、保護すべき対象を保護せず放置しておく行為を指す。それが「自動化」されているとは、一体どういうことなのか。

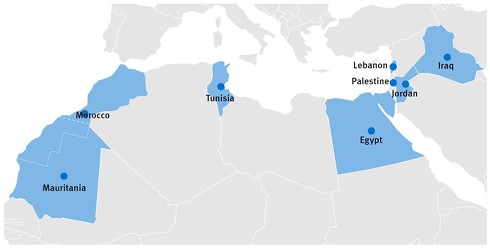

同機関は貧困の根絶を目指し、中東・北アフリカ地域で現金給付プログラムを支援している。「貧困ターゲティング」と呼ばれるこのプロジェクトは、所得などの条件から受給者を選別する。このターゲティングをより正確で効率的にするために、世界銀行はさまざまな技術に投資してきた。そうした技術の一つが、受給者を自動的に選別するアルゴリズムだ。

報告書では特に、ヨルダンで行われた「Unified Cash Transfer Program」(統一現金給付プログラム)という事例を取り上げている。このプログラムは「Takaful」(タカフル)という名前が付けられ、基本的な受給資格を満たさない家族を選別した後、経済的脆弱性(その家族が経済的な困窮状態にどの程度陥りやすいか)をランク付けし、どの家族が現金給付を受けるべきかを特定するアルゴリズムを用いている。

このアルゴリズムが適切に機能すれば、現金を手にすべき家族を効率的に選別し、彼らを迅速に救済できるだろう。しかし実際には、アルゴリズムが機能不全を起こしているために「社会保障を受ける権利を奪っている」とヒューマン・ライツ・ウォッチは指摘している。それが「自動化されたネグレクト」というわけだ。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR