Meta、独自の動画生成AI「Emu Video」と編集AI「Emu Edit」を紹介

米Metaは11月16日(現地時間)、拡散モデルに基づいてテキストから動画を生成するモデル「Emu Video」と、マルチタスク画像編集モデル「Emu Edit」を発表した。いずれも同社がMeta Connectで発表した独自の画像生成の基盤モデル「Emu」(Expressive Media Universe)に基づいて構築したものだ。

マーク・ザッカーバーグCEOは自身のFacebookへの投稿で、「これらのツールをFacebookやInstagramの動画や画像に統合しようとしている」と語った。

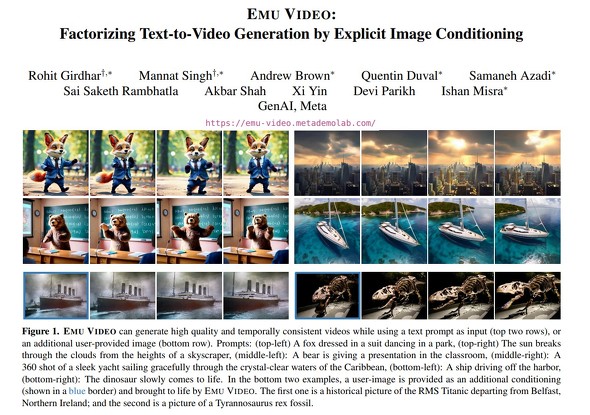

4秒間の動画を生成する「Emu Video」

Emu Videoは、まずテキストプロンプトで画像を生成し、次に生成した画像と新たなテキストに基づいて動画を生成するという2段階プロセスで動画を生成する。こうすることで、動画生成モデルを効率的にトレーニングできるという。

生成できるのは、512×512ピクセルで、1秒当たり16フレームの長さ4秒の動画。

専用サイトでいくつかのサンプルを試すことができる。

テキストプロンプトで画像を編集する「Emu Edit」

Emu Editは、ローカル/グローバル編集、背景の削除/追加、色やジオメトリの変換、検出とセグメンテーションなどの操作を、テキストプロンプトで行える画像編集ツール。

このモデルをトレーニングするために1000万個の合成サンプルを含むデータセットを開発したという。各サンプルに、入力画像、実行するタスクの説明、ターゲットの出力画像が含まれる。Metaは、1000万個というのはこの種のデータセットとしては最大だとしている。

グラスにオレンジジュースを注ぐ画像サンプルでは、「画像に『オレンジジュース』という文字を入れる」「アペロールスプリッツにする」「テキストを削除」「背景をプールサイドに」「グラスを金のゴブレットに変更」「ゴブレットにサングラスを追加」「ルネッサンス風のスタイルに変換」というプロンプトで画像が変わっていく様子が紹介されている。

Metaは、これらのモデルはまだ研究の途上にあるとし、公開する予定なのかどうか、FacebookやInstagramで利用できるようにするのはいつなのか、などについての説明はない。

「プロのアーティストやアニメーターに代わるものではないが、人間が自分自身を表現するのに役立つ可能性はある」としている。

いずれのモデルも専用サイトで試せる。

関連記事

Google、文章から動画を生成するAI「Imagen Video」を紹介 Metaに続き

Google、文章から動画を生成するAI「Imagen Video」を紹介 Metaに続き

Google Researchは、短い文章から短い動画を生成するAIシステム「Imagen Video」を発表した。Metaの「Make-A-Video」と同様にまだ不自然でぼやけてはいるが、テキストレンダリングや3D表示などが可能。悪用軽減対策ができるまではモデルとコードは公開しない。 Meta、画像生成モデル「Emu」でInstagramなどで使える生成AIスタンプと画像編集を可能に

Meta、画像生成モデル「Emu」でInstagramなどで使える生成AIスタンプと画像編集を可能に

Metaは、独自の画像生成モデル「Emu」と、それを採用するInstagramなどで使えるAIスタンプと画像編集機能を発表した。プロンプト入力から“数秒で”スタンプが生成される。 MetaのAI会話アシスタント「Meta AI」は「Quest 3」でも話せる セレブ版もあり

MetaのAI会話アシスタント「Meta AI」は「Quest 3」でも話せる セレブ版もあり

Metaはイベント「Meta Connect」で、メッセンジャー、Instagram、WhatsAppで利用できるAIチャットbot「Meta AI」を発表した。同日発表の「Quest 3」と「Rayban Metaスマートグラス」にも搭載する。パリス・ヒルトンなどが演じるキャラクター版も登場予定。 OpenAIの文→画像AI「DALL・E 3」、10月にChatGPT PlusとAPIで利用可能に

OpenAIの文→画像AI「DALL・E 3」、10月にChatGPT PlusとAPIで利用可能に

OpenAIは、文章から画像を生成するAIの次期版「DALL・E 3」を発表した。「ChatGPT Plus」と「ChatGPT Enterprise」のユーザーは、10月に利用可能になる。先代より長いプロンプトの理解力が大幅に高くなったとしている。 もう「テキストで動画編集」ができる時代に 試して分かったAIの進化っぷり

もう「テキストで動画編集」ができる時代に 試して分かったAIの進化っぷり

今ネット社会は、AIの進化に揺さぶられている。毎日画像生成AIで新しい画像が生み出され、次第に写真と見分けが付かなくなってきている。一方チャット系AIは検索補助ツールの領域を超えて、データ整形やアイデアツール、文書作成までこなせるようになった。この変化は動画編集にもおよんでいる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR