Apple、iPhone上でのLLM実行を可能にする手法の論文を発表

米Appleは12月12日(現地時間)、iPhoneのようなメモリ容量の限られた端末上でLLM(大規模言語モデル)を実行するための技術に関する論文「LLM in a flash:Efficient Large Language Model Inference with Limited Memory」を公開した(リンク先はPDF)。

タイトルを直訳すると「一瞬でLLM:限られたメモリでの効率的な大規模言語モデル推論」となるが、「LLM in the flash」はフラッシュメモリに収まるLLMという意味も含まれている。

Appleはメモリ容量が限られた端末上でLLMを実行するアプローチとして、この制約に合わせた推論コストモデルを開発することで革新的な手法を編み出したという。

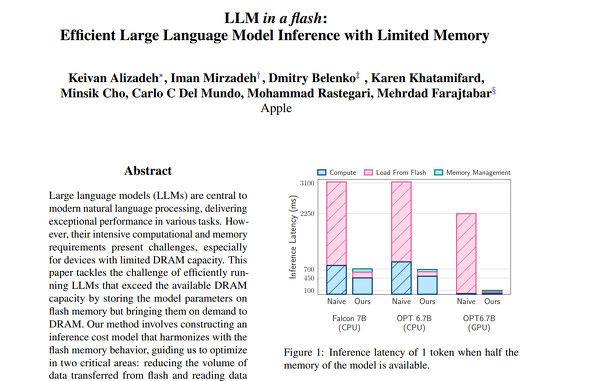

この手法を用いると利用可能なDRAMの最大2倍のサイズのLLMを実行でき、CPUでは従来の方法と比較して4〜5倍、GPUでは20〜25倍という推論速度の高速化を達成したとしている。

ティム・クックCEOは8月のCNBCのインタビューで、「研究ベースでは、生成系AIを含むAIと機械学習の研究を何年も行ってきた」と語ったが、AIチャットbotでは米OpenAI(のChatGPT)などに後れを取っている。

高性能なLLMは膨大な計算力を必要とし、基本的にクラウド上で稼働するが、Appleはユーザーのプライバシーを重視することもあり、サービスを端末側で完結させたい考えだ。

LLM in the flashの手法が実用化されれば、iPhoneで使えるChatGPTのようなチャットbotの提供が実現するかもしれない。

米Googleは6日に発表した生成AIモデル「Gemini」の最小モデル「Gemini Nano」を既に「Pixel 8 Pro」(の英語版)に搭載済みだ。

米Microsoftも13日、SLM(小規模言語モデル)の「Phi-2」をリリースした。

関連記事

Microsoft、Igniteで発表の小規模言語モデル「Phi-2」をAzureでリリース

Microsoft、Igniteで発表の小規模言語モデル「Phi-2」をAzureでリリース

Microsoftは、SLM(小規模言語モデル)の「Phi-2」をAzureでリリースした。27億パラメータだが、複数のベンチマークでMetaの「Llama 2」の700億パラメータモデルやGoogleの32億パラメータの「Gemini Nano 2」を上回った。 Pixel 8 Pro、生成AI「Gemini」が使える初のスマホに アップデートの配信スタート

Pixel 8 Pro、生成AI「Gemini」が使える初のスマホに アップデートの配信スタート

Googleが、発表したばかりの生成AI「Gemini」を「Pixel 8 Pro」に実装する。7日から日本を含むグローバルでアップデートの配信を開始しており、現時点では英語でのみ利用できる。 Appleは「何年も前から生成AIを研究している」 クックCEOが米CNBCのインタビューで語る

Appleは「何年も前から生成AIを研究している」 クックCEOが米CNBCのインタビューで語る

米Appleが発表した2023年度第3四半期決算に関して、米CNBCがティム・クックCEOへのインタビューを実施。そこで、Appleは何年も前から生成系AIに取り組んできたと語ったと伝えている。 AI一色にはならなかったWWDCでAppleが発表したAI関連まとめ

AI一色にはならなかったWWDCでAppleが発表したAI関連まとめ

AppleのWWDC 2023では、「生成AI」というバズワードはほぼ使われなかった。とはいえ、MRヘッドセットの「Persona」など幾つかの“機械学習”採用技術が発表された。本稿ではそれを簡単にまとめた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR