ITmedia NEWS >

企業・業界動向 >

1本の動画→8つの異なる視点で映像化 Stability AI、動画生成モデル「Stable Video 4D」発表

» 2024年07月26日 08時30分 公開

[ITmedia]

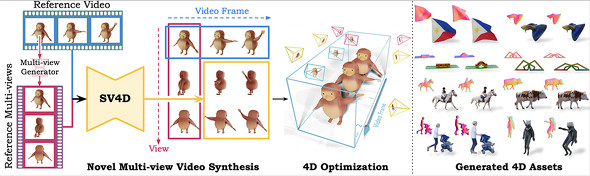

英Stability AIは7月25日、1つの動画から8つの異なる視点の動画を生成するAIモデル「Stable Video 4D」を発表した。現在Hugging Faceから利用できる。

Stable Video 4Dは、画像を動画に変換する「Stable Video Diffusion」モデルを基盤としている。ユーザーが1本の動画をアップロードし、任意の3Dカメラアングルを指定すると、8つの新しい視点の動画(5フレーム)を約40秒で生成する。

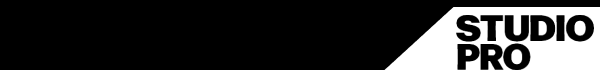

画像拡散モデル、動画拡散モデル、マルチビュー拡散モデルを組み合わせ、複数の新しい視点の動画を同時に生成可能。これにより、空間軸と時間軸の一貫性が大幅に向上するという。複数の視点とタイムスタンプで、オブジェクトの外観の一貫性を確保するだけでなく、複数の拡散モデルを使用する煩雑なスコア蒸留サンプリング(SDS)なしで、シンプルな4D最適化フレームワークを実現するとしている。

全体の4D最適化には約20〜25分かかるものの、既存のモデルと比較して、より詳細で入力動画に忠実な新しい視点の動画を生成できるという。同社は「画像ベースの動画生成から完全な3Dダイナミック動画合成へと移行する、私たちの能力における飛躍的な進歩を表している」とする。

Stability AIは、Stable Video 4Dの応用分野として、ゲーム開発、動画編集、VRなどを想定する。同社は現在モデルの改良に取り組んでおり、合成によるデータセットを超えて、より幅広い実世界の動画を扱えるよう最適化を進めているという。

関連記事

Stability AI、テキスト→動画の「Stable Video Diffusion」をGitHubで公開

Stability AI、テキスト→動画の「Stable Video Diffusion」をGitHubで公開

Stability AIは、テキストから動画を生成するAIモデル「Stable Video Diffusion」のリサーチプレビュー版をGitHubで公開した。テキスト入力のためのWebツールを入手するにはウェイティングリストに登録する必要がある。 画像生成AI「Stable Diffusion」開発会社、1億100万米ドルの資金調達 音声や動画モデルなど開発加速

画像生成AI「Stable Diffusion」開発会社、1億100万米ドルの資金調達 音声や動画モデルなど開発加速

画像生成AI「Stable Diffusion」の開発元でAIスタートアップ企業である英Stability AIは、1億100万米ドル(約150億円、1米ドル=149円換算)の資金調達をしたと発表した。 Stability AI、スケッチを高度な画像に変換する「Stable Doodle」無償公開

Stability AI、スケッチを高度な画像に変換する「Stable Doodle」無償公開

画像生成AI「Stable Diffusion」を手掛けるStability AIは、ラフなスケッチを高度な画像に変換する新ツール「Stable Doodle」を公開した。Webおよびモバイルアプリで利用可能だ。 話題の画像生成AI「Stable Diffusion」、ビジネスモデルは? 企業の利用状況は? 日本法人代表にいろいろ聞いてみた

話題の画像生成AI「Stable Diffusion」、ビジネスモデルは? 企業の利用状況は? 日本法人代表にいろいろ聞いてみた

画像生成AI「Stable Diffusion」開発元の日本法人代表ジェリー・チーさんに、企業での利用状況やビジネスモデル、クリエイターからの反応などについて、いろいろと聞いてみた。 Stability AI、テキストで作曲できる生成AI「Stable Audio」

Stability AI、テキストで作曲できる生成AI「Stable Audio」

Stabioity AIは、音楽生成AIモデル「Stable Audio」を公開した。Webアプリの無料版では、最長45秒のトラックを生成し、ダウンロードできる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR