ITmedia NEWS >

企業・業界動向 >

Google、「AIの倫理原則」を公開 武器など人に危害を加える利用はしないと約束

» 2018年06月08日 10時45分 公開

[佐藤由紀子,ITmedia]

米Googleは6月7日(現地時間)、AI(人工知能)に関する同社の取り組みのための原則を発表した。スンダー・ピチャイCEOは「AIのリーダーとして、われわれはAIの正しい扱いについて大きな責任を感じている。(中略)この原則は単なる理論的コンセプトではなく、われわれの研究開発および製品開発の方針を支配し、意思決定に影響を与える具体的な基準だ」と語った。

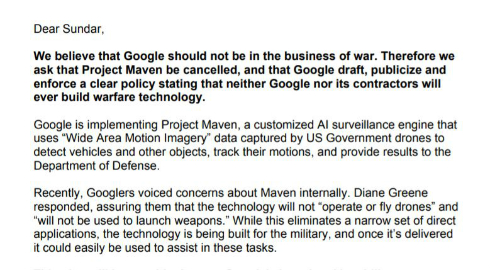

Googleは、同社が2017年9月に米国防総省(DoD)と契約した「Project Maven」への協力に関し、社内外から批判を浴びていた。この契約は、GoogleのAI技術と画像識技術をDoDに提供するというものだが、その技術は軍事ドローンに利用される可能性があるという。

4月には、Googleの3000人以上の従業員がこの契約に反対するピチャイCEOへの請願書に署名したと報じられた。

今回の原則発表はこうした批判を受けてのものだ。AI利用の原則として、以下の7項目を掲げた。

- 社会貢献できる利用

- 不公平な偏見を生む利用をしない

- 安全な開発とテスト

- 説明責任を果たす

- プライバシーの保護

- 研究成果や知識の共有

- 有害となる可能性のある利用の制限

また、AIを利用しない4つの領域を明示した。

- 全体的な害を引き起こす可能性のある技術

- 人間に危害を与えることを目的とした武器その他の関連技術

- 国際的なプライバシー規範に反する監視のために情報を収集・利用する技術

- 国際法と人権に関する原則に反する目的を持つ技術

DoDとの契約の責任者でGoogle CloudのCEOであるダイアン・グリーン氏は同日、「Google Cloudを含むGoogleは、武器化したシステムへのAI利用を支援しない」と宣言した。ただし、Project Mavenの契約は更新はしないが破棄もしない。また、サイバーセキュリティ、生産性ツール、医療などについては今後も政府機関と協力していくとしている。

関連記事

Google、AIによる予約電話代行への批判に「AIだと名乗らせる」と説明

Google、AIによる予約電話代行への批判に「AIだと名乗らせる」と説明

GoogleがI/Oで披露したAIアシスタントによる電話応対デモが人間と区別がつかなすぎるという批判を受け、公開の際はAIだと分かるようにすると説明した。 Google I/O 2018基調講演まとめ AIのある快適な暮らし

Google I/O 2018基調講演まとめ AIのある快適な暮らし

Googleの年次開発者会議「Google I/O 2018」の基調講演で発表されたことをまとめた。GoogleアシスタントやAndroid Pなど、AI中心のデモが多かった。 GoogleとVerily、ディープラーニングと網膜眼底画像による心血管リスク予測法を発表

GoogleとVerily、ディープラーニングと網膜眼底画像による心血管リスク予測法を発表

Googleと系列の生命科学企業Verilyが、網膜眼底画像から心血管リスクを予測するためのディープラーニングモデルを開発した。心筋梗塞や脳卒中などをCTスキャンなどの検査なしで早期発見できるとしている。 Facebook、Google、Microsoft、Amazon、IBMがAI(人工知能)団体設立

Facebook、Google、Microsoft、Amazon、IBMがAI(人工知能)団体設立

人工知能(AI)に取り組む大手5社がAIの普及とベストプラクティス共有を目的とする非営利団体「Partnership on AI」を立ち上げ、関連企業や専門家に協力を呼び掛けた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR