NVIDIA製GPUの数十倍速い? 次々に出てくる「AI専用チップ」とは何者か 識者に聞く高速化の仕組み(3/3 ページ)

──トランスフォーマーの特徴は、ハードウェア設計にどのような影響を与えるのでしょうか?

椎橋:トランスフォーマーモデルの特性は、従来のGPUで効率的に処理するのが難しい面があります。

トランスフォーマーの処理はRNNと比較するとGPUの計算に向いているものの、先ほど説明したように複雑に絡み合っているため、単純な並列計算に持ち込むのが難しいのです。

また、GPUとメモリの間でデータをやりとりする回数が多くなります。トランスフォーマーモデルの処理では、入力されたデータをメモリに置いて、それを何度も参照しながら計算を行います。そのため、メモリアクセスと演算処理の切り替えが頻繁に発生します。これは処理効率を下げる要因になります。

このような特性に対応するため、トランスフォーマーモデルに最適化されたハードウェア設計が重要になってきています。

その鍵となる基本的な考え方は、ハードウェア(チップ)が実行できる計算処理(命令セット)をそのモデルアーキテクチャの処理に必要な種類の計算に絞って、それぞれの種類の計算をする処理ユニットをちょうど良いバランスでそろえて配置することです。

手工業に例えるならば、CPUはどんな作業でもこなせる多能工が1人でいろいろな製品を作っている状態、GPUはどんな作業でもこなせる多能工が複数人で並行していろいろなパーツを作り組み立てている状態です。作りたい製品が多様な場合は効果的な方法ですが、作りたい製品と組み立てのプロセスが決まっている場合、これは非効率なやり方です。

ではどうしたらいいか。それは、必要な各作業に特化した単能工をそれぞれちょうど良い人数をそろえて、作業分担をする形で配置し、流れ作業のラインを作ることです。

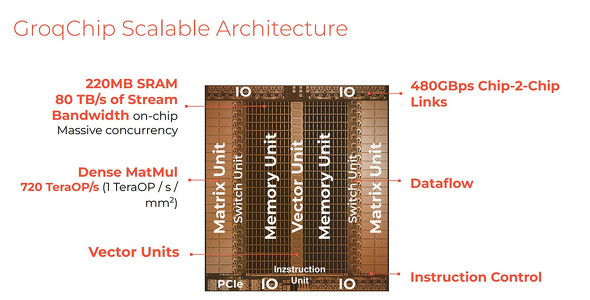

先ほど述べたGroqのLPUは、その仕組みに「Tensor Streaming Processor」、つまり言語モデルの処理の中心になる行列(テンソル)のいくつかの種類の計算をユニット化して、ユニット間で処理データを受け渡していく流れ作業(ストリーミング)にする、という考え方を採用することで、言語モデルの推論の大幅な高速化を実現しています。

Groqチップのアーキテクチャ。やりたいことを言語モデルの処理に絞れば、「Matrix Unit=密行列の掛け算をする部分」「switch unit=データを流す処理の部分」「メモリ」「Vector Unit=ベクトルの計算を扱う部分」のようにシンプルな処理ユニットの種類を作って並べることができる

Groqチップのアーキテクチャ。やりたいことを言語モデルの処理に絞れば、「Matrix Unit=密行列の掛け算をする部分」「switch unit=データを流す処理の部分」「メモリ」「Vector Unit=ベクトルの計算を扱う部分」のようにシンプルな処理ユニットの種類を作って並べることができるまた、大胆にトランスフォーマーアーキテクチャのみに照準を定めるEtchedのSohuは、さらに細かくトランスフォーマーの計算処理プロセスにピッタリ合わせた計算ユニットの設計と配置を行いました。トランスフォーマーの処理であれば、従来GPUが計算リソースの30%程度しか有効に稼働させられていなかったところを、90%以上の稼働を実現しているとうたっています。

Sohuは、Llama70Bのスループットで毎秒50万トークンを超え、現在の主流GPUであるH100に比べて20倍の速さ、NVIDIAの次世代GPUであるBlackwell(B200)に比べても桁違いに高速で安価になることを狙っている

Sohuは、Llama70Bのスループットで毎秒50万トークンを超え、現在の主流GPUであるH100に比べて20倍の速さ、NVIDIAの次世代GPUであるBlackwell(B200)に比べても桁違いに高速で安価になることを狙っている──トランスフォーマーモデルに特化したハードウェアには課題はありませんか?

椎橋:最大の課題は汎用性の低さです。トランスフォーマーモデルに最適化されたハードウェアは、他タイプのAIモデルをそもそも実行できなかったり、実行できても効率が大きく低下する可能性があります。

また、AIのアーキテクチャは急速に進化しています。例えば、最近では米MicrosoftのRetentive Networkや、画像処理分野でのMamba(選択的状態空間モデル)など、トランスフォーマー以外の新しいアーキテクチャも登場しています。特定のアーキテクチャに過度に最適化されたハードウェアは、新しいモデルが登場した際に陳腐化するリスクがあります。さらに、トランスフォーマーモデル自体も進化を続けています。ハードウェアの開発サイクルはソフトウェアよりも長いため、最新のモデルの特性に常に対応し続けることは難しい課題です。

ただ、こういった課題がある一方で、可能性もあります。トランスフォーマー向けASICがある程度普及すると、ハードウェアも含めて考えた場合、中期的にはトランスフォーマーモデルの方が有利な状況が続くかもしれません。

なぜかというと、現在のトランスフォーマーアーキテクチャは、特に大規模言語モデルの分野でほぼ独占状態にあるからです。そこにトランスフォーマー向けASICが普及すると、ソフトウェアの効率だけで見れば優れた新モデルが登場しても、ハードウェアも含めて考えるとトランスフォーマーの方が全体的に性能が良いという状況が生まれるかもしれないからです。この相互作用が、トランスフォーマーモデルの優位性をさらに強化する可能性があるのです。

AIチップで垂直統合のアプローチが増える?

これまでのコンピュータ産業、特にソフトウェア産業は、水平分業によって急速な発展を遂げてきた。ハードウェアとソフトウェアを分離することで、それぞれの分野で専門性を高め、イノベーションを加速させてきたのである。しかし、AIの世界では状況が少し異なるようだ。大規模な言語モデルの学習や推論には膨大な演算能力が必要で、エネルギー効率も重要な課題となっている。このリソースの制約に対処するためには、ハードウェアとソフトウェアを緊密に連携させる必要があるからだ。

そのため、AIチップの開発では、従来の水平分業よりも、ソフトウェアとハードウェアをすり合わせた垂直統合型のアプローチが増えていく可能性がある。これは、製造業における「すり合わせ」の文化を持つ日本にとって、新たな機会となるかもしれない。自動車産業や産業用ロボットなど、日本が強みを持つ分野でのAI応用と組み合わせることで、日本の半導体産業が再び世界で競争力を持つ可能性もあるだろう。

関連記事

生成AIでGPUがいらなくなる? 業界を揺るがす「1ビットLLM」とは何か、識者に聞いた

生成AIでGPUがいらなくなる? 業界を揺るがす「1ビットLLM」とは何か、識者に聞いた

米Microsoftの研究チームが発表した「BitNet」、通称「1bit LLM」と呼ばれる論文が波紋を呼んでいる。これまで必須だと思われていたGPUが不要で、CPUでもLLMが動作することを示唆している。そもそも“1bit”とは何が1bitなのか、どうして1bitになるとGPUが不要になるのか、AIソリューションの開発・提供を行うLaboro.AIの椎橋徹夫CEOに聞いた。 「GPT-4o」は何がすごい? なぜLLMは画像や音声も扱えるの? “マルチモーダル”について識者に聞いた

「GPT-4o」は何がすごい? なぜLLMは画像や音声も扱えるの? “マルチモーダル”について識者に聞いた

米OpenAIが5月に発表した生成AIモデル「GPT-4o」。テキストだけでなく音声や画像も扱えるマルチモーダルモデルとして、その特徴が注目を集めている。GPT-4oは従来のLLMと何が違うのか、そもそもマルチモーダルとは何を意味するのか。AIの専門家に解説してもらった。 Microsoft、AI最適化チップ「Azure Maia 100」と汎用Armチップ「Azure Cobalt」

Microsoft、AI最適化チップ「Azure Maia 100」と汎用Armチップ「Azure Cobalt」

Microsoftは2つのカスタム設計チップ、AIに最適化した「Maia 100」とArumベースの汎用「Cobalt 100」を発表した。「インフラストラクチャスタックのすべての層を最適化して統合することが重要」とガスリー氏。 Google、Armベースの初カスタムCPU「Axion」発表 今年後半に提供へ

Google、Armベースの初カスタムCPU「Axion」発表 今年後半に提供へ

Googleは年次イベント「Google Cloud Next」で、同社初となるArmベースのカスタムCPU「Google Axion」を発表した。生成AIのトレーニングと推論に最適としており、今年後半に顧客への提供を開始する計画。 Meta、自社開発AIチップ「MTIA」の第2世代を発表 先代の3倍性能

Meta、自社開発AIチップ「MTIA」の第2世代を発表 先代の3倍性能

Metaは自社開発のAIチップ「MTIA」の第2世代を発表した。4つの主要モデルで先代と比較して性能が3倍向上したとしている。Facebookなどでの広告レコメンデーション機能の強化などに活用する計画。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.