Google DeepMind、「Gemini Robotics」でAIを現実世界へ

米Google傘下のGoogle DeepMindは3月12日(現地時間)、ロボットが物理的な世界で、より効果的に行動できるよう設計されたAIモデル「Gemini Robotics」を発表した。Gemini 2.0を基盤とし、視覚、言語理解、物理的な動作を統合し、様々なタスクを実行できる。

まだ実験段階で一般には公開していないが、韓国Hyundai Motor Group傘下のBoston Dynamicsなどの企業がテスターとして開発に参加している。

Gemini Roboticsは、現実世界で行動する能力をロボットに与えることを目指す。学習していない未知の状況や物体、複雑な指示、新しい環境にも対応でき、ロボットにインタラクティブ性を持たせる。

DeepMindはまた、「複雑で動的な世界を理解する」ことができる高度な視覚言語モデル「Gemini Robotics-ER」も発表した。こちらもGemini 2.0ベースで、マルチモーダルな推論能力を物理世界に拡張し、特に空間的および時間的な理解を強化することを目的とする。

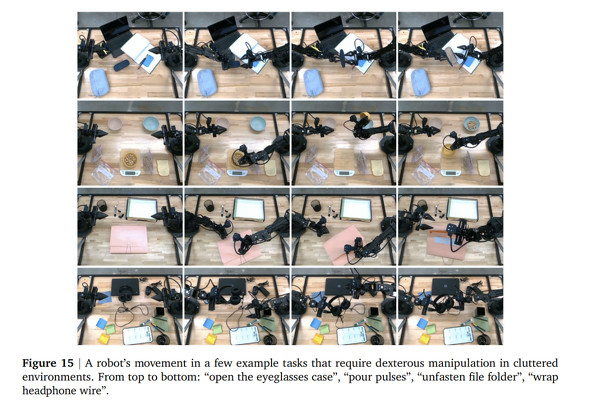

Gemini Roboticsについては、例えば、メガネケースを開けたり、ヘッドホンのコードを巻く、弁当箱におかずを詰める、折り紙で狐を折るといった動作のデモが紹介されている。

Gemini Robotics-ERでは、空間理解能力を示すデモとして、コーヒーカップを見せられた際に、取っ手をつかむための適切な二本指の把持と安全な接近軌道を直感的に理解できる例が紹介されている。

DeepMindは公式YouTubeチャンネルで、多数のデモ動画を公開した。

DeepMindは、これらの開発では、安全性が重要だとし、Google AIの倫理原則に沿って責任ある開発を進めているとしている。ロボットが物理世界で行動するという性質上、テキストや画像などのデジタル領域のAIモデルとは異なる、特別な安全性の考慮が必要だと強調した。

関連記事

Google、「Project Astra」を向こう数カ月中にGeminiアプリに導入へ

Google、「Project Astra」を向こう数カ月中にGeminiアプリに導入へ

Googleは、現実世界でマルチモーダル理解を活用するエージェント「Project Astra」を、向こう数カ月でAndroidおよび「Samsung Galaxy S25」のGeminiアプリに導入する予定だと発表した。 Google DeepMind、インタラクティブな3D世界を作るAI「Genie 2」発表

Google DeepMind、インタラクティブな3D世界を作るAI「Genie 2」発表

Google DeepMindは、テキストや画像からインタラクティブな3D世界を生成する基盤世界モデル「Genie 2」を発表した。現実世界では危険なタスクを含む状況でのAIエージェントのトレーニングやゲーム開発に応用できるとしている。 Google DeepMind、卓球ロボットを開発 アマチュアになら勝てるレベル

Google DeepMind、卓球ロボットを開発 アマチュアになら勝てるレベル

Google DeepMindは、競技卓球でアマチュアレベルの能力を発揮するロボットを開発したと発表した。初級〜上級の人間29人と対戦し、13勝した。 Google DeepMind、ロボットの行動を改善する新VLAモデル「RT-2」発表

Google DeepMind、ロボットの行動を改善する新VLAモデル「RT-2」発表

Google DeepMindは、ロボットのアクションを直接出力できるVLAモデル「RT-2」を発表した。Web上のテキストと画像でトレーニングされており、ロボットは直接学習していない物体や概念についての命令を実行できるようになる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.