Googleの「Gemini」に、ロボット向け新モデル 自律的にタスクを分解して動作、“雑な指示”にも対応

米Googleは9月26日(日本時間)、ロボット向けのAIモデル「Gemini Robotics 1.5」と「Gemini Robotics-ER 1.5」を発表した。同社のLLM「Gemini」の技術を活用しており、同社が3月に発表したロボット向けAIモデルの後継モデルに当たる。複雑な手順が必要なタスクに対し、自律的にタスクを分解してロボットを駆動できるという。

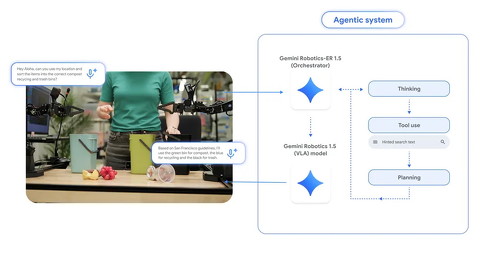

Gemini Robotics 1.5は、視覚・言語情報をもとにロボットを動かす「VLA」(Vision Language Action)モデル。一方、Gemini Robotics-ER 1.5は、視覚・言語情報を統合的に処理する「VLM」(Vision Language Model)となっている。

ロボットを動かす際は、Gemini Robotics 1.5とGemini Robotics-ER 1.5を組み合わせて利用する。人から指示を受けると、まずGemini Robotics-ER 1.5が、物理的な世界についての推論や、Web検索などのツールを活用し、タスクの計画を策定する。次にGemini Robotics 1.5がこの計画に基づき、タスクを細かいアクションに分解し、段階的に実行する。

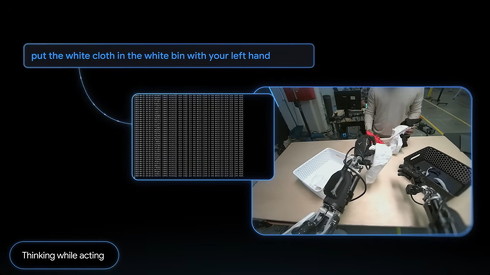

例えば「洗濯物を色分けして」という指示を受けると、Gemini Robotics 1.5は「まず、『色分け』とは白い服は白いカゴへ、それ以外の色の服は黒いカゴへ入れることだと、タスク全体の目的を理解する。次に、『赤いセーターを拾い上げ、黒いカゴに入れる』といった具体的なステップを考え、さらには『セーターをつかみやすくするために、一度手前に引き寄せる』など、各ステップを実行するための細かな動作レベルまで考える」(Google)

また、同モデルは、異なるロボットの機体を動かす性能にも優れているという。ロボットアーム「ALOHA 2」で学習した動きを、ロボット企業である米Apptronikの人型ロボット「Apollo」などでも再現できたとしている。

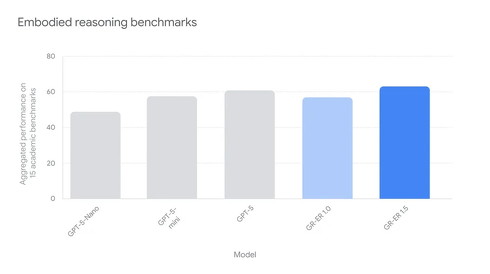

一方、Gemini Robotics-ER 1.5は、物理的な状況に基づく推論性能が高いといい、Googleが用意したベンチマーク「Embodied Reasoning Question Answering 」では、米OpenAIのAIモデル「GPT-5」などを上回るスコアを獲得したとアピールしている。

Gemini Robotics-ER 1.5は同日から、Googleが提供する開発者向けプラットフォーム「Google AI Studio」で提供する。Gemini Robotics 1.5は、Googleの一部のパートナー企業向けに提供中。

関連記事

“ヒューマノイドCEO”爆誕 GMO、熊谷代表を模した人型ロボ開発 会議の代理出席や、1on1での利用視野

“ヒューマノイドCEO”爆誕 GMO、熊谷代表を模した人型ロボ開発 会議の代理出席や、1on1での利用視野

GMOインターネットグループは、熊谷正寿代表を模した人型ロボット「ヒューマノイド 熊谷正寿」を開発したと発表した。 Unitreeの人型ロボ、「反重力」モードを習得 蹴り倒されても、即座に立ち上がる 「安定性が大幅に向上」

Unitreeの人型ロボ、「反重力」モードを習得 蹴り倒されても、即座に立ち上がる 「安定性が大幅に向上」

中国ロボット企業Unitree Roboticsは、人型ロボット「G1」に、動作時の体勢の安定性を高める機能「反重力」モードを追加したと発表した。同日に公開したデモ動画では、人に蹴り倒されたUnitree G1が、素早く立ち上がる姿などを確認できる。 「使徒みたい」と話題、4本腕ロボ「HL-ZERO」はなぜあの見た目に? 万博で製作陣に聞いてきた

「使徒みたい」と話題、4本腕ロボ「HL-ZERO」はなぜあの見た目に? 万博で製作陣に聞いてきた

そのビジュアルがXで大きく話題になった4本腕の人型ロボット「HL-ZERO」。腕の数や神秘的な雰囲気には、しっかりとした意図があるという。 薬局の受付、AIロボで自動化 外出から戻った患者も自動対応 日本調剤が導入

薬局の受付、AIロボで自動化 外出から戻った患者も自動対応 日本調剤が導入

日本調剤は、AIが自動で受付するシステムを、南小岩薬局に導入した。 日本発、4本腕の人型ロボット登場 高さ約4m、空気で膨らむ外装を金属骨格で動かす 万博で公開へ

日本発、4本腕の人型ロボット登場 高さ約4m、空気で膨らむ外装を金属骨格で動かす 万博で公開へ

ロボット制御システムの開発などを手掛けるアスラテックは、4本腕の人型ロボット「HL-ZERO」を開発したと発表した。身長は約4mで、空気で膨らむ外装を金属の骨組みで動かす仕組みを採用。大阪・関西万博で公開予定。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.